智源团队Aquila2-34B双语对话模型推出Int4量化版本

站长网2023-10-24 21:25:100阅

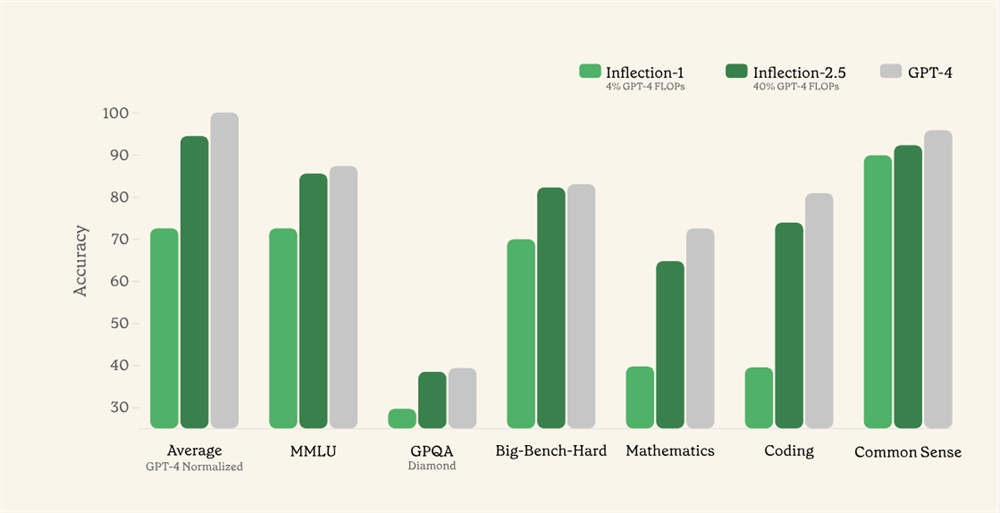

智源团队最近发布了中英双语基础模型 Aquila2-34B 和中英双语对话模型 AquilaChat2-34B。这两个模型在中英双语主 / 客观综合评测中表现优秀,超过了其他全球开源模型,包括 LLama-70B 等。

同时,Aquila2-34B 在多项推理评测中超越了 LLama2-70B 和 GPT3.5模型,仅次于 GPT4。

为了降低使用大模型的门槛,智源 Aquila 团队将 Int4量化技术和 QLoRA 微调推理技术整合到 AquilaChat2系列模型中,从而显著降低了34B 级别大模型的训练和推理所需的资源。

经过 Int4量化,AquilaChat2-34B 模型能够用7B 量级模型相近的 GPU 资源消耗,提供超过 Llama2-70B 模型的性能。QLoRA 技术将量化技术与 LoRA 微调技术相结合,通过4位量化和 Low Rank Adapters (LoRA) 方法进行微调,从而实现在不损失模型性能的情况下节省内存和提高训练速度。

据悉,Aquila2-34B 系列模型已经在国产芯片上进行了适配,并成功进行了推理。通过使用 Int4量化和 QLoRA 微调技术,用户可以在低资源环境中运行大参数模型。

项目地址:

https://github.com/FlagAI-Open/Aquila2/blob/main/examples/predict_chat_quantize.py

0000

评论列表

共(0)条相关推荐

2023特斯拉股东大会召开 马斯克:正在开发两款全新车型

特斯拉CEO马斯克今日凌晨在2023年的股东大会上宣布,特斯拉正在开发两款全新的车型,并计划达到超过500万辆的产量,同时,马斯克还放出了新车型的轮廓。此外,他还表示,预测ModelY将成为2023年全球销量最高的汽车。但4680电池开始大规模生产还需要时间,特斯拉的生产目标是达到每年2000万辆。在会上,马斯克还强调,他不会卸任特斯拉CEO。站长网2023-05-17 08:32:140000马斯克脑机接口获批首次人体试验 公司估值翻3倍

最新报道称,马斯克旗下的脑机接口公司Neuralink的估值已经飙升到了50亿美元,自去年获得FDA批准进行人体临床研究以来,其价值已经翻了近三倍。Neuralink成立于2016年,虽然最近没有进行融资活动,但其价值已经大幅上涨。马斯克计划通过植入芯片与计算机建立联系,以增强人类大脑的计算和记忆能力,治疗多种相关疾病。站长网2023-06-13 14:07:550000一个电工的十八年:在厨房、在工厂、在互联网

“家里到处都有电,师傅快来!”面对焦急的工厂老板、害怕的人们,他身着工装,手拿电笔,反复排查电路故障,直至问题解决。这是@城阳电工电路的工作日常,他将其用短视频的形式记录下来,并以@城阳电工电路的账号发在各平台。截至目前,@城阳电工电路全网粉丝已近千万。从业十八年,他不仅维修了无数电路,还通过互联网,为千万网友做了用电科普。站长网2023-12-04 11:56:080000美国呼吁志愿者专家帮助解决生成式 AI 风险 成立新的 NIST 人工智能公众工作组

美国正在寻求合格公众的帮助,以了解如何抓住机遇并克服与生成人工智能相关的挑战。美国商务部部长GinaRaimondo宣布,美国国家标准与技术研究院(NIST)将成立一个公众工作组,研究能够生成内容的人工智能技术,包括文本、图像、视频、音乐和代码。该工作组还将协助该机构制定相关指南,以帮助组织应对生成式人工智能技术带来的风险。站长网2023-06-26 12:31:590004微软工程师向美国官员和公司董事会发警告:AI图像生成器存在潜在风险

**划重点:**1.🤖微软工程师发警报:公司的人工智能图像生成器工具可能轻易生成冒犯和有害图像。2.📄工程师致信美国监管机构和微软董事会,敦促采取行动,揭示产品安全隐患。3.🌐问题源于Designer工具,可能生成包含不当内容的图像,引发安全和道德争议。站长网2024-03-07 15:18:420000