Together AI发布RedPajama v2:包内30万亿token数据集,用于训练大型语言模型

划重点:

📌 高质量数据对于像Llama、Mistral、Falcon、MPT和RedPajama等最先进的开放式LLM的成功至关重要。

📌 Together.ai的研究人员发布了RedPajama-1T,这是一个5TB的数据集,拥有1万亿高质量英语token,而RedPajama-V2则是一个30万亿token的在线数据集。

📌 这个数据集的构建强调了对CommonCrawl的覆盖,包括原始数据、高质量注释和去重集群,为LLM的培训提供了有力的基础。

Together AI最近发布了RedPajama v2,这是一个庞大的在线数据集,包含了30万亿token,成为目前公开可用的最大数据集之一,专门用于学习型机器学习系统的培训。

对于像Llama、Mistral、Falcon、MPT和RedPajama等最先进的开放式LLM,高质量的数据至关重要,但由于HTML到纯文本的转换引发的异常、通常质量较低的数据来源以及网络内容传播中固有的偏见,这些数据未经精细处理,不适合直接用于LLM的培训。因此,获取正确的数据集和数据混合是一项耗时、资源丰富且昂贵的任务。

注:图片来自项目官网

此前,Together.ai的研究人员已经发布了RedPajama-1T,这是一个5TB的数据集,其中包含了1万亿高质量的英语token,但他们并未止步于此。RedPajama-V2是它的继续,构建了一个30万亿token的在线数据集。

研究团队认为,RedPajama-Data-v2将为LLM培训提供一个在线数据的存储库,可用作提取高质量数据集的基础,并为深入研究LLM培训数据提供基础。值得注意的是,RedPajama-V2强调了对CommonCrawl的覆盖,包括84个已处理的抓取数据,而且还包括了40多个高质量注释,这些注释是通过多个ML分类器对数据质量、minhash结果等进行的,可用于模糊去重或启发式操作。LLM开发者可以使用这些注释来快速轻松地生成自己的自定义预训练数据集,通过切片和筛选公开可用的数据。

RedPajama-V2的主要焦点是CommonCrawl,它是从头开始构建的,使用了84个CommonCrawl的抓取数据和其他公开可用的网络数据。该数据集包括原始数据(纯文本)、40多个高质量注释和去重集群。为了保持尽可能多的数据原始性,并让模型构建者在流水线中进行自己的筛选和重新加权,每个CommonCrawl快照都首先经过CCNet流水线的处理。同时,研究人员还计算了40多个最流行的高质量注释,以及由CCNet处理的文本文档。这些注释的主要目标是促进对其最佳用法的研究,并使下游模型开发者能够根据自己的标准对数据集进行筛选或重新加权。此外,他们还希望随着社区的帮助,逐渐添加更多的高质量信号。

RedPajama-V2包括了1130亿份文档,涵盖了英语、德语、法语、西班牙语和意大利语,是通过处理84个CommonCrawl抓取数据而获得的。尽管去重后,头部和中部分区的文档和token数量减少了60%,但文档数量减少了71%,这表明尾部的文档通常较短。使用Bloom过滤器对头部和中部文档进行去重后,数据集减少了大约40%。文本文档占据了数据集的大部分内容,包括高质量注释和去重集群,其布局与CCNet规定的非常相似。

研究团队希望很快扩展他们目前的高质量注释集,包括与广泛使用的LLM基准相比的污染注释、每个文档的主题建模和分类注释,以及引起社区兴趣的其他注释。这一工作将为LLM领域的研究和应用提供更多的有力数据支持。

https://github.com/togethercomputer/RedPajama-Data

创新AI助手AIChat:上千款AI模型免费用

AIChat是一款极为强大的AI人工智能助手,它不仅能够回答各种问题,还具备多种自动创作能力,包括写论文、小说、代码、文案等。它可以模拟各种角色与用户互动,讲故事、陪聊天,并提供各种建议,功能异常全面。官网地址:https://dmla.lanzouy.com/b05q8v0qh其亮点包括:简便易用:用户只需在主页输入问题,即可获得实时回答,提供一站式解决服务。站长网2023-09-20 16:13:420000从直播开蚌,到单月销售额破2亿:泼天的富贵,这次轮到了“珍珠”头上

都说时尚是个轮回,今年的大爆款轮到了“珍珠”头上。一石激起千层浪,有着“珍珠小镇”之称的浙江省诸暨市山下湖镇,从未像现在这样忙碌过。随着大批背包客的涌入,不但小镇上的住宿价格飙升至千元,甚至连厕所都挤满了人,成交额更是创下新高,屡屡出现“一珠难求”的场面。▲图/网友供图站长网2023-10-10 10:56:290000加州参议员提交法案,禁止政府与不道德的 AI 公司合作

划重点:-📝加州参议员提交了两项法案,旨在规范人工智能系统的使用,特别是州政府机构使用的系统。-📝第一项法案要求加州科技部门制定人工智能服务的安全、隐私和非歧视标准,并禁止州政府与不符合这些标准的供应商合作。-📝第二项法案将建立加州人工智能研究中心,为学者提供计算资源和数据。0000微软、OpenAI 和 Cohere 等公司已转向使用合成数据训练人工智能模型

人工智能公司Cohere的首席执行官AidenGomez表示,合成数据已经被用来训练人工智能模型。由于Reddit和Twitter等公司对于其他公司抓取其数据收费高昂,微软、OpenAI和Cohere等AI公司正在转向合成数据。站长网2023-07-20 17:17:190000从餐巾纸的故事说起,聊聊张朝阳当物理网红这两年

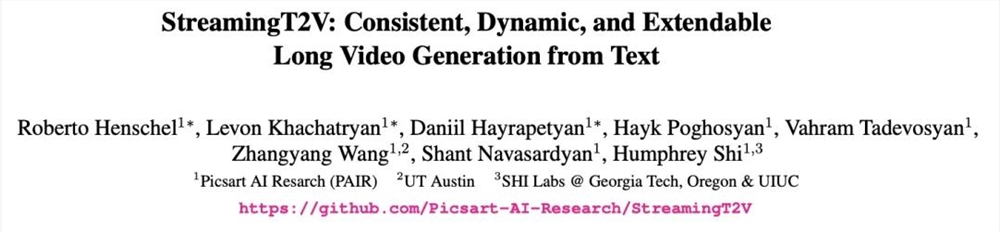

网红似乎更多和草根挂钩,很少有大佬喜欢这个词。不过,张朝阳并不排斥网红的称呼。他一直都有着鲜明的个人特色,这几年更是屡屡破圈,身份标签还多了个“物理网红”。前几天在乌镇世界互联网大会期间,张朝阳说网红这个词特别好,网红是时代的产物。而且,张朝阳直播了好几年,很多事情都是自己亲手做的。站长网2023-11-23 12:14:110000