高分辨率AI模型Griffon v2:通过文本和视觉提示提供灵活的对象引用

划重点:

🔍 最近,大型视觉语言模型(LVLMs)在需要文本和图像理解的任务中表现出色。

🚀 团队引入了Griffon v2,这是一种统一的高分辨率模型,旨在通过文本和视觉线索提供灵活的对象引用。

🌟 Griffon v2在引用表达生成(REG)、短语定位和引用表达理解(REC)等任务中表现出色。

近来,大型视觉语言模型(LVLMs)在需要文本和图像理解的任务中表现出色。特别是在区域级任务,如引用表达理解(REC)中,经过图像文本理解和推理的发展之后,这一进展变得明显。诸如Griffon之类的模型在任务中表现出色,如目标检测,这表明了LVLMs内部感知的重大进步。这一发展推动了对使用文本描述之外的灵活引用进行额外研究,以改善用户界面。

尽管在细粒度对象感知方面取得了巨大进步,但由于图片分辨率的限制,LVLMs无法在复杂情景中胜过任务特定的专家。这一限制限制了它们在使用文本和视觉线索有效引用事物的能力,尤其是在GUI代理和计数活动等领域。

为了克服这一限制,一组研究人员引入了Griffon v2,这是一种统一的高分辨率模型,旨在通过文本和视觉线索提供灵活的对象引用。为了解决有效增加图像分辨率的问题,他们提出了一个简单且轻量级的降采样投影仪。这个投影仪的设计目标是克服大型语言模型输入标记所施加的限制。

这一方法通过保留细微特征和整个上下文,特别是对于低分辨率模型可能错过的小事物,极大地提高了多模态感知能力。团队基于这一基础构建了一个即插即用的视觉标记器,并将Griffon v2增强为具有视觉语言共指能力。这一特性使得可以以一种易于使用的方式与各种输入进行交互,例如坐标、自由文本和灵活的目标图片。

Griffon v2在各种任务中都被证明是有效的,如引用表达生成(REG)、短语定位和引用表达理解(REC),根据实验数据显示,该模型在目标检测和对象计数方面表现优于专家模型。

该团队总结了他们的主要贡献如下:

- 高分辨率多模态感知模型:通过消除对图像进行分割的要求,该模型提供了一种改进本地理解的独特方法。该模型处理分辨率高达1K的能力已经提高了其捕捉细节的能力。

- 视觉-语言共指结构:为了扩展模型的效用并启用多种交互模式,引入了一个将语言和视觉输入结合起来的共指结构。这一特性使用户与模型之间的交流更加灵活自然。

为了验证模型在各种定位任务上的有效性,进行了大量实验。在短语定位、引用表达生成(REG)和引用表达理解(REC)中,都获得了最先进的性能。该模型在定量和定性目标计数方面均优于专家模型,证明了其在感知和理解方面的优越性。

项目入口:https://github.com/jefferyZhan/Griffon

论文地址:https://arxiv.org/abs/2403.09333

Uber 正在开发一款人工智能驱动的聊天机器人以集成到应用程序中

站长之家(ChinaZ.com)8月3日消息:优步(Uber)正在开发一款基于人工智能的聊天机器人,以集成到其应用程序中。这使得Uber加入了那些利用语言工具来改善客户服务、营销和其他自动化任务的公司的行列中。站长网2023-08-03 14:07:230002近半年看到的最创新的虚拟社交App,没有之一

除了人物位移、Avatar系统、基于距离的语音互动这些虚拟社交产品的基础配置,ParaSpace的神奇之处在于允许用户“一键克隆自己附近用户的Avatar”,一个申请、一个同意,用户便可以立即免费获得对方的全部装扮。帮助用户创建第二身份的App不在少数、克隆用户现实形象的App也有存在,但像ParaSpace直接让用户成为想成为的任何人的产品确实并不多。站长网2023-10-10 09:08:530000钉钉 AI 魔法棒正式上线 所有功能开放测试

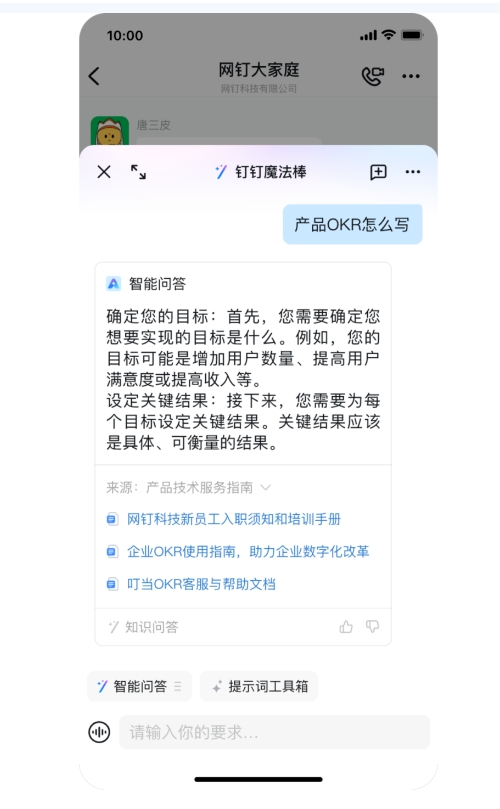

钉钉AI魔法棒正式上线,包含17个产品线、60多个场景和近百种AI技能,全面开放测试。用户可以通过钉钉的首页右上角的“魔法棒”入口或各个产品页面的魔法棒按钮使用钉钉AI。钉钉AI魔法棒的一大特点是统一的LUI交互入口,通过自然语言对话的方式实现各类场景和应用的交互。站长网2023-11-03 14:07:050000广电总局:互联网电视应用启动时间应不大于5秒

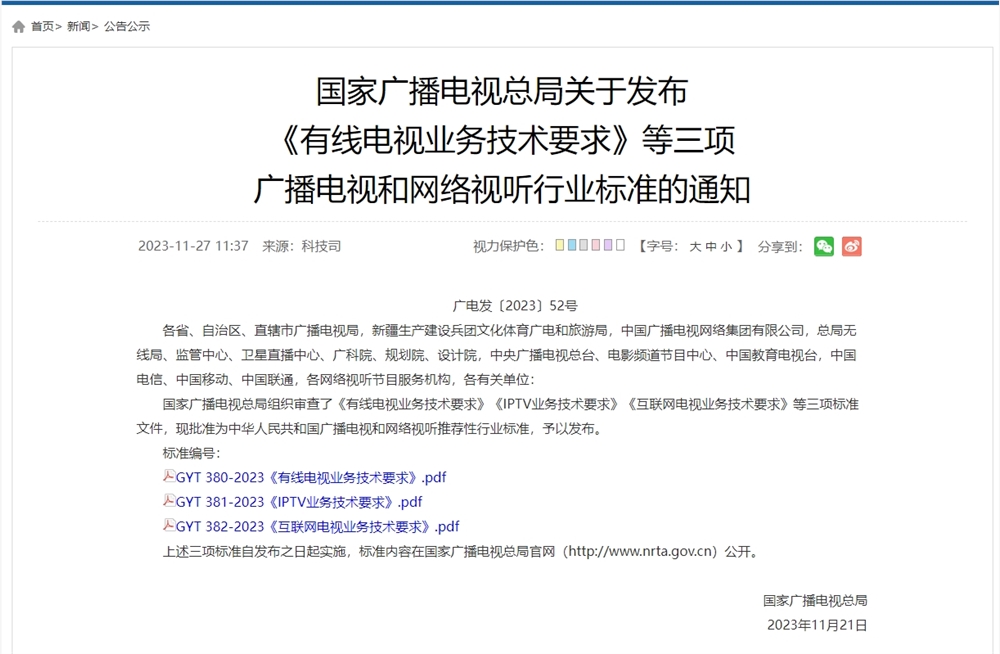

今日,国家广播电视总局组织审查了《有线电视业务技术要求》《IPTV业务技术要求》《互联网电视业务技术要求》等三项标准文件,现批准为中华人民共和国广播电视和网络视听推荐性行业标准,予以发布。其中,《互联网电视业务技术要求》表示,互联网电视应用启动时间宜小于3s,应不大于5s。站长网2023-11-27 13:56:370000美国初创公司使用太阳能人工智能传感器提前检测野火

文章概要:1.DryadNetworks开发了太阳能传感器,可以检测空气中的气体变化,早期发现野火。2.传感器使用机器学习技术,可以减少误报率。3.传感器已在欧美部分地区部署,Dryad正在扩大业务规模。美国初创企业DryadNetworks开发了一种太阳能供电的人工智能气体传感器,可以提前检测到森林火灾。站长网2023-08-28 15:34:010000