英伟达与 Anyscale 合作:提高大型语言模型和生成式 AI 应用的开发效率

用于生成式 AI 工具的大型语言模型通常会极大地增加对更多处理器的需求,这些处理器通常价格昂贵且供应受限。即使是云资源也不能总是解决企业试图扩展规模并利用最新的生成式 AI 技术所面临的问题。

图片来自NVIDIA

「GPU 芯片的扩展迟早将无法跟上模型大小的增长。」Gartner Research 副总裁兼杰出分析师 Avivah Litan 在接受 Computerworld 采访时表示。因此,「继续制造越来越大的模型不是可行选项。」

市场上最大的 GPU 制造商英伟达显然看到了开源软件提高 AI 开发和效率方面价值。周一,Anyscale 宣布将英伟达 AI 引入 Ray 开源和 Anyscale 平台中。英伟达 AI 还将在 Anyscale Endpoints 中运行,该服务可帮助应用程序开发人员使用流行的开源模型(如 Code Llama、Falcon、Llama 2、SDXL 等)嵌入 LLMs 到其应用程序中。

最近宣布的 Nvidia TensorRT-LLM 将支持 Anyscale 以及 Nvidia AI Enterprise 软件平台。它可用于自动扩展推理以在多个 GPU 上并行运行模型,从而在运行 Nvidia H100 Tensore Core GPU 时提供 8 倍的性能提升,英伟达在博客中表示。

此外,英伟达 Triton Interence Server 软件支持在 GPU、CPU 和其他处理器上跨云、数据中心、边缘和嵌入式设备进行推理。当与 Ray 集成时,开发人员可以提高来自各种框架的 AI 模型(包括 TensorRT、TensorFlow、PyTorch、ONNX、OpenVINO 等)的效率。

Anyscale 声称其 Ray 是全球增长最快的可扩展计算统一框架。英伟达 NeMo 是一个面向云原生的框架,可以被 Ray 开发人员用于为客户提供 LLMs。

「我们与英伟达的合作将为 Anyscale 的产品组合带来更多性能和效率,以便开发人员随处创建具有前所未有速度和效率的 LLMs 和生成 AI 应用程序。」Anyscale 首席执行官兼联合创始人 Robert Nishihara 在一份声明中表示。

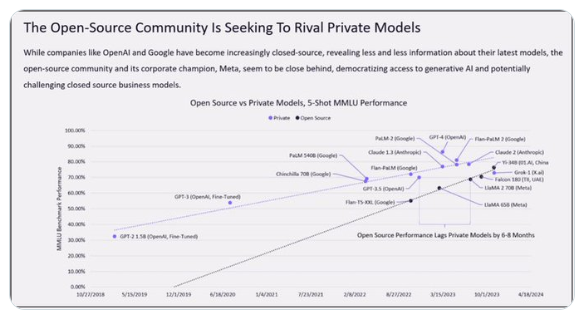

2024年最重要AI图引热议 开源AI模型正在超越专有模型!

要点:2024年最重要AI图表显示,开源本地模型正在超越大规模、基于云的昂贵封闭模型,受到LeCun等专业人士的认可。在5-ShotMMLU基准测试中,代表开源模型和闭源模型性能的两条线将在两年内相交,显示开源社区推动更易于访问的生成式AI,挑战传统闭源AI开发模式。Meta和IBM牵头成立AI联盟,旨在支持开放创新和开放科学,有50多家科技公司、高校和机构加入,显示全球支持开源的势头。站长网2023-12-20 14:55:230000百度李彦宏:小米、联想、蔚来接入文心大模型

快科技5月16日消息,今日,百度发布2024年第一季度财报,总营收315亿元,同比增长1%,归属百度的净利润70.11亿元,同比增长22%。据媒体报道,在财报电话会上,百度创始人李彦宏透露,继上季度与中国三星、荣耀合作后,本季度,小米、OPPO、vivo等手机厂商均接入文心大模型API。同时,大模型的合作领域还在从手机向PC和电动汽车领域拓展,联想和蔚来汽车也在季度内与达成合作。站长网2024-05-17 08:16:090000AI Agent大爆发!微软刚刚发布大量商用AI Agent,全民智能体!

今天凌晨,微软在芝加哥召开“Microsoftignite2024”全球开发者大会,AIAgent成为本次大会的重点。微软发布的这些AIAgent包括简单易用的开发、维护一站式平台AzureAIFoundry、AzureAIAgent,同时也有集成在Microsoft365、Dynamics365等主打产品。这体现出了微软力推AIAgent商业化的决心。0001vivo大模型云端方案vivo_Agent_LM_7B亮相

近日,vivo的大模型云端方案也已经出现在C-Eval排行榜上。该排行榜是一个全面的中文基础模型评估套件,包含13948个多项选择题,涵盖人文、社科、理工等多个学科和不同难度级别。从C-Eval给出的信息来看,vivo_Agent_LM_7B是由vivoAI全球研究院自主研发的大规模预训练语言模型,拥有70亿参数。站长网2023-08-16 09:05:130006平淡的直播电商还有哪些新可能

直播电商已经成为线上零售的常态化基础设施。头部达人和中腰部达人的价值出现分化,店播和达播的作用也开始矫正与归位。电商平台大乱斗背景下,行业正在重新理解直播电商的价值。也许是最卷的一次618落下帷幕。各大平台都用出全身解数激励商家和消费者参与其中。尽管在历次大促中,「低价」都是关键竞争要素,但今年它被提到了格外高的位置。京东和淘宝都喊出了「全行业/历史上投入最大的一届618」的口号。站长网2023-06-20 17:58:190000