Headless语言模型:通过捆绑嵌入提高模型的训练速度

站长网2023-09-20 11:06:292阅

要点:

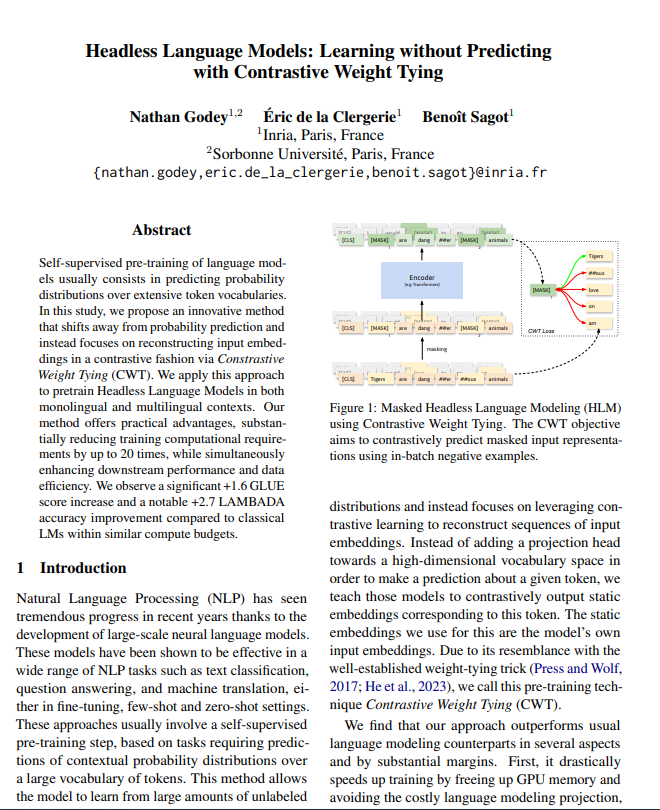

1. 提出了一种新的预训练方法,称为无预测头语言模型,它移除了对词汇空间概率分布的预测需求,而是关注用对比方式重构表示。

2. 该方法只需要改变目标函数,可以直接应用于经典语言模型预训练目标。

3. 在单语和多语编码器以及单语解码器中实验表明,Headless语言模型预训练相比经典方法在给定运算量下表现更好,计算效率更高。

研究人员发现了一种改进语言模型性能的方法——Headless语言模型,即将输入嵌入与模型的其他嵌入捆绑在一起,并使用对比损失。通常情况下,语言模型的输入和输出嵌入层是分开的,但这种新方法通过捆绑它们,提高了模型的训练速度和准确性。这一创新有望在大规模语言处理任务中取得广泛应用。

Headless语言模型通过移除语言模型预测词汇空间概率分布的需求,改为学习重构输入嵌入的对比方式,提供了一种创新预训练方法。作者提出了一种对比权重绑定损失,可以直接作为经典语言模型的目标函数替代,因此可以轻松集成到已有代码库中。

论文地址:https://arxiv.org/pdf/2309.08351.pdf

在英文和多语言单向编码器以及英文解码器模型的中等规模预训练实验中发现,在类似运算量下,Headless语言模型相比经典方法有显著提升,下游表现更好,数据效率更高,计算效率也更高。

例如,Headless语言模型在GLUE基准测试上的结果比对应的经典模型高1.6分,在LAMBADA数据集上的准确率提高了2.7分。

此外,训练Headless语言模型可以节省高达20倍的运算量。总的来说,这项工作为以对比学习取代交叉熵作为自监督预训练目标开辟了道路,为语言表示学习提供了一种高效可行的替代方案。

0002

评论列表

共(0)条相关推荐

苹果今年或推出低价AirPods 率先在印度工厂组装

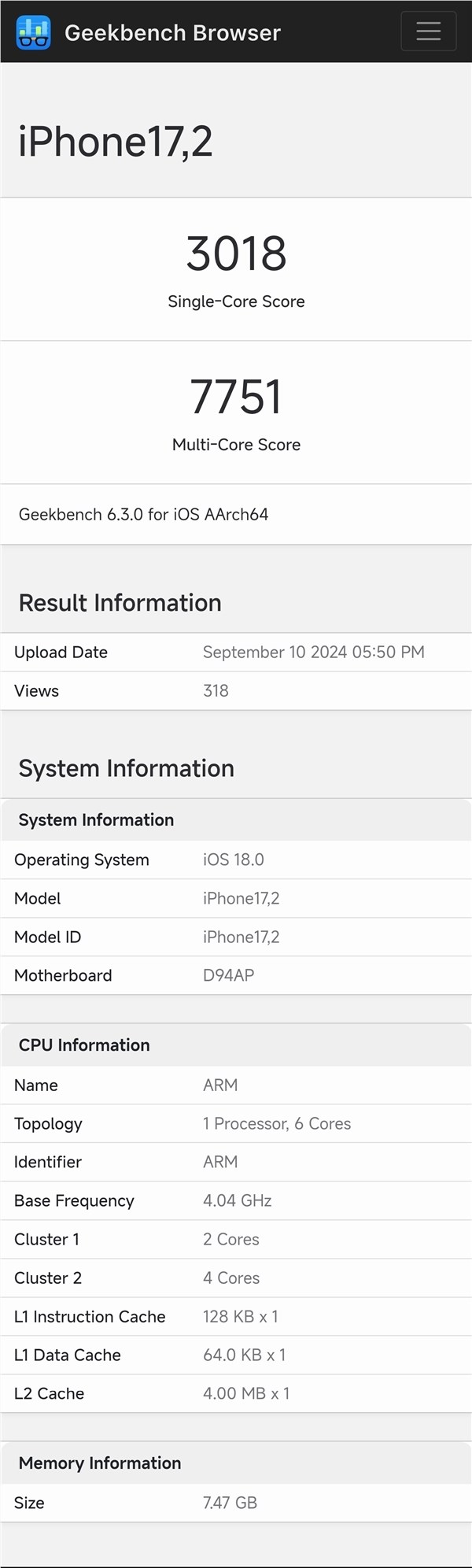

据最新消息,苹果即将在今年晚些时候推出一款价格更为亲民的AirPods耳机,这一消息来自于供应链分析师JeffPu的透露。这款新耳机将由富士康的子公司负责制造,并率先在印度的工厂进行组装工作。站长网2024-04-18 14:54:390000iPhone 16 Pro Max首发!苹果A18 Pro首个跑分出炉:多核成绩跟天玑9300持平

快科技9月11日消息,今天,苹果A18Pro首个跑分出现在Geekbench上,测试机型是iPhone16ProMax,单核成绩是3018,多核成绩是7751。对比A18,A18Pro的单核成绩略逊一筹,多核表现优势明显,跟安卓阵营相比,A18Pro的单核成绩超越了天玑9300和骁龙8Gen3,多核成绩跟天玑9300基本持平,跟上代A17Pro相比提升不大。站长网2024-09-12 03:55:440000巴恩风吹过,除了热闹,小红书留下了什么?

与其等风,不如造风。最近想买冬装的朋友,一定刷到过“巴恩风”这个词。什么是巴恩风?它是英文“Barnfit”的简称,其中“Barn”指的是谷仓。在不少欧美影视剧中,Barnfit被塑造成英国王室户外狩猎或在庄园做农活时的穿搭标配。由于Barnfit的单品多为实用主义的夹克、猎装,棕色、卡其、墨绿等颜色也更适合秋冬,于是跃升为许多人秋冬造型的灵感来源。0000开源中国完成股份重组,中国移动、联想等公司入股

根据天眼查App显示,开源中国的关联公司开源共识(上海)网络技术有限公司在7月18日发生了工商变更,新增了中国移动旗下的北京中移数字新经济产业基金合伙企业、联想旗下的湖北省联想长江科技产业基金合伙企业、中国互联网投资基金等多家企业作为股东。同时,原股东百度旗下的传课计算机系统(北京)有限公司的出资额减少,公司注册资本也有所增加。站长网2023-07-20 17:30:380000Deepdub推出AI音视频本地化平台Deepdub Go 提供65种语言配音

Deepdub推出DeepdubGo,提供AI音视频配音与语言本地化服务。该平台旨在为独立游戏工作室、广告机构、在线学习平台和内容创作者提供65种语言的配音服务。DeepdubGo使用AI技术,允许用户使用自己的声音进行配音,并通过情感引导AI控制声音的情感表达。站长网2023-07-08 02:52:460001