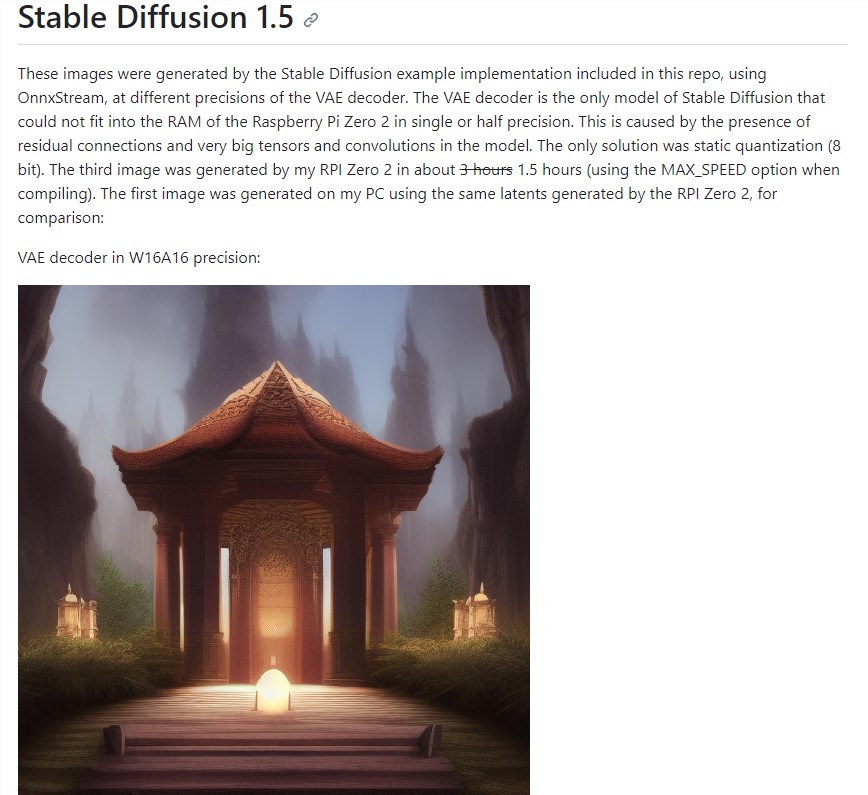

OnnxStream:内存友好的机器学习推理引擎 可在树莓派Zero 2上运行Stable Diffusion 1.5

OnnxStream是一款专注于减少内存占用、提高推理效率的机器学习推理引擎。它的设计目标是在资源受限的环境中运行深度学习模型,如树莓派Zero2,该设备只有512MB的RAM。

通过OnnxStream,用户现在可以在这种低功耗设备上运行复杂的算法,这对于需要在移动环境中处理大量数据的用户来说是一个重大突破。

项目地址:

https://github.com/vitoplantamura/OnnxStream/tree/846da873570a737b49154e8f835704264864b0fe

目前,OnnxStream的源代码已经在GitHub上开源,任何感兴趣的用户都可以查看和使用。这一创新为在资源有限的环境中运行深度学习算法提供了新的可能性,对于技术爱好者和开发者来说是一个令人振奋的消息。

核心功能:

1. 内存占用极低:OnnxStream的最大特点之一是其出色的内存管理能力。它可以将内存占用降低到极低的水平,甚至可以在RAM只有512MB的树莓派Zero2上运行大型深度学习模型,如Stable Diffusion XL1.0。

2. 权重加载器:OnnxStream提供了权重加载器(WeightsProvider)的接口,用户可以根据自己的需求实现不同的权重加载逻辑。默认情况下,OnnxStream提供了两种加载器:DiskNoCache和DiskPrefetch,分别用于不缓存和预加载权重数据。

3. 注意力切片:在运行UNET模型时,OnnxStream支持注意力切片(Attention Slicing),这可以显著减少计算中的内存占用,从而使模型在资源受限的设备上运行更加顺畅。

4. 动态量化和静态量化:OnnxStream支持动态量化和静态量化,这有助于减少模型的内存占用,并提高推理速度。用户可以根据自己的需求选择不同的量化方式。

5. 跨平台支持:OnnxStream可以在多个平台上运行,包括Linux、Mac、Windows和Termux。它的跨平台性使得用户可以在不同的设备上灵活使用。

高端手机只有华为硬扛苹果!华为P60系列5月9日海外发布

快科技5月1日消息,没想到华为在五一”假期宣布了新机发布时间,不过面向的是海外市场,产品也是此前在国内首发过的。今日,华为海外账号HuaweiMobile”宣布,将于2023年5月9日在海外发布华为P60系列和多款旗舰产品。官宣后,有海外网友表示,已经在等待了华为新品的发布了。值得一提的是,与国行版P60不同,海外版本预计将搭载EMUI13操作系统,而不是HarmonyOS3.1。站长网2023-05-02 09:27:340000在抖音追小说,养肥了谁?

“0粉丝账号可接、3-7天出单,有手就能赚钱。我自己第4天就出单了,目前已经变现4万。”任何一个想做副业的人,看到这样的帖子都难免心动。这就是今年最火的副业之一——小说推文。站长网2023-10-30 09:16:360002新一代鸿蒙生态5G手机!WIKO Hi畅享60s现身产品库:配天玑700芯

快科技10月1日消息,源于法国的手机品牌WIKO,与去年年底再国内推出了全新的产品系Hi畅享,推出了具有鸿蒙生态属性的手机Hi畅享60。近日,一款全新的鸿蒙生态手机Hi畅享60s现身中国电信终端产品库,其部分硬件规格也随之曝光。站长网2023-10-02 09:42:200000苹果CEO库克:将捐款支持甘肃地震灾区救援和重建工作

12月18日23时59分,甘肃省临夏回族自治州积石山县发生6.2级地震,震区发生人员伤亡,灾情牵动了全国人民的心。刚刚,苹果公司CEO库克在微博发文称,“甘肃地震及其引发的灾情令人痛心。在Apple,我们心系每一位受灾者,我们将捐款支持当地的救援和重建工作。”站长网2023-12-19 14:01:320000奥特曼宫斗戏新爆料:自己投芯片公司,让OpenAI签下3.6亿订购意向书

奥特曼又惹上事了。一份订购意向书曝光,奥特曼任CEO期间,OpenAI承诺从一家初创公司订购芯片,金额高达5100万美元(约合人民币3.6亿元)。关键问题在于,这家公司RainAI是奥特曼自己参与投资的。两家公司总部都在旧金山,相距不到一公里左右,走路十来分钟就到了那种。消息一出,网友马上联想到之前奥特曼被开除公告中的“沟通不坦诚”。站长网2023-12-04 15:05:300002