Meta研究人员提出轻量级微调方法RA-DIT 以增强语言模型知识检索能力

文章概要:

1. RA-DIT通过两阶段调优提升语言模型利用检索信息的能力和检索器提供相关结果的能力。

2. RA-DIT在知识密集的零样本和少样本学习基准测试中优于现有检索增强模型。

3. RA-DIT65B在需要利用知识的任务中表现显著提升,展现调优带来的效果。

最近,Meta的研究人员提出了一种名为检索增强双指令调优(RA-DIT)的新型人工智能方法,用于提升语言模型的知识检索能力。该方法试图解决大型语言模型在捕获较为冷门知识时的局限性以及大规模预训练的高计算成本问题。

RA-DIT是一个轻量级的两阶段微调方法,旨在为任何语言模型赋予高效的检索能力。它通过两种不同的微调方式,每种方式都能带来可观的性能提升。首先,它会优化语言模型利用检索到的信息的能力。其次,它会优化检索器提供的内容相关性,使其能够提供更符合语言模型偏好的相关结果。通过同时提升语言模型使用检索信息的效果和检索器提供内容的相关性,RA-DIT能有效地增强语言模型的知识检索能力。

图源备注:图片由AI生成,图片授权服务商Midjourney

研究人员采用了在大规模数据集上进行过预训练的LLAMA语言模型,并使用初始化为DRAGON模型的双编码器检索架构。此外,他们还提到了使用并行上下文检索增强,以更有效地计算语言模型的预测。

实验结果显示,RA-DIT65B在知识密集的零样本和少样本学习任务中设置了新的基准,大幅超过现有的上下文检索增强语言模型。这证明了轻量级指令调优在提高检索增强语言模型性能方面的效果,特别是在需要访问大量外部知识源的场景中。在需要利用知识和语境感知的任务中,RA-DIT65B的表现有了大幅提升。此外,与基础LLAMA模型相比,RA-DIT在8个常识推理评估数据集中表现更好。

RA-DIT为预训练语言模型带来了检索能力的提升。它在知识密集的零样本和少样本评估中取得了最先进的结果,超过了未调优的上下文检索增强语言模型,与大规模预训练的方法展现出竞争力。RA-DIT显著改善了对知识利用和语境感知的要求较高的任务的表现。该研究证明了轻量级指令调优对检索增强语言模型的有效性,特别是在涉及大规模外部知识源的场景中。

论文网址:https://arxiv.org/abs/2310.01352

MIT研究人员利用人工智能识别可杀灭耐药细菌的抗生素

**划重点:**1.💡通过深度学习,MIT研究人员发现一类新型抗生素,可有效杀灭导致美国每年超过1万人死亡的耐药细菌。2.🌐利用人工智能的新型药物研发在医疗领域日益受到关注,MIT的研究提供了一个高效、资源有效的框架,为化学结构角度的药物研发提供机械洞察。站长网2023-12-22 10:16:040000《生成式人工智能服务安全基本要求》公开征求意见

据全国信息安全标准化技术委员会网站消息,全国信息安全标准化技术委员会组织制定的技术文件《生成式人工智能服务安全基本要求》已形成征求意见稿。根据《全国信息安全标准化技术委员会技术文件制订工作程序(试行)》,现将该技术文件面向社会公开征求意见,如有意见或建议请于2023年10月25日24:00前反馈秘书处。站长网2023-10-12 17:25:390000免费!Pika 1.0正式向所有人开放网页版本试用资格

Pika1.0正式上线后,很多没有拿到内测资格的网友只能眼巴巴看着其他网友疯玩。而现在,Pika1.0宣布正式向所有人开放网页版试用资格,每个人都可以免费试玩。站长网2023-12-26 12:18:540003Midjourney可能在这个选举季禁止生成拜登和特朗普的图片

划重点:-💬Midjourney的首席执行官在Discord的聊天会话中告诉用户,公司可能会禁止拜登和特朗普等人的图片。-🚫这一举措旨在避免在选举季引发争议和纷争。-📵禁止这些图片可能会影响用户之间的政治讨论和观点交流。站长网2024-02-28 15:05:180001特斯拉人形机器人集体出街!已与FSD算法打通,马斯克:比车便宜,成熟后会有100亿台

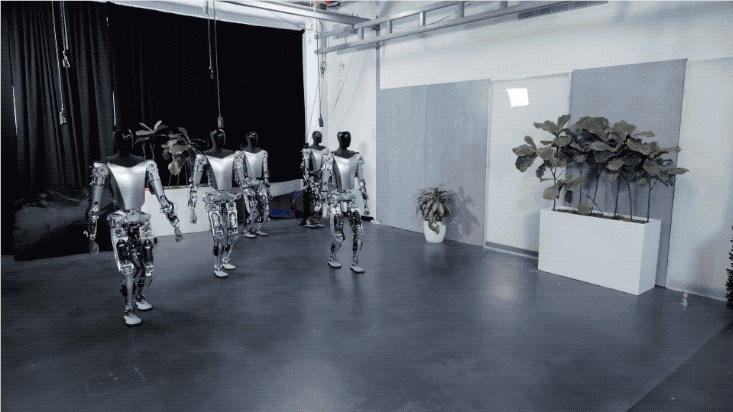

马斯克的人形机器人——特斯拉Optimus进化了,价格还“比车更低”。现在,成群结队的Optimus学会了像人一样缓慢前行:视频中它们还路过Cybertruck的生产间,满满的赛博朋克味道。而且Optimus们可不是简单的在走路而已,而是边走边发现并记忆周遭的环境:接下来,是更为细节的能力展示。例如特斯拉展示了Optimus电机转矩控制的能力,是能做到控制力道不打碎鸡蛋的那种:站长网2023-05-18 18:12:290000

正在请求数据,请稍候!

正在请求数据,请稍候!