微软研究人员用儿童故事进行训练:微型语言模型进入成熟期

站长网2023-10-09 16:13:260阅

站长之家(ChinaZ.com) 10月9日消息:学习英语并不容易,许多学生都深有体会。但当学生是一台计算机时,有一种方法表现出奇地出色:只需将大量来自互联网的文本输入到一个名为神经网络的巨大数学模型中。

这就是生成式大语言模型(如 OpenAI 的 ChatGPT)的工作原理,这些模型能够在各种主题上进行连贯(尽管不总是真实)的对话,令研究人员和公众在过去的一年中感到惊讶。

但这种方法也有其缺点。首先,将大量文本档案转化为最先进的语言模型所需的「训练」过程既昂贵又耗时。其次,即使是训练大型语言模型的人们也很难理解它们的内部工作原理;这反过来又使得难以预测它们可能出现的许多问题。

面对这些困难,一些研究人员选择对较小的数据集上的较小模型进行训练,然后研究它们的行为。布朗大学的语言模型研究员 Ellie Pavlick 表示:「这就像测序果蝇基因组与测序人类基因组一样。」

现在,在最近发布在科学预印本服务arxiv.org 上的一篇论文中,两名微软研究人员介绍了一种训练微小语言模型的新方法:用儿童故事来训练它们。

机器学习研究人员已经接受了这一教训。驱动 ChatGPT 界面的大型语言模型 GPT-3.5 拥有近 2000 亿个参数,它是在包含数千亿个词汇的数据集上训练的。(OpenAI 尚未公布其继任者 GPT-4 的相应数据。)训练如此大型的模型通常需要至少 1000 个并行运行数周的专用处理器(称为 GPU)。只有少数公司能够调集必要的资源,更不用说训练和比较不同模型了。

这两名研究人员展示了,与今天的最先进系统相比,比这些系统小数千倍的语言模型在这种方式下能够迅速学会讲述一致和符合语法的故事。他们的研究结果暗示了可能有助于训练更大型模型并理解其行为的新研究方向。

0000

评论列表

共(0)条相关推荐

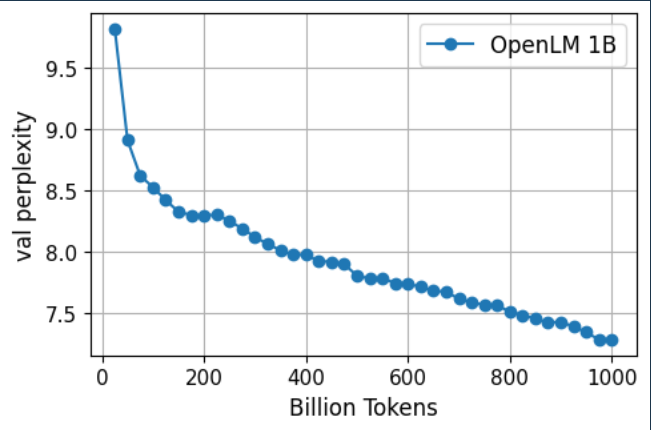

OpenLM:一个专为中等规模语言模型设计的模型训练库

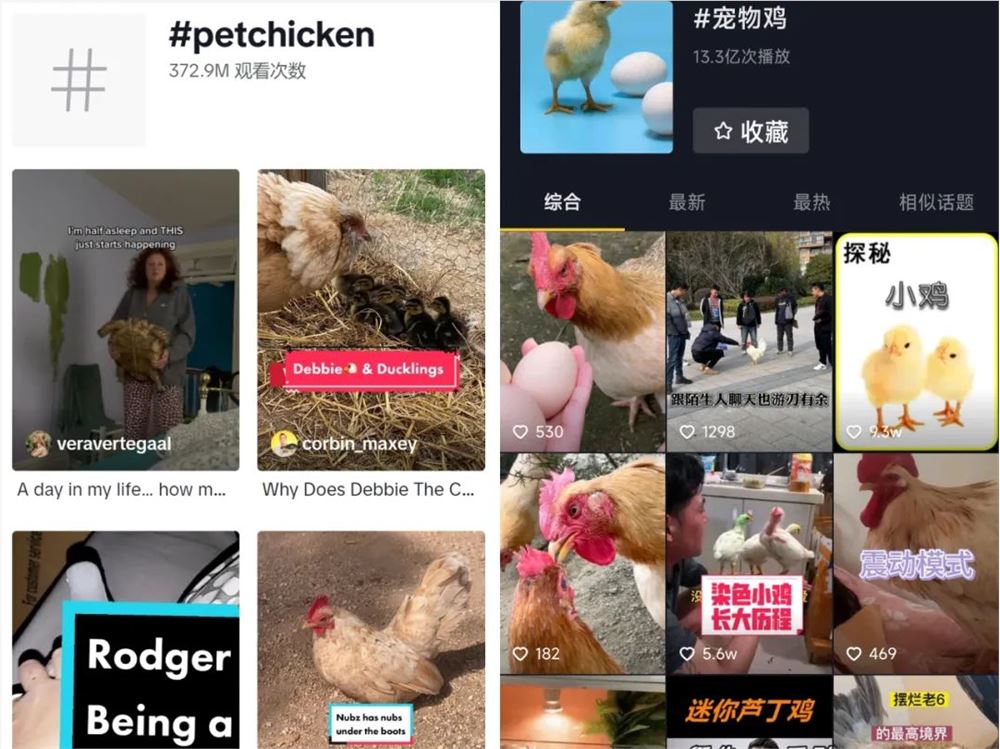

要点:1.OpenLM是一个简单且精简的PyTorch代码库,用于训练中等规模的语言模型,旨在最大化GPU利用率和训练速度,易于用于新的语言模型研究和应用。2.OpenLM通过训练两个语言模型,OpenLM-1B和OpenLM-7B,分别在1.6T和1.25T文本标记上进行验证,并在标准的零样本文本分类和多项选择任务上表现出色。站长网2023-09-28 14:44:490006给鸡穿衣,小众宠物背后的生意经

当我拿着宠物鸡穿衣服的图片给大家看的时候,编辑部的同事们愣住了。“什么?鸡也要穿衣服吗?”办公室内沉默了几秒,有人反应过来:“什么?还有人养鸡吗?图片里这不是普通鸡吗,养来吃掉吗?”怀揣着巨大的好奇,刺猬公社展开了对“宠物鸡”的地毯式搜索。站长网2024-01-18 09:07:480000李彦宏:百度文心一言是率先实现收费的大型语言模型之一

在昨日的财报电话会议上,针对AI相关问题,百度董事长兼CEO李彦宏表示,公司在利用生成式人工智能技术推动广告业务增长,包括创意建设、精准投放、竞价优化方面的工作,这些努力也在逐步起效,所推动的营收增长也将在四季度超过数亿元人民币。站长网2023-11-22 08:36:340000梅赛德斯奔驰和微软宣布合作:测试车载 ChatGPT 人工智能

站长之家(ChinaZ.com)6月16日消息:梅赛德斯-奔驰和微软宣布合作,在美国超过90万辆车中进行车载ChatGPT人工智能测试。这款新兴技术将用于通过梅赛德斯的语音助手「HeyMercedes」进行音频请求,预计将大大扩展该系统的功能。据微软发言人表示,这是ChatGPT在汽车中的首次应用。站长网2023-06-16 16:32:320000Redmi Note12T Pro今日10点开启预售 配备144Hz LCD原色屏

今日10点,RedmiNote12TPro手机将正式开启预售。其最大的亮点是采用高素质LCD原色屏幕,支持144Hz刷新率、7挡变速调节以及全程DC调光防频闪等。此外,RedmiNote12TPro搭载了台积电4nm制程的天玑8200-Ultra芯片,采用小米自研性能调度技术,跑分超过90万。内存组合为LPDDR5UFS3.1,最大提供12GB512GB版。站长网2023-05-30 09:15:460000