突破性文本生成视频方法LVD,利用LLM创建动态场景布局

文章概要:

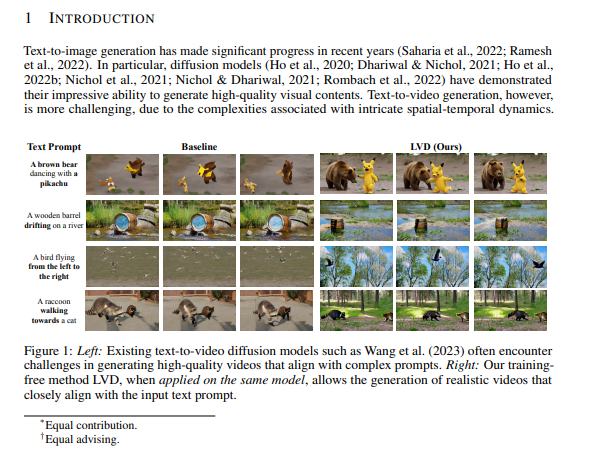

1. 困扰文本提示生成视频的挑战:研究团队引入LLM-Grounded Video Diffusion(LVD)方法,以解决生成复杂时空动态视频的问题。

2. LVD采用大型语言模型(LLMs)来创建动态场景布局(DSLs),作为视频生成的蓝图,同时发现LLMs具有惊人的能力来捕捉时空关系和复杂动态。

3. LVD结果显著优于基本视频扩散模型,为纯文本提示生成与所需属性和运动模式相符的视频,为内容创作和视频生成等应用开辟了新的可能性。

针对从文本提示生成视频所面临的挑战,一支研究团队引入了一种新方法,名为LLM-Grounded Video Diffusion(LVD)。核心问题在于,现有模型难以准确表示文本提示中描述的复杂时空动态。

为了提供背景,文本到视频生成是一项复杂的任务,因为它要求仅基于文本描述生成视频。尽管以前曾尝试解决这个问题,但它们在生成的视频在空间布局和时间动态方面与给定提示的匹配方面通常表现不佳。

然而,LVD采用了一种不同的方法。它不是直接从文本输入生成视频,而是利用大型语言模型(LLMs)首先根据文本描述创建动态场景布局(DSLs)。这些DSLs本质上充当了随后的视频生成过程的蓝图或指南。

尤为引人注目的是,研究人员发现LLMs具有出人意料的能力,可以生成这些DSLs,不仅捕捉了空间关系,还捕捉了复杂的时空动态。这对于仅基于文本提示准确反映现实世界场景的视频生成至关重要。

为了使这个过程更具体,LVD引入了一种算法,利用DSLs来控制视频扩散模型中生成物体级空间关系和时空动态的方式。重要的是,这种方法不需要大量的训练;它是一种无需训练的方法,可以集成到各种具有分类器指导能力的视频扩散模型中。

LVD的结果非常显著。它在生成视频方面明显优于基本视频扩散模型和其他强基线方法,能够忠实地遵循文本提示中所需的属性和运动模式。LVD生成的文本和视频之间的相似性为0.52。不仅如此,文本和视频之间的相似性,以及视频的质量都超越了其他模型。

可见,LVD是一种开创性的文本到视频生成方法,利用LLMs的能力来生成动态场景布局,最终提高了从复杂文本提示生成的视频的质量和保真度。这种方法有潜力在内容创作和视频生成等各种应用中开辟新的可能性。

论文网址:https://arxiv.org/abs/2309.17444

前哈工大教授开发的ChatALL火了 一次可同时和10个机器人聊天

前哈工大教授开发的ChatALL火了!ChatALL是一个应用程序,它允许用户将他们的问题发送到10多个常见的聊天机器人,包括ChatGPT、GPT4、Bing、Bard、Claude等,并比较他们的答案以选择最佳的一个。该应用程序有中文、英文和德文版本,支持Mac、Windows和Linux。站长网2023-05-19 15:56:410000苹果在印度工厂进行 iPhone 17 标准版的前期研发制造工作

据国外媒体报道,苹果公司计划在印度工厂进行iPhone17标准版的前期研发制造工作,这是苹果在供应链多元化方面的新进展,也展示了其对印度工程师团队的信心。据苹果离职和在职员工表示,这一环节堪称产品开发中最具挑战、资源消耗最大的部分,内部称为“新产品引进”。它涉及iPhone设计与材料的调整,以及设备类型和制造工艺的试验,旨在确保在不同地点每天生产数百万部iPhone,同时尽可能减少缺陷。0004小米14系列两大新升级曝光!消灭多年遗憾

快科技6月7日讯,今年的高通骁龙峰会定档10月24日,不出意外的话,骁龙8Gen3将与我们正式见面。它的发布也意味着,一大批换代的安卓旗舰也会随后登场了,其中的代表无疑包括小米14系列。爆料人KartikeySingh给出消息,小米14系列上将补上小米13、小米13Pro身上的两点遗憾,一是自拍,二是USB接口。0000净赚9.7亿 东方甄选一年带货100亿:29日首次淘宝直播

自从业务重心从教培转向直播带货之后,新东方甚至把名字也改成了东方甄选,今晚该公司发布了2023财年业绩,去年6月1日到今年5月31日的一年中带货GMV超过100亿,净利润9.71亿,同比扭亏为盈。报告期内,东方甄选实现营收45.1亿元,同比增长401.9%,净利润为9.71亿元,同比扭亏为盈。其中东方甄选自营产品及直播电商分部的营收为39亿元。0000高德地图升级无障碍导航 上线视障导航和听障信息指引

高德地图近期宣布对其无障碍导航功能进行重大升级,推出专为视障和听障人士设计的导航服务。2022年,在中国残联和浙江省残联的支持与指导下,高德地图首次上线了无障碍轮椅导航功能,并获得了轮椅用户的广泛好评。现在,高德地图进一步扩展了其服务范围,包括视障导航和听障信息指引,以满足更多残障人士的出行需求。站长网2024-08-20 09:29:560000