科技界“教父”表示:对AI公司造成的伤害必须追究责任

划重点:

1. 两位“科技教父”,警告强大的人工智能系统威胁社会稳定,要求AI公司对其产品造成的危害负有责任。

2. 他们强调,在进行更强大的人工智能系统开发之前,应首先了解如何确保其安全。

3. 政策建议包括政府将三分之一的AI研发资金分配给安全和道德使用。

包括两位“科技教父”在内的资深专家警告称,强大的人工智能系统威胁社会稳定,AI公司必须对其产品造成的危害承担责任。这一警告是在国际政界、科技公司、学术界和社会公众为下周在Bletchley Park举行的AI安全峰会做准备之际发出的。

23位专家共同起草了这一政策建议,其中一位共同起草者表示,在了解如何确保其安全之前,追求更强大的人工智能系统是“绝对鲁莽”的。他说:“现在是认真对待先进的人工智能系统的时候了。这些并不是玩具。在了解如何确保其安全之前增强它们的能力是绝对鲁莽的。” 他还补充说:“对于AI公司而言,比起AI公司,三明治店面临的监管要多得多。”

图源备注:图片由AI生成,图片授权服务商Midjourney

这一政策文件敦促各国政府采取一系列政策措施,包括将三分之一的AI研发资金分配给安全和道德使用,允许独立审计员访问AI实验室,建立切割边缘模型的许可制度,如果在其模型中发现危险能力,AI公司必须采取特定的安全措施,以及让科技公司对其AI系统造成的可预见和可防止的危害负责。

这一政策文件的其他共同起草者包括Geoffrey Hinton和Yoshua Bengio,他们是被誉为“科技教父”的三位专家中的两位。他们曾因在人工智能领域的工作而在2018年获得ACM图灵奖,这是计算机科学领域的诺贝尔奖等同奖项。这两位专家都受邀参加下周的峰会。Hinton于今年辞去了谷歌的职务,警告数字智能构成了“存在威胁”,而Bengio则是蒙特利尔大学计算机科学教授,他于今年与成千上万的其他专家一起签署了一封呼吁停止巨大的AI实验的信函。

这一政策文件的其他合著者还包括畅销书《无政府主义》的作者Yuval Harari、诺贝尔经济学奖获得者Daniel Kahneman,以及多伦多大学的人工智能教授Sheila McIlraith等。

这些专家警告说,粗心开发的人工智能系统威胁加大社会不公正,破坏我们的专业领域,侵蚀社会稳定,可能会导致大规模犯罪或恐怖活动,并削弱我们对社会基础的共同理解。

他们还警告说,当前的人工智能系统已经显示出令人担忧的潜在能力,预示着自主系统的出现,这些系统可以制定计划、追求目标,并“在世界中行动”。这些专家称,由美国公司OpenAI开发的ChatGPT工具的GPT-4人工智能模型已经能够设计和执行化学实验、浏览互联网,并使用其他人工智能模型等软件工具。

如果现在构建高度先进的自主人工智能系统,他们警告说,我们可能会面临这些系统自主追求不良目标的风险,而我们可能无法控制它们。

这一政策文件中的其他政策建议包括强制报告模型显示令人担忧行为的事件,采取措施阻止危险模型复制自己,赋予监管机构权力暂停显示危险行为的人工智能模型的开发。

下周的安全峰会将重点关注由人工智能引发的存在威胁,例如帮助开发新型生物武器和逃避人类控制。英国政府正在与其他与会者合作,拟定一份声明,预计将强调来自前沿人工智能的威胁。然而,尽管峰会将概述人工智能的风险和应对措施,但不预计会正式成立全球监管机构。

一些人工智能专家认为,对人类的存在威胁担忧是夸大其词的。2018年图灵奖的另一位获奖者Yann LeCun,如今是马克·扎克伯格的Meta公司首席人工智能科学家,他也将参加峰会,他告诉《金融时报》,人工智能可能灭绝人类的观念是“荒谬的”。

然而,这一政策文件的合著者们认为,如果现在出现高度先进的自主人工智能系统,世界将不知道如何确保其安全或进行安全测试。他们补充说:“即使我们知道,大多数国家都没有机构来防止滥用和维护安全实践。”

户外品牌“鄙视链”,正在被平替打破?

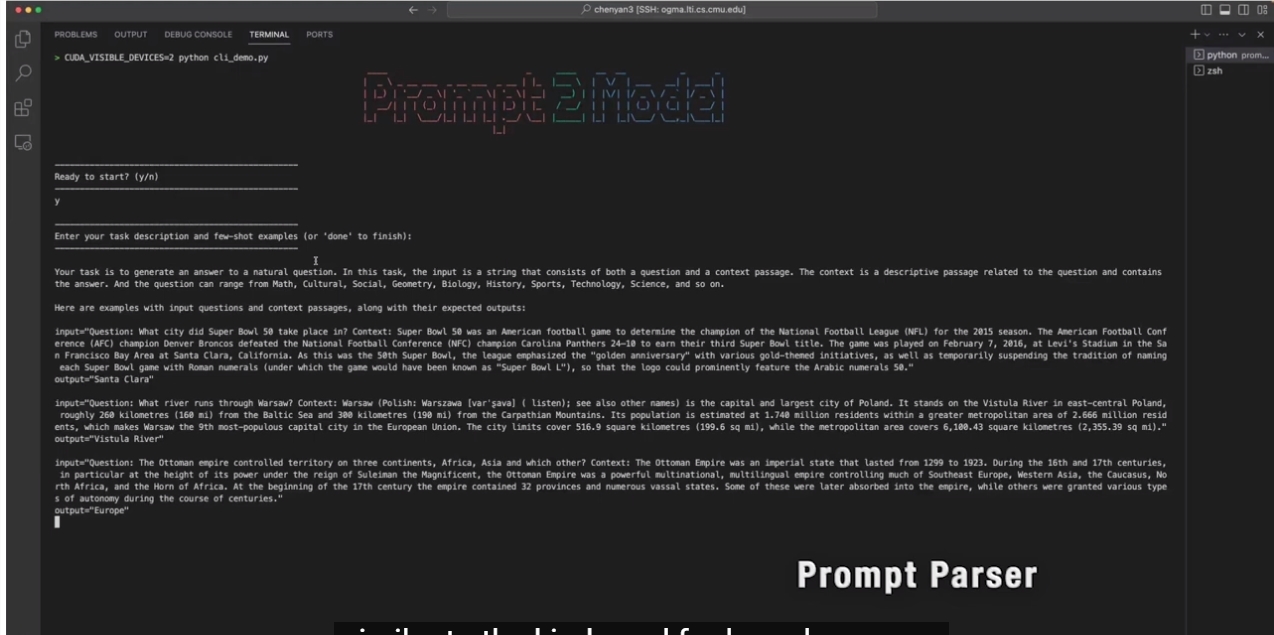

近两年,户外运动之热有目共睹。露营、滑雪、陆冲、骑行等运动颇受欢迎,在小红书、抖音等社交平台,许多用户晒出自己的穿搭、装备,户外运动俨然成为当下热门潮流,许多专业户外品牌由此进入大众视野。科尔尼管理咨询公司发布的运动户外趋势洞察指出,预计到2025年,中国运动户外市场规模将接近6000亿元,且未来仍有较大的发展空间。站长网2024-04-26 04:11:000000Prompt2Model:可自动生成专用NLP模型

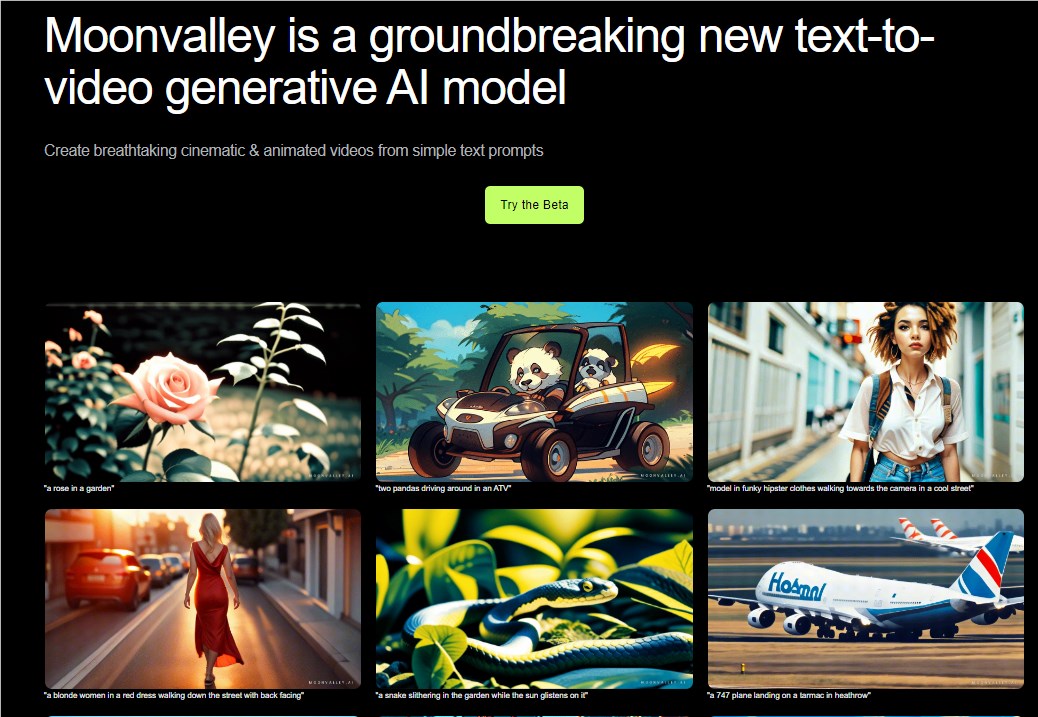

文章概要:1.Prompt2Model可以根据提示自动生成专用NLP模型,在某些情况下性能超过GPT-3.5Turbo。2.Prompt2Model使用OpenAI的GPT-3.5Turbo生成合成训练数据,再利用预训练的HuggingFace模型进行微调。3.Prompt2Model依赖OpenAI的GPT-3.5Turbo是商业应用的局限,正在探索使用开源语言模型。站长网2023-09-05 10:06:560000文字转视频工具Moonvalley:用简单提示可生成高质量视频

文章概要:-Moonvalley使用AI模型,可从简单文字中生成高清视频和动画-用户只需输入文字提示,Moonvalley即可创作电影级视觉效果-该产品可协助广告、电影等行业工具化和自动化内容创作,大幅降低成本和门槛,对创意产业影响深远。站长网2023-10-09 10:26:250000转嫁成本给用户!苹果AI可能要收费:每月超140元

快科技8月8日消息,据媒体报道,苹果正考虑为其即将推出人工智能系统AppleIntelligence向用户收费,预计每月价格高达20美元(约合143元人民币)。CounterpointResearch的合伙人NeilShah透露,苹果计划在年内晚些时候正式推出AppleIntelligence系统。0000斯坦福研究称:ChatGPT在部分任务表现变蠢 准确率下降

斯坦福大学和加州大学伯克利分校的研究人员发表了一篇论文,研究了OpenAI的ChatGPT大语言模型(LLM)在2023年3月至6月之间发生的变化。站长网2023-07-20 17:17:200004