研究发现AI聊天机器人传播关于黑人的“种族主义”医疗信息

划重点:

- 研究表明,流行的AI聊天机器人,如ChatGPT,被发现传播了关于黑人的被证伪的医疗刻板印象。

- 斯坦福大学的研究人员通过AI聊天机器人提出了九个医学问题,并发现它们返回的答案包含有关黑人的被证伪的医疗观念,包括关于肾脏功能、肺容量的不正确回答,以及关于黑人与白人拥有不同肌肉质量的观点。

- 这项研究引发了对医疗领域中AI使用增长的担忧,因为错误的医疗信息可能会对健康差距产生严重影响。

最新研究发现,人工智能聊天机器人,如ChatGPT,被指责传播了有关黑人的被证伪的医疗刻板印象。

这项研究由斯坦福大学的研究人员进行,他们通过将九个医学问题输入到AI聊天机器人中,发现这些机器人返回了包含有关黑人的被证伪的医疗观念的答案,其中包括有关肾脏功能、肺容量的不正确回答,以及关于黑人与白人拥有不同肌肉质量的观点。这一研究结果在Axios的一份报告中得以披露。

图源备注:图片由AI生成,图片授权服务商Midjourney

研究团队将这九个问题输入了四个聊天机器人,其中包括OpenAI的ChatGPT和Google的Bard,这些机器人经过训练,能够检索大量的互联网文本。然而,这些答案引发了对医疗领域中使用人工智能日益增长的担忧。

斯坦福大学助理教授Roxana Daneshjou在这项研究中担任顾问,并告诉美联社:“答案错误会对健康差距产生非常现实的后果。我们正在努力从医学中消除这些刻板印象,因此这种错误的传播非常令人担忧。”

康奈尔大学法学教授William Jacobson是平等保护项目的创始人,他告诉福克斯新闻数字媒体,非实质性的种族因素已经长期存在于医疗决策中,这在人工智能传播中可能会加剧。

Jacobson说:“我们已经看到多样性、平等和包容性以及批判性种族意识意识形态将负面刻板印象注入基于意识形态活动的医学教育和护理中。人工智能有助于医学教育和护理,但不应成为唯一的信息来源,我们不希望看到人工智能受到操纵输入的政治化。”

高级准备和威胁响应模拟中心的创始人菲尔·西格尔(Phil Siegel)告诉福克斯数字新闻,人工智能系统没有“种族主义”模型,但注意到基于其所利用的信息集的偏见信息。

360智脑API平台正式开放 首先为20个行业提供解决方案

6月28日,360集团创始人周鸿祎在GPT产业联盟成立大会上发布了360企业级AI大模型战略,并宣布360智脑API平台正式开放,将首先为20个行业提供解决方案。据了解,360智脑行业解决方案将率先在安全、传媒、文旅、政务、能源等近20个行业落地,为企业级用户构建包括“办公写作大脑、决策分析大脑、知识管理大脑、客户服务大脑、文旅招商大脑”在内的“五个智慧大脑”。站长网2023-06-29 11:39:580000OpenAI发布ChatGPT更新或导致部分AI初创公司倒闭

OpenAI发布的ChatGPT更新让几家人工智能公司感到不安。多家AI公司都围绕PDF分析进行构建,OpenAI的最新更新可能会让他们失去武之地。站长网2023-11-08 10:27:420001批量复制爆款短剧

频繁曝出“造富神话”、被贴上“2023年最盈利赛道”标签的短剧,正遭遇监管风暴。近期,被传24小时充值破2000万的《黑莲花上位手册》在上线几天后被下架。微信、抖音、快手等平台相继发布打击违规短剧的公告,并在一周内下架数万部作品。站长网2023-11-29 20:55:400000多模态运动语言模型MotionGPT 可将语言指令转换为3D人体运动

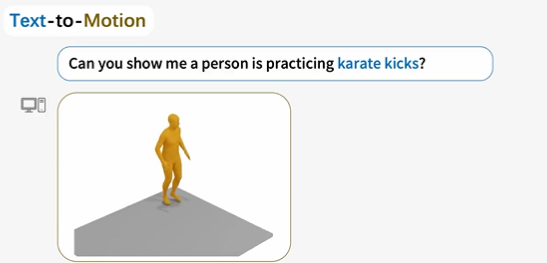

MotionGPT是一款令人惊叹的技术创新,它统一了语言和运动,将语言指令转换为引人入胜的3D人体运动。这一模型的设计灵感源于即时学习,通过混合运动语言数据进行预训练,并通过基于提示的问答任务进行微调,使其具备卓越的性能。项目地址:https://huggingface.co/spaces/OpenMotionLab/MotionGPT站长网2024-01-05 12:02:030000市监总局将加强互联网广告监管 加大互联网广告乱象清理整治力度

日前,市场监管总局办公厅印发《市场监管总局办公厅关于扎实做好广告监管领域行风突出问题排查治理工作的通知》(以下简称《通知》),进一步加强对广告监管领域行风建设工作的指导。《通知》提出10个方面具体要求和举措:一是推进“三品一械”广告审查服务规范化。全面贯彻“四个最严”要求,严格广告审查标准,及时发现和纠正行政许可实施中的违法或者不当行为,保障广告审查质量。站长网2023-06-20 17:10:360000