ChatGPT泄露陌生男子自拍照!隐私数据被模型偷了?网友大恐慌

【新智元导读】原来,这竟然也是ChatGPT的幻觉?

最近,ChatGPT响应中蹦出陌生男子照片事件,让许多网友们震惊了!

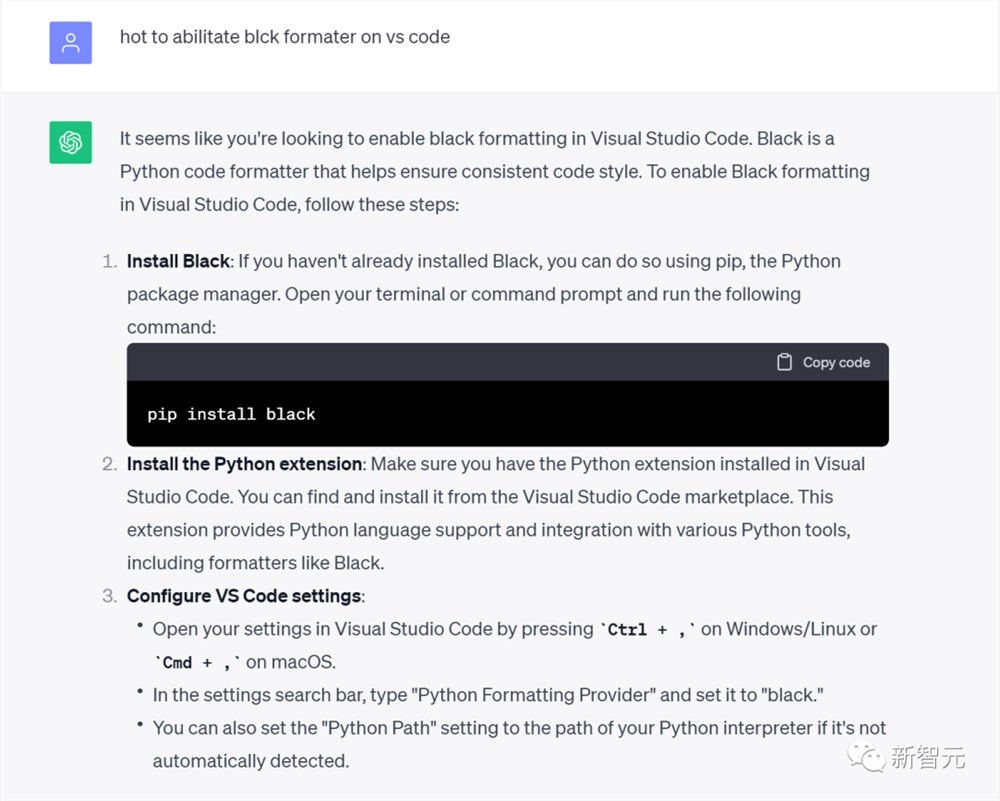

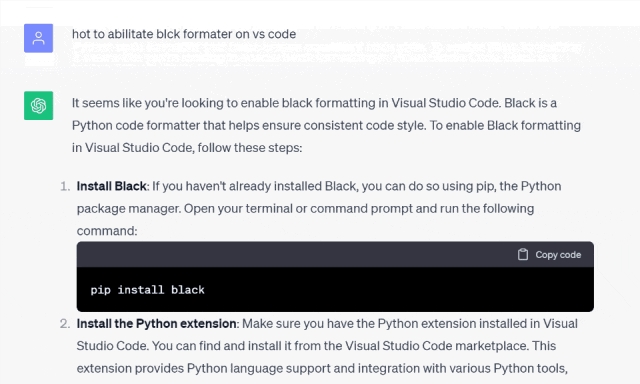

事情是这样的,一名用户向ChatGPT求助——Python中的代码格式化包back该怎样使用。

开始,ChatGPT的回答还很正常。

谁料想,ChatGPT忽然就在响应中,发出了一张陌生男子的自拍照!

而且还出现了第二次!

网友们立刻陷入恐慌。

莫非ChatGPT现真身了?

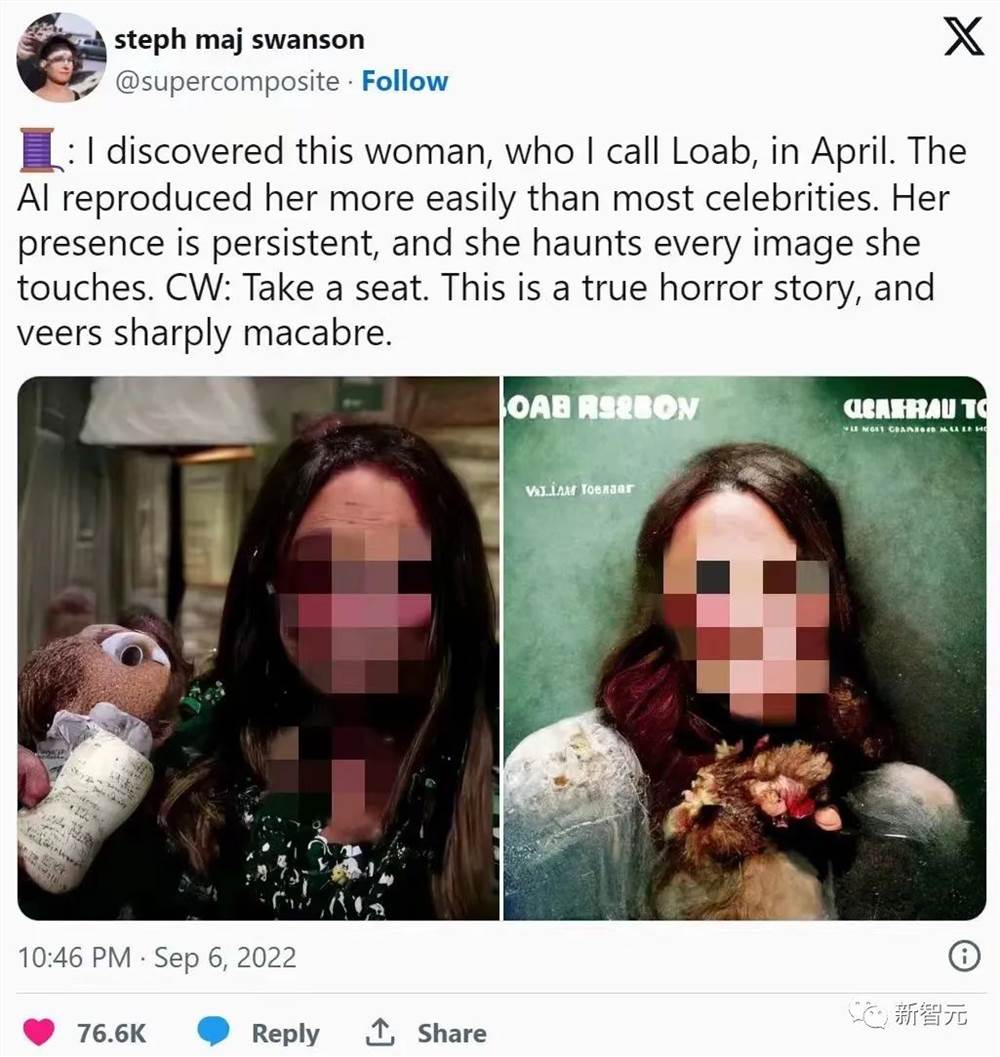

有人猜,这不会又是一个AI中的幽灵吧?

或许是ChatGPT的恐怖女士男人版?

有人想起了这样一个传说:在互联网上有大量隐藏在潜伏空间中的东西,这涉及到很多理论。

还有人猜,没准是ChatGPT被下毒了!

或者有人黑进了OpenAI,让ChatGPT随机发布自己的照片,作为战果来炫耀。

答案出乎意料

网友们集思广益,到处搜集线索,终于破案了!

这不是ChatGPT生成的照片,而是一个用户的真实自拍照。

原来,这种照片在2016年12月7日被传到Imgur上。(这张图片本来的浏览量在几百,但是随着越来越多群众围观此次事件,目前的浏览量已经变成17000多次了。)

有人猜测,事情应该是这样的:ChatGPT在生成响应的时候,随机生成了一个Imgur URL,碰巧就链到了这个自拍小伙。

ChatGPT的目标就是生成一张说明的图片,它以为自己在分享Visual Studio Code设置的截图,没想到通过Imgur链接生成的是图片。

也就是说,在ChatGPT的训练数据集之中,有许多答案包含了指向部分答案的Imgur链接,所以Imgur链接和正确答案高度相关。

但是,ChatGPT无法以统计方式自动完成随机图像链接,所以结果是不可预测的。这个小伙的照片,类似于GPT的幻觉页码。

另外一个网友也给出了类似解释:ChatGPT生了一个答案,是一个Imgur链接。

它想到了自己应该提供带答案的Imgur链接,但没有意识到自己需要的是相同的Imgur URL,相反,它竟然生成了一组随机URL。

而巧的不能再巧的是,这居然是一个有效的链接,正好链到了外国小伙的照片上。

也有人说,并不是Imgur被用于训练,而是ChatGPT能够生成Imgur链接(实际上可以说的任何链接)。

所以说,这个链接是ChatGPT随机生成的,这件事可能性有多大?

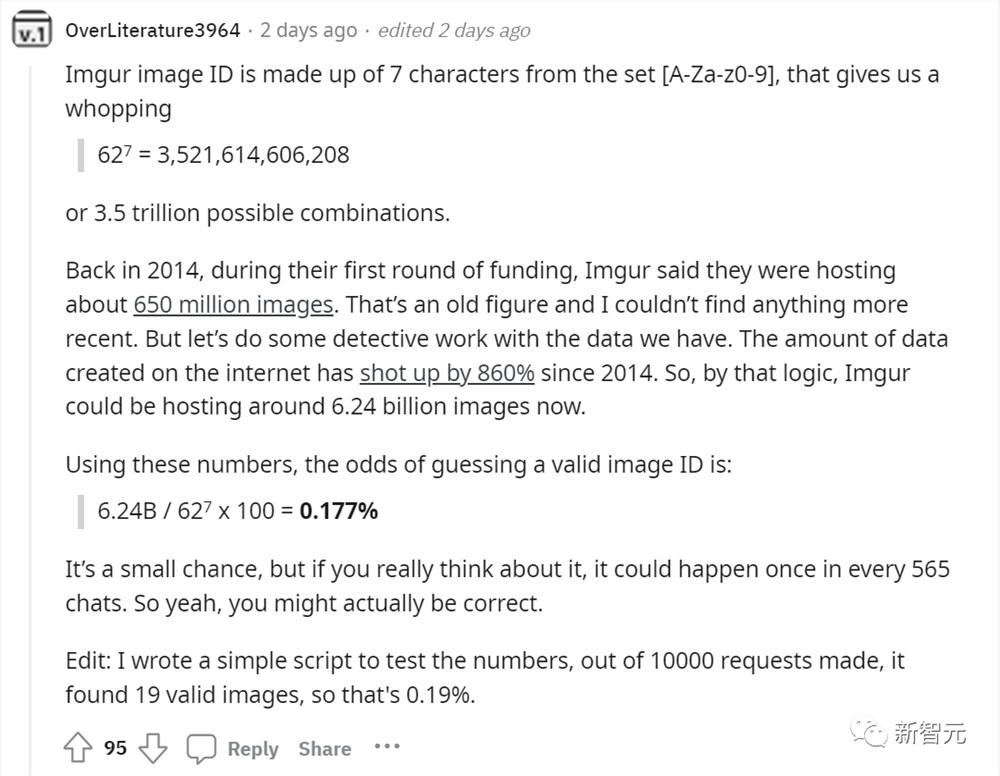

有人算出来,Imgur图像ID是由集合 [A-Za-z0-9] 中的7个字符组成,所以有 62^7=3,521,614,606,208,也就是3.5万亿种可能的组合。

Igmur在2014年第一轮融资期间,托管了大概6.5万亿张图像。推算一下,自2014年以来,互联网上创建的数据量激增了860%。按照这个逻辑,Imgur现在可以托管大约62.4亿张图像。

因此,ChatGPT猜到有效图像ID的几率是——

6.24B /62^7x100=0.177%

大概在每565次聊天中,这种事就会发生一次,所以要是说ChatGPT生成这个Imgur链接,倒也是不无可能。

层主特意写了一个简单的脚本来测试这些数字,在发出的10000个请求中,它找到了19个有效图像,所以概率是0.19%。顺便还秀了一把恩爱?

到这里,事情似乎水落石出了。

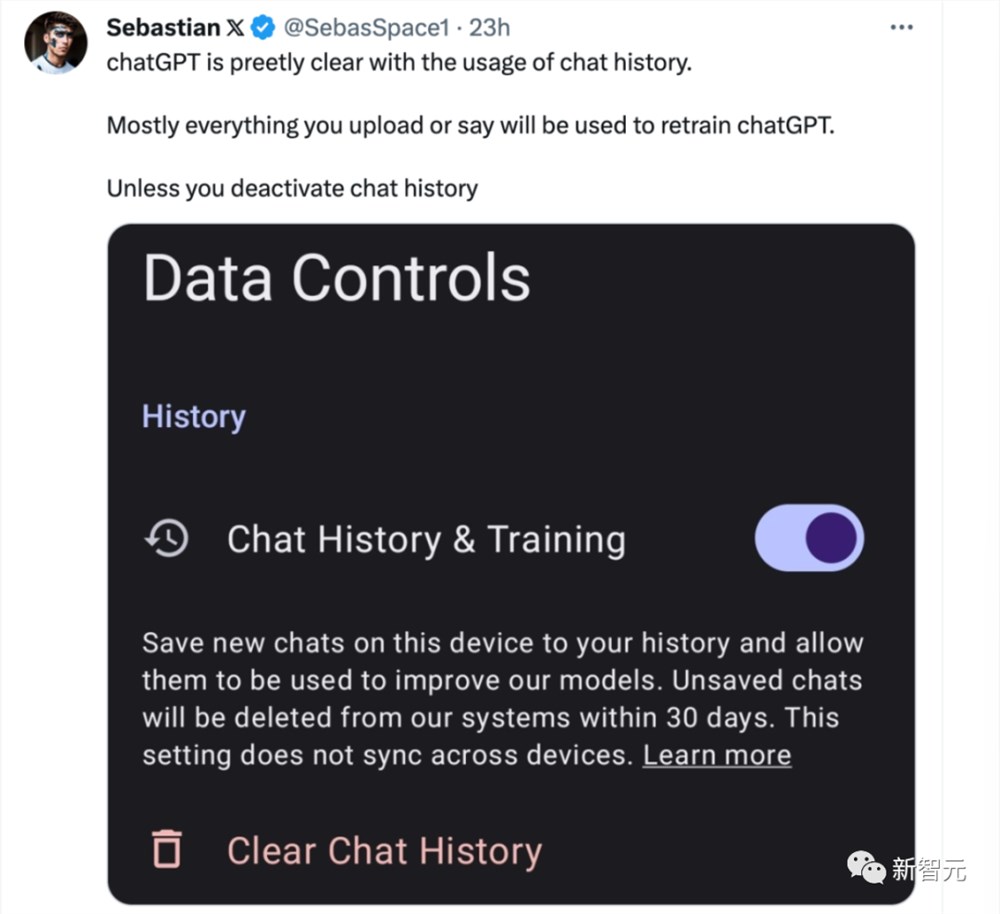

所以,要谨记自己上传或者输入的内容都会被用于训练ChatGPT,如果不想泄露隐私,切记要把上传聊天纪录的按钮关闭。

并且,任何你在互联网上留下的数字足迹,都有可能在某一天变成AI的训练数据。

总之,千万不要什么照片都发给AI,你根本搞不清它会拿你的照片去做什么。

参考资料:

https://twitter.com/thealexker/status/1719896871009694057

快来领取!华为给升级HarmonyOS NEXT Beta 版的用户送了一份见面礼

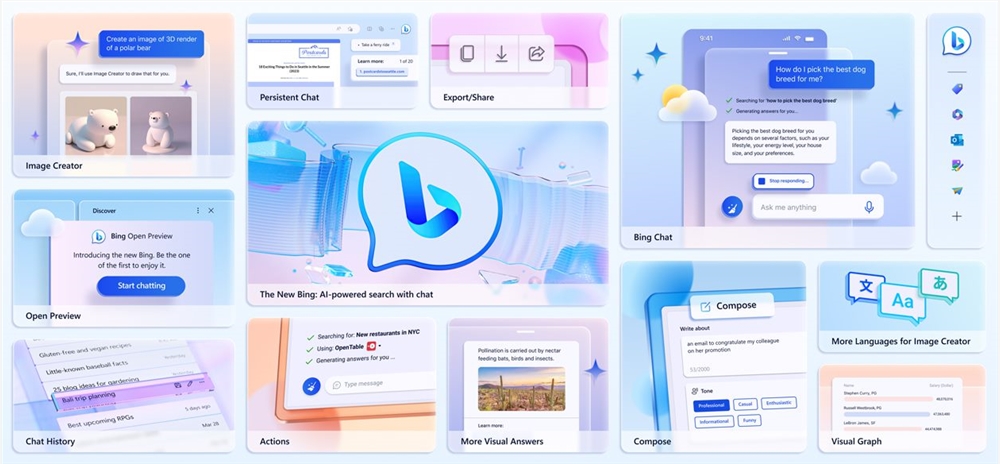

大家期待已久的纯血鸿蒙”终于来了!前段时间,HarmonyOSNEXT面向开发者和先锋用户启动Beta,受到了众多用户的支持。不少花粉纷纷第一时间报名升级,抢先感受纯血鸿蒙”带来的全新体验。站长网2024-08-17 09:51:360000微软宣布人工智能 Bing Chat 即将登陆第三方浏览器 包括移动设备

今年7月下旬,微软证实类似ChatGPT的BingChat正在第三方浏览器,如Chrome和Safari中进行测试,供特定用户使用,之前有各种报道已经注意到该功能正在运作。今天,该公司直接宣布BingChat将「很快」可以在第三方浏览器上使用,包括Web和移动设备。站长网2023-08-08 10:12:350000苹果发布 MLX 模型框架加入人工智能竞争

苹果公司在人工智能领域的保守态度一直受到人们的关注。然而,在最近的举动中,苹果悄悄发布了两个旨在在其芯片上运行的人工智能框架和模型库。这表明苹果可能正在加大其在人工智能领域的投入,并可能将生成式人工智能应用程序引入其产品。0000曝蔚来第三品牌将用增程动力!蔚来总裁秦力洪回应:仍为纯电路线

快科技11月1日消息,据财联社报道,针对今日有关蔚来第三品牌将采用混合动力产品有望2026年面世”的报道,蔚来汽车总裁秦力洪回应称:蔚来第三品牌FIREFLY萤火虫将于NIODay2024发布,继续采用可充可换可升级的纯电技术路线。而此前有媒体报道称,此前一直坚持纯电技术路线的蔚来,正在布局混合动力总成,其第三品牌萤火虫项目将采用增程式混合动力,产品有望将在2026年面世。0000蚂蚁集团入股认知大模型研发公司智谱AI

天眼查显示,10月17日,北京智谱华章科技有限公司发生工商变更,新增股东为蚂蚁集团子公司上海云玡企业管理咨询有限公司。站长网2023-10-18 21:20:110000