微软正式宣布其首款人工智能芯片 Maia 100 及基于 Arm 的通用计算芯片 Cobalt 100

微软确认了此前的传闻:该公司已自主开发了 AI 芯片,旨在训练大型语言模型,减少对 Nvidia 的依赖。此外,微软还研制了自家的基于 Arm 架构的 CPU,专为云计算工作负载设计。这两款定制硅芯片旨在为其 Azure 数据中心提供动力,为公司及其企业客户迎接充满 AI 的未来做好准备。

微软 Azure 硬件系统及基础设施部门负责人 Rani Borkar 在接受 The Verge 采访时解释道:「微软实际上在芯片开发方面拥有悠久的历史。」微软曾与 Xbox 合作开发芯片,且为其 Surface 设备共同设计过芯片。「这些努力都是基于那些经验。」她说。

Azure Maia AI 芯片和 Azure CobAlt CPU 都是微软内部研发的,结合了对整个云服务器堆栈的深度改造,以优化性能、功率和成本。「我们正在为 AI 时代重新思考云基础设施,并优化基础设施的每一层。」Borkar 表示。

Azure CobAlt CPU,以蓝色颜料命名,是一款 128 核心的芯片,基于 Arm Neoverse css 设计并为微软量身定制。它旨在为 Azure 上的一般云服务提供动力。「我们不仅考虑了性能,还特别注重功率管理。」Borkar 解释说。「我们做了一些非常有意图的设计选择,包括控制每个核心和每个虚拟机的性能和功耗。」

微软目前正在对如 Microsoft Teams 和 SQL 服务器等工作负载进行 CobAlt CPU 的测试,并计划明年为客户提供多种工作负载的虚拟机。虽然 Borkar 并未直接与亚马逊在 AWS 上提供的 Graviton 3 服务器进行比较,但在性能上应有显著提升。「我们的初步测试表明,性能比目前我们数据中心使用的商用 Arm 服务器高出 40%。」Borkar 表示。微软尚未公布完整的系统规格或基准测试。

名为 Maia 100 的 AI 加速器芯片,以明亮的蓝色恒星命名,专为运行云 AI 工作负载而设计,如大型语言模型的训练和推理。它将用于为微软在 Azure 上的一些最大的 AI 工作负载提供动力,包括与 OpenAI 合作的数十亿美元合作项目。微软一直与 OpenAI 合作,参与 Maia 的设计和测试阶段。

「当微软首次与我们分享 Maia 芯片的设计时,我们很兴奋,并与他们合作对其进行了细化和测试。」OpenAI 首席执行官 Sam Altman 说。「Azure 从头到尾的 AI 架构,现在通过 Maia 优化至芯片层面,为训练更强大的模型并降低客户成本铺平了道路。」

Maia 采用 5 纳米 TSMC 工艺制造,拥有 1050 亿晶体管,比 AMD 自家的 Nvidia 竞争对手 MI300X AI GPU的 1530 亿晶体管少约 30%。「Maia 支持我们首次实现的 8 位以下数据类型,MX 数据类型,以实现硬件和软件的共同设计。」Borkar 说。「这有助于我们支持更快的模型训练和推理时间。」

微软是包括 AMD、Arm、Intel、Meta、Nvidia 和高通在内的一群公司的成员,这些公司正致力于为 AI 模型标准化下一代数据格式。微软正在基于开放计算项目(OCP)的协作和开放工作,调整整个系统以满足 AI 的需求。

「Maia 是微软首次完全自主研发的液冷服务器处理器。」Borkar 透露。「这里的目标是在更高效率下实现服务器的更高密度。因为我们正在重新构想整个堆栈,所以我们有意思地考虑了每一层,因此这些系统实际上将适应我们当前的数据中心足迹。」

对于微软来说,关键是在不必在全球数据中心腾出空间的情况下,更快地启动这些 AI 服务器。微软设计了一个独特的机架来容纳 Maia 服务器板,其中包括一个「副驾驶」液体冷却器,就像你在汽车或豪华游戏 PC 中找到的散热器一样,用来冷却 Maia 芯片的表面。

除了分享 MX 数据类型,微软还与其合作伙伴分享了其机架设计,以便他们在其他芯片内部的系统上使用。但 Maia 芯片设计不会被更广泛地共享,微软将其保留在内部。

Maia 100 目前正在 GPT 3.5 Turbo 上进行测试,这是驱动 ChatGPT、Bing AI 工作负载和 GitHub Copilot 的同一模型。微软正处于部署的早期阶段,就像 CobAlt 一样,目前还不愿公布 Maia 的具体规格或性能基准。

这使得很难准确判断 Maia 与 Nvidia 流行的 H100 GPU、最近宣布的 H200 或甚至 AMD 最新的 MI300X 相比如何。Borkar 不愿讨论比较,而是重申 Nvidia 和 AMD 与 Azure AI 云未来的伙伴关系仍然非常关键。「在云计算的规模下,优化和整合堆栈的每一层,以最大化性能,多样化供应链,坦率地说,为我们的客户提供基础设施选择非常重要。」Borkar 说。

供应链的多样化对微软来说很重要,尤其是在 Nvidia 目前是 AI 服务器芯片的主要供应商,公司一直在争相购买这些芯片的情况下。据估计,OpenAI 为商业化 ChatGPT 需要超过 3 万颗 Nvidia 的旧款 A100 GPU,因此微软自己的芯片可能有助于降低其客户的 AI 成本。微软还为其自家 Azure 云工作负载开发了这些芯片,而不是像 Nvidia、AMD、Intel 和高通那样出售给他人。

「我更多地将这看作是补充,而不是与他们竞争。」Borkar 坚持说。「我们今天在云计算中既有 Intel 也有 AMD,同样在 AI 上,我们宣布了采用 AMD,而我们今天已经有 Nvidia。这些伙伴对我们的基础设施非常重要,我们真的想给我们的客户提供选择。」

你可能已经注意到了 Maia 100 和 CobAlt 100 的命名,这表明微软已经在设计这些芯片的第二代版本。Borkar 表示:「这是一个系列,不仅仅只有 100 而已... 但我们不会分享我们的路线图。」目前还不清楚微软将以多快的频率推出新版 Maia 和 CobAlt,但考虑到人工智能的发展速度,我对于看到类似 Nvidia H200 公告(大约 20 个月)时 Maia 100 后继者问世并不感到意外。

现在关键是微软如何迅速让 Maia 投入使用,加快实现其广泛人工智能目标,并且这些芯片将如何影响使用 AI 云服务的定价。微软暂时还没有准备好谈论这种新服务器定价,但我们已经看到该公司悄然推出了每用户每月 30 美元的 Microsoft 365 Copilot 高级版。

目前 Copilot for Microsoft 365 仅限于微软最大客户使用,企业用户必须至少承诺 300 个用户才能进入其新型 AI 助手名单。随着微软本周继续推出更多 Copilot 功能和 Bing Chat 改版计划,Maia 可能很快就能帮助平衡支持这些新体验所需求的 AI 芯片需求量。

苹果官网大降价 符合条件可退差价:仅限1月4日后购买设备用户

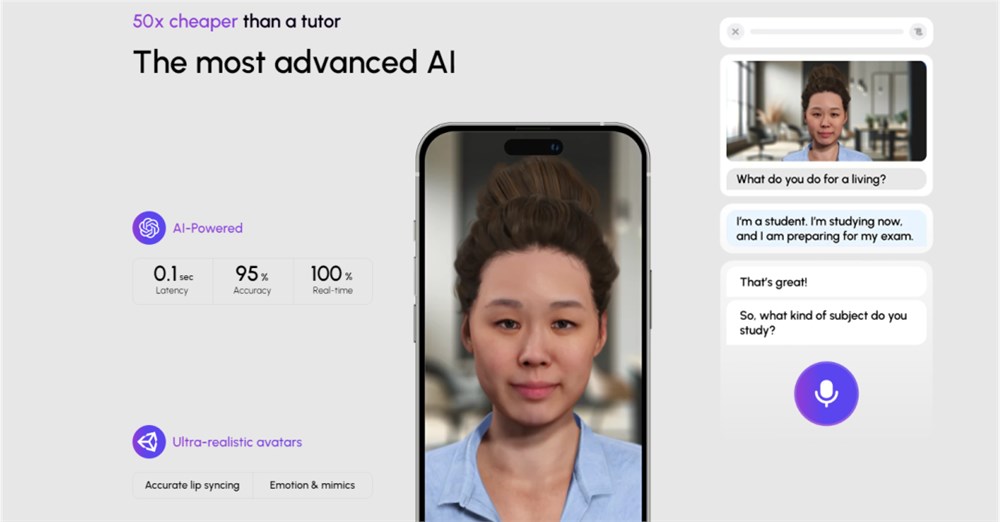

站长之家(ChinaZ.com)1月16日消息:迎新春限时优惠活动在苹果官网上线,从1月18日至21日,消费者可以享受最高800元的优惠。但这个优惠活动有一些特定的条件。站长网2024-01-16 10:32:2800003550万美元A轮融资,Praktika携手AI虚拟导师打造沉浸式英语学习课堂

大多数语言学习应用通过选择选项或滑动卡片进行互动,用户或多或少是在与机器互动。然而,Praktika则采用了不同的方法:它让用户创建个性化的AI虚拟形象,模拟真人面授导师的课堂体验,利用语音语调和情感,使语言学习更加自然。Sense思考我们尝试基于文章内容,提出更多发散性的推演和深思,欢迎交流。站长网2024-06-08 12:44:000001史玉柱:巨人在探索用AI研发游戏的平台 普通人也能做游戏

在2024年的巨人公司年会上,史玉柱发表了最新讲话,主要围绕公司在AI领域的最新探索。他特别强调了一个旨在让普通人也能开发游戏的AI游戏研发平台。史玉柱首先谈到了员工们对外部环境和公司CEO更替的疑虑。他指出,虽然外部环境面临挑战,但公司在行业中表现良好,去年前三季度收入和利润都增长了40%。他强调,公司并没有遇到冬天。站长网2024-01-27 13:04:590000去东南亚卖盲盒,潮玩企业找到新的“印钞机”?

“曼谷的每一家泡泡玛特,永远在排着长队”,在泰国生活多年的晓雨告诉Tech星球,部分活动还要提前预约,限量购买。门店站着保安,排队的消费者被警戒线隔开,分批次入场,在她看来,在当地这简直是堪比LV等奢侈品的待遇。0000一加Ace 3V采用旗舰级天工散热系统:稳坐中端机“散热冠军”宝座

快科技3月19日消息,一加宣布,一加Ace3V将搭载旗舰级天工散热系统,挑战中端手机的散热极限,官方称之为中端手机散热冠军”。据了解,一加Ace3V采用9140mm的万级VC散热面积,刷新中端手机散热面积纪录。同时,一加持续优化散热材料和结构,保障出色的性能表现,确保手机轻松释放强大性能。站长网2024-03-19 21:47:290000