浙大研究者提出UrbanGIRAFFE,解决城市场景的可控3D感知图像合成

**划重点:**

1. 🌐 UrbanGIRAFFE是浙江大学研究人员提出的一种用于逼真图像合成的方法,旨在实现可控的相机姿势和场景内容。

2. 🖼️ 该方法通过将场景分解为物体、物体和天空,利用语义体素网格和对象布局,实现对复杂城市环境的多样控制。

3. 🚀 UrbanGIRAFFE通过在合成和实际数据集上进行全面评估,展示了在可控性和保真度方面超越各种2D和3D基线的出色性能。

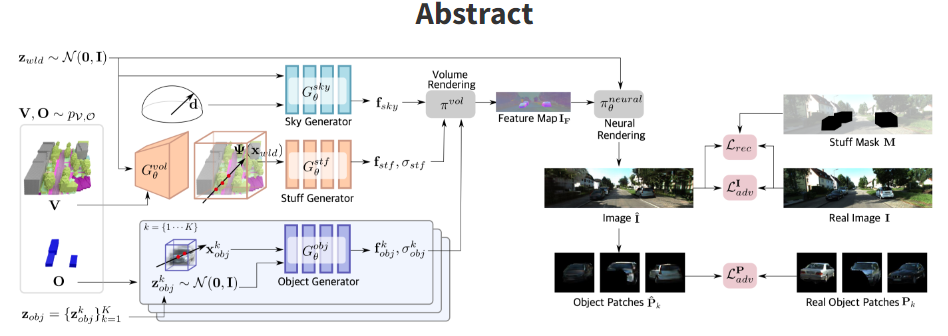

浙江大学的研究人员最近提出了一种名为UrbanGIRAFFE的创新方法,用于解决具有挑战性的城市场景的可控3D感知图像合成问题。该方法通过引入可控的相机姿势和场景内容,以实现逼真的图像合成,特别是在处理具有挑战性的城市环境时。

UrbanGIRAFFE采用了一种组合和可控的策略,利用了粗糙的3D全景先验,包括无法计数的物体和可计数的对象的布局分布。该方法将场景分解为物体、物体和天空,从而实现对场景的多样控制,如大范围相机移动、物体编辑和物体操作。

在过去的条件图像合成方法中,以生成逼真图像为目标的方法已取得了显著进展,特别是那些利用生成对抗网络(GANs)的方法。然而,现有方法主要限于以对象为中心的场景,并且在处理复杂且不对齐的城市场景时存在局限性。UrbanGIRAFFE则专注于城市场景,通过引入3D感知的生成模型,克服了这些限制,为大范围相机移动、物体编辑和物体操作提供了多样的可控性。

UrbanGIRAFFE的创新之处在于将城市场景巧妙地分解为无法计数的物体、可计数的对象和天空,利用先验分布来理清复杂的城市环境。该模型包括一个条件物体生成器,利用语义体素网格作为物体先验,以集成粗糙的语义和几何信息。通过在混乱的场景中学习对象生成器的对象布局先验,模型在对抗性和重构损失的端到端训练中得以优化,利用射线-体素和射线-盒交叉策略来优化采样位置,减少所需采样点的数量。

在全面的评估中,UrbanGIRAFFE方法在合成和真实数据集上超越了各种2D和3D基线,展示了出色的可控性和保真度。在KITTI-360数据集上进行的定性评估显示,UrbanGIRAFFE在背景建模方面优于GIRAFFE,实现了增强的物体编辑和相机视角控制。在KITTI-360上进行的剖析研究证实了UrbanGIRAFFE的架构组件的有效性,包括重构损失、对象判别器和创新的对象建模。在推断期间采用移动平均模型进一步提高了生成图像的质量。

UrbanGIRAFFE的未来工作包括引入语义体素生成器,以进行新颖场景采样,并通过光-环境颜色解缠来探索光照控制。文章强调了重构损失的重要性,以保持保真度并产生多样的结果,尤其是对于不经常遇到的语义类别。

该研究展示了UrbanGIRAFFE在处理具有挑战性的城市场景的可控3D感知图像合成问题方面的卓越成就,实现了在相机视角操作、语义布局和物体交互方面的卓越多功能性。通过利用3D全景先验,该模型有效地将场景分解为物体、物体和天空,促进了组合生成建模。未来的研究方向包括整合语义体素生成器以进行新颖场景采样,并通过光-环境颜色解缠来探索光照控制。 UrbanGIRAFFE通过在合成和实际数据集上进行全面评估,展示了在可控性和保真度方面超越各种2D和3D基线的出色性能。

项目网址:https://github.com/freemty/urbanGIRAFFE

https://lv3d.github.io/urbanGIRAFFE/

论文:https://arxiv.org/abs/2303.14167

意大利制造商Piaggio推出AI驱动的工厂机器人 可携带130公斤物品

划重点:-🤖Vespa制造商Piaggio推出了一款使用人工智能的工厂机器人,可自主移动在预设路线上,并可携带高达130公斤的物品。-🏍️该机器人将首先应用于意大利摩托车品牌MotoGuzzi的生产线,随后将在意大利、印度、越南和印度尼西亚的其他工厂中使用。0000Roblox的目标是通过生成AI工具实现类似西部世界的轻松设计

Roblox首席执行官DavidBaszucki在Roblox2023年第二季度收益电话会议上表示,他设想其生成式人工智能系统有朝一日可能以类似于科幻剧《西部世界》的方式工作。与AI如何帮助Roblox开发人员有关的较长回答中,提到了与《西部世界》的比较。站长网2023-08-10 16:12:300000腾讯视频上线JUMP会员:学生包年148元 最高可享8大权益

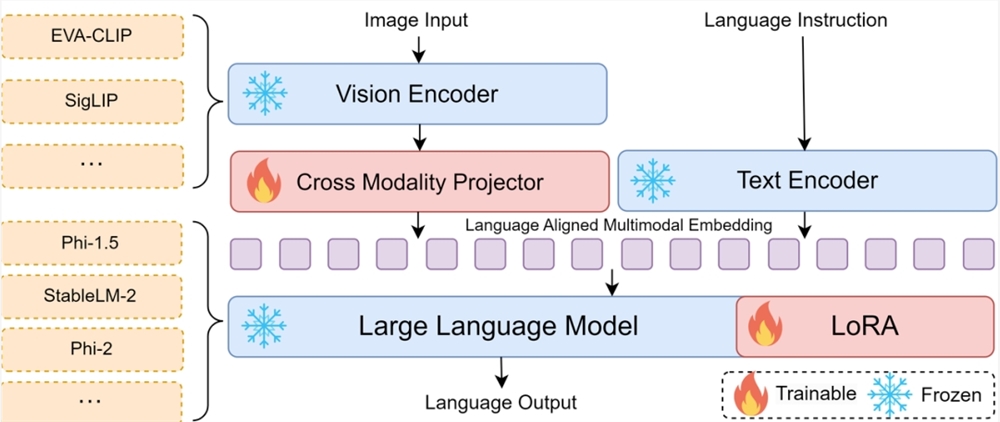

快科技5月13日消息,今日,腾讯视频宣布全新JUMP会员正式上线,官方表示这是年轻人的专属套餐。同时,腾讯视频宣布原学生会员”升级为JUMP学生会员”。据了解,首期上线JUMP卡套餐和JUMP学生卡套餐,包含观看、互动、生活、娱乐等权益福利,不同套餐包含的权益不同。价格上,JUMP卡包年199元、分期月付25元;JUMP学生卡包年148元、分期月付15月。站长网2024-05-13 13:51:320000智源研究院推出新一代多模态小模型Bunny-3B

智源研究院近期提出了一项新技术,通过数据浓缩技术获得高质量训练数据,从而提升多模态小模型的性能。具体来说,他们将LAION-2B压缩成2M核心集,得到更丰富的预训练数据,同时精选数据集进行指令微调,训练出性能强劲的小模型。这一技术路线带来了新一代多模态小模型Bunny系列,其中Bunny-3B表现出色,在多个基准上超越了其他近期热门模型,与大模型相媲美。站长网2024-02-23 09:55:220004为防学生用ChatGPT作弊,大学教授开始恢复纸质考试或改用口试,网友:幸好已毕业

用口试学生社恐咋搞?教授们真被ChatGPT逼急了——不等到开学,就表示新一学期考核要用回最原始的纸质考试或改用口试。大费周折,为的就是防止考试中学生用ChatGPT作弊。还沉浸在美好暑期生活中的学生们,大概率还没意识到开学要迎接啥。这还得归因于ChatGPT在诸多测试中表现良好,且生成的内容难以识别,查重也可躲过,一些学生用它写作业屡试不爽。站长网2023-08-19 13:07:130000