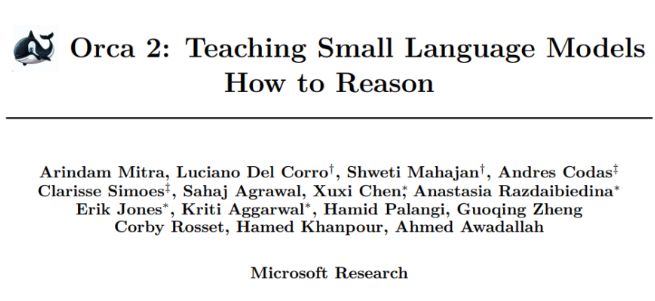

微软Orca 2完胜!推理能力与5-10倍大小的模型相当

站长网2023-11-23 14:44:453阅

要点:

1、Orca2是一个13亿参数的语言模型,通过增强的训练信号提高了小型语言模型的推理能力,与5-10倍于其大小的模型相比具有相当甚至更好的性能。

2、Orca2旨在教导小型语言模型利用一系列推理技巧,并帮助其确定适合特定任务的最有效推理策略。

3、Orca2通过采用谨慎推理技术,即 Prompt Erasure,不仅可以执行具体的推理步骤,还可以在更高层面上制定任务处理策略。

微软研究团队推出的13亿参数模型 Orca2在近期发布的一篇论文中探索了如何提升小型语言模型的推理能力。通过增强的训练信号,Orca2能够在与其大小相似的模型中取得与5-10倍更大的模型相媲美甚至更好的性能。

Orca2的目标是教导小型语言模型采用一系列推理技巧,并帮助其确定对于特定任务最有效的推理策略。与其前身 Orca1类似,研究团队借鉴了更强大的大型语言模型的推理策略,并根据小型模型的能力进行了细致调整。

Orca2采用了一种谨慎推理技术,即 Prompt Erasure,使其成为一种谨慎的推理者。这种技术使模型不仅能够执行具体的推理步骤,还能够在更高层面上制定任务处理策略。与盲目模仿强大的大型语言模型不同,研究团队将其视为行为库,从中精心选择适合当前任务的行为。

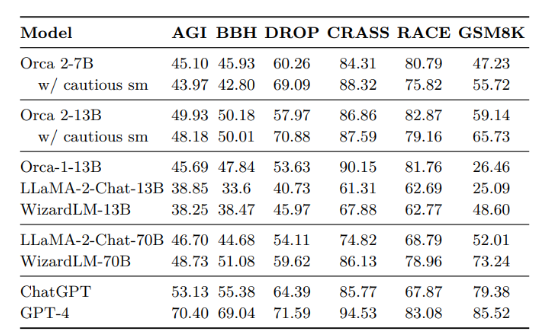

在实证研究中,研究人员对 Orca2在15个基准测试中进行了全面评估,涵盖了约100个任务和超过36,000个独特提示。结果显示,Orca2在与其大小相似的模型上明显优于它们,甚至在需要高级推理的任务上与5-10倍更大的模型相媲美甚至超过。

这项工作标志着推动小型语言模型推理能力的重要一步。研究团队相信,提升小型模型的能力将为不同的应用部署场景开辟新的可能,并在效率和功能之间找到平衡。

0003

评论列表

共(0)条相关推荐

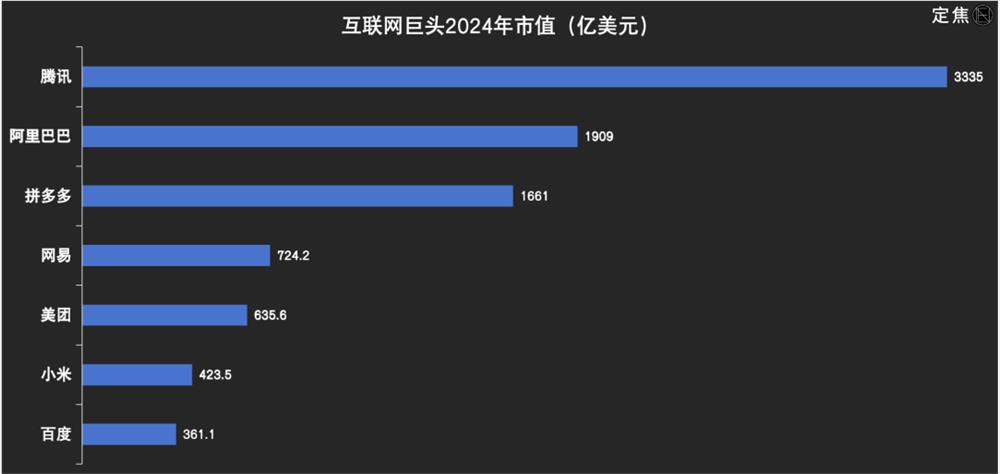

年入千亿、逼急腾讯,丁磊赚麻了?

过去,在人们给互联网公司排座次时,总是将目光集中在那些王者和挑战者身上。比如,腾讯与阿里巴巴,美团与拼多多。网易这家公司,好像被“遗忘”已久,因为它老了,且太过稳定。这家成立于1997年的公司,曾让丁磊登上首富宝座,还生长出两家上市公司——网易有道和网易云音乐。但这家公司的各项业务总是处在行业老二的位置,游戏业务和音乐业务都排在腾讯后面,市值也通常排在第六或第七。站长网2024-03-01 09:26:340000用活人脑细胞构建AI系统,语音识别准确率提升至78%

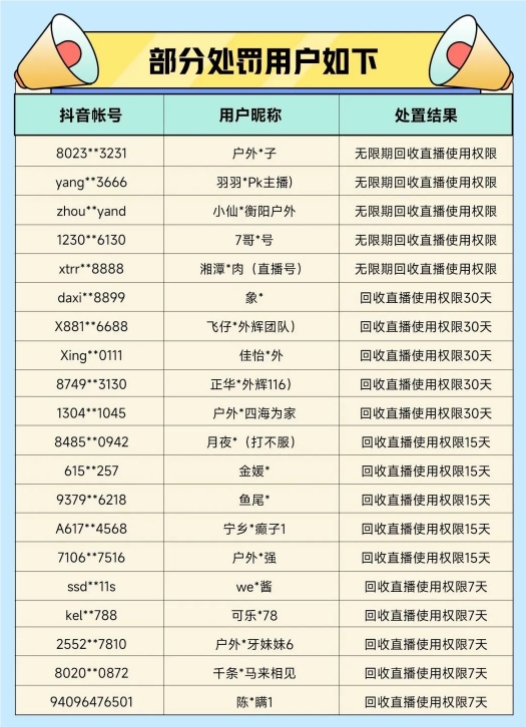

要点:1、用活人脑细胞构建AI系统,语音识别准确率大幅提升;2、新型系统可以进行无监督学习,并具有类似神经网络的功能;3、系统的学习能力取决于脑类器官中神经细胞之间的连接。0000今年以来,抖音直播处置户外低俗直播行为帐号27W+个

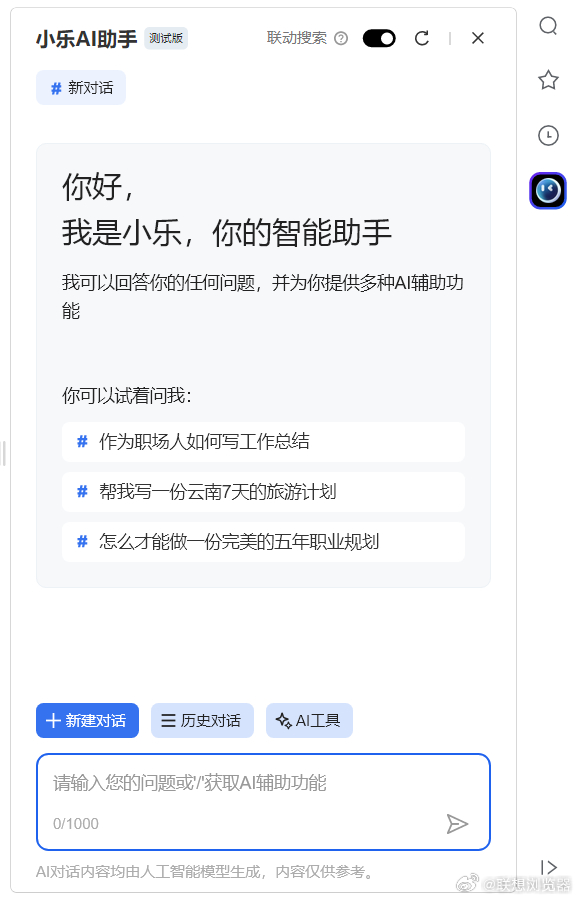

今日,抖音直播发布了关于整治户外直播乱象的处置公示第四期内容。2023年1月至今共处罚涉及户外低俗直播行为的帐号271,919个。站长网2023-04-16 08:06:440000联想浏览器推出小乐 AI 助手:集成百度文心一言大模型

站长之家(ChinaZ.com)8月7日消息:联想浏览器微博消息,联想浏览器今日发布了9.0.2.7311正式版本,并新增了小乐AI助手的测试版。根了解,这款AI助手集成了百度的文心一言大模型。经过实际测试,用户可以向小乐AI助手测试版询问「你是文心一言吗」,并会得到肯定的回答。助手介绍自己能够与人对话互动,回答问题,协助创作,帮助人们获取信息、知识和灵感。站长网2023-08-07 17:37:390000月销破亿,被嘲“美丽刑具”,光腿神器是怎样炼成的?

如果提名今年热度最高的时尚单品,除了精准拿捏大学生的军大衣,让无数女孩疯狂下单的光腿神器一定榜上有名。随着天气逐渐转冷,淘宝、抖音、快手等各平台直播间纷纷上架不同款式、不同价位的光腿神器,吸引无数消费者下单。以抖音为例,据新榜旗下抖音数据工具新抖统计,光腿神器品牌小野和子近30天累计销售额破亿,觅橘、茉寻、她琳talin等品牌的月销售额也均在千万以上。0000