NVIDIA提出 Tied-Lora:提高LoRA方法的参数效率 用13%参数实现性能与标准LoRA方法相媲美

**划重点:**

1. 🚀 NVIDIA的研究人员开发了一种名为Tied-LoRA的新技术,旨在提高LoRA方法的参数效率。

2. 🔄 Tied-LoRA通过权重绑定和选择性训练,寻找性能和可训练参数之间的最佳平衡。

3. 📊 在不同任务和基础语言模型上进行的实验证明,Tied-LoRA可以在只使用标准LoRA方法13%的参数的情况下实现可比较的性能。

一组来自NVIDIA的研究人员近日提出了一种名为Tied-LoRA的新技术,旨在改善低秩适应(LoRA)方法的参数效率。该方法采用了权重绑定和选择性训练的策略,以寻找性能和可训练参数之间的最佳平衡。

最近,对于参数高效微调技术的不断进展包括LoRA,通过低秩矩阵逼近减少可训练参数。AdaLoRA是LoRA的扩展,引入了动态秩调整,并将适配器调整与LoRA相结合。另一种技术是由Kopiczko提出的VeRA,通过冻结矩阵和可训练的缩放向量减少参数。QLoRA使用量化的基础模型实现内存高效的LoRA。该研究对低秩权重矩阵应用权重绑定,进一步增强了参数效率。

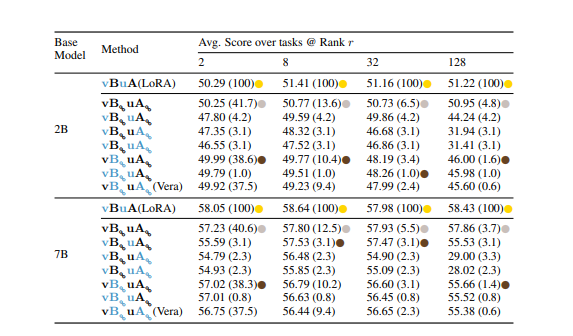

为了解决为下游任务对语言模型进行微调的计算开销,Tied-LoRA是一种结合了权重绑定和选择性训练的新方法,旨在提高LoRA的参数效率。通过在不同研究和基础语言模型上进行系统实验证明,研究人员确定了一个特定的Tied-LoRA配置,其性能可与标准LoRA方法相媲美,但只使用了13%的参数。

Tied-LoRA是一种通过将权重绑定和选择性训练结合起来,增强LoRA方法参数效率的方法。它通过将权重绑定应用于LoRA中的低秩矩阵,使基础语言模型中的各层共享相同的后果,从而降低了可训练参数的数量。

该方法探索了参数训练/冻结和权重绑定的各种组合,以实现性能和可训练参数之间的最佳平衡。在不同任务和两个基础语言模型上进行的实验中,不同的Tied-LoRA配置展示了效率和性能之间的权衡。特定的Tied-LoRA配置vBuA在性能方面表现优异,相较于其他配置减少了87%的参数。在抽取式问答、摘要和数学推理等任务的评估中,展示了Tied-LoRA在提高参数效率的同时显著保持了竞争性能。

通过在各种任务上进行实验后,发现Tied-LoRA是一种通过利用权重绑定和选择性训练增强LoRA方法参数效率的新范例。

结果表明,Tied-LoRA可以替代通识NLI、抽取式QA和摘要等功能。此外,它在不影响性能的情况下提供了改进的参数效率,仅使用标准LoRA的13%的参数。然而,讨论与其他参数效率方法的限制和比较对于确定未来探索的潜在领域至关重要。

论文网址:https://arxiv.org/abs/2311.09578

无需展示付款码 支付宝新体验手机“碰一下”即可支付

7月8日,在支付宝开放日上,支付宝宣布升级条码支付体验,推出“支付宝碰一下”,用户无需展示付款码,解锁手机碰一下商家收款设备,最快一步完成支付。支付宝“碰一下”最快3步合1支付更直接相比已有的支付宝“扫一下”,“碰一下”更加简单直接。原本用户需要进入支付宝App后点付款码,步骤分3步,而“碰一下”直接拿手机碰一下最快1步完成支付。(图为支付宝升级条码支付推出“支付宝碰一下”)站长网2024-07-09 04:45:020000OpenAI 有望在两到三年内成为价值万亿美元的公司

划重点:-李开复对OpenAI在未来两到三年内成为一家价值万亿美元的公司感到乐观。-💡李开复对OpenAI在技术上的卓越表现表示赞赏,但对其缺乏开放性表达了关切。-💡OpenAI最近发布了GPT-4o,具备文本、视觉和音频的“全能”能力,并计划将其免费提供给用户。中国投资者和连续创业者李开复最近表示,他看好OpenAI在两到三年内成为一家万亿美元的公司。站长网2024-05-27 16:34:050000荣耀大事件尘埃落地!官网全新域名honor.com今日正式启用

快科技3月31日消息,两天前,荣耀官方发布了一条意味深长的微博,配图仅有简单的Hi,honor”字样并搭配倒计时2天,配文字越少事越大”。而荣耀官网主页则直接横幅显示Hi,honor”倒计时,在周日(3月31日)0点结束。今日,荣耀官网倒计时结束,荣耀大事件终于尘埃落地,原来是荣耀启用了全新的honor.com的域名,此前荣耀官网域名为hihonor.com。站长网2024-04-06 14:16:140000Y Combinator 创始人 Paul Graham:股市投资者正在错失 AI 热潮

著名风险投资家、企业家和创业加速器YCombinator的联合创始人保罗·格雷厄姆(PaulGraham)表示,公开市场投资者错过了参与人工智能热潮的潜在途径,因为所有值得投资的优秀公司仍然是私人公司。站长网2023-06-05 21:29:310001“和6个美女谈恋爱”,短剧游戏能火多久?

“浩浩不能没有爸爸”“只想给浩浩一个家”。如果你能看懂这两个梗,那你最近一定玩过或者看游戏UP主玩过《完蛋!我被美女包围了》(下称《完蛋》)。这款游戏并不复杂,和游戏名字一样,简单概括就是,玩家用第一视角沉浸式与六位美女“谈恋爱”。而浩浩是这款游戏中一位辣妈角色林月清的儿子。与大多数游戏不同的是,这六位美女都由真人扮演,剧情演进不再是“动态PPT”而是视频。站长网2023-11-10 13:56:470000