Adobe发布创新的DMV3D方法 单个A100生成3D图像只需30秒

要点:

1. Adobe研究院和斯坦福大学的研究者提出了一种基于Transformer的3D生成方法DMV3D,利用单个A100GPU仅需30秒即可生成各种高保真3D图像。

2. DMV3D是一种全新的单阶段全类别扩散模型,通过2D多视图图像扩散、3D NeRF重建和渲染的集成,实现端到端的训练,避免了传统3D生成方法中的问题。

3. 通过使用稀疏的多视图投影作为训练数据,DMV3D能够在单个图像或文本输入的情况下实现3D生成,取得了在单图像3D重建方面的State-of-the-Art(SOTA)结果,超越了先前方法。

近期,Adobe研究院和斯坦福大学的研究者推出了一项创新的3D生成方法,命名为DMV3D。通过基于Transformer的新型单阶段全类别扩散模型,该方法能在单个A100GPU上仅需30秒的时间内生成高保真3D图像。DMV3D通过将2D多视图图像扩散、3D NeRF重建和渲染集成到一个端到端的训练过程中,成功避免了传统方法中的问题。

论文地址:https://arxiv.org/pdf/2311.09217.pdf

官网地址:https://justimyhxu.github.io/projects/dmv3d/

这项研究的关键在于使用稀疏的多视图投影作为训练数据,以解决传统3D生成方法中存在的模糊和难以去噪的问题。相比之下,DMV3D展示了在单个图像或文本输入的情况下实现3D生成的能力。通过固定一个稀疏视图作为无噪声输入,并对其他视图进行类似于2D图像修复的降噪,DMV3D能够在30秒内生成各种高保真3D图像,这一成果超越了先前基于SDS的方法和3D扩散模型。

研究者还介绍了DMV3D的训练和推理过程,包括基于重建的多视图降噪器的构建、多视图扩散和去噪的方法以及模型的时间和相机调节。此外,通过引入文本或图像的条件降噪器,DMV3D实现了可控的3D生成,为无条件生成模型提供了更多可能性。

这一创新方法的提出对于AI视觉领域的3D生成研究具有重要意义,不仅在技术上解决了传统方法的问题,而且在性能上取得了SOTA的成果。该研究为未来的VR、AR、机器人技术和游戏等应用领域提供了新的可能性。

谷歌拟在Google Assistant中引入大语言模型技术

据9to5google的报道,谷歌宣布将对GoogleAssistant进行更新,并引入大语言模型技术。目前,安卓版的GoogleAssistant已经加入了一项由AI驱动的功能,可以帮助用户总结当前网页的内容,这对于那些需要快速了解网页主要内容的用户来说是非常方便的。未来,谷歌还计划将更多生成式功能引入到移动版的GoogleAssistant中,这将会为用户提供更加智能化的服务。站长网2023-08-01 08:41:300002华为盘古大模型能源领域首次商用 盘古矿山大模型发布

今日,山东能源集团、华为、云鼎科技联手发布全球首个商用于能源行业的AI大模型——盘古矿山大模型。作为AI大模型在能源领域的全球首次商用,山东能源、云鼎科技、华为在前期试点验证AI大模型赋能工业生产领域的基础上,正在开发和实施首批场景应用,涵盖采煤、掘进、主运、辅运、提升、安监、防冲、洗选、焦化9个专业21个场景应用。站长网2023-07-18 17:22:580000游族网络与腾讯云达成战略合作 加速AI人工智能在游戏领域落地

11月23日,游族网络与腾讯云正式签署战略合作协议。依托腾讯云全球化节点布局以及游戏技术积累,双方将共同加速人工智能在游戏领域的技术创新与应用落地,为全球游戏玩家提供专业服务,共同推动游戏行业技术发展。未来,双方将有更紧密的合作,游族的存量与增量游戏,将更多地部署在腾讯云上。腾讯云也将针对合作项目进行专项扶持,为游族网络持续提升长线运营能力保驾护航。站长网2023-11-23 13:57:240000Redmi Note 13系列首销战报:1小时销量超41万台

今天上午10点,RedmiNote13Pro系列手机正式开售。根据Redmi发布的首销战报,该系列手机在开售1小时内的销量就超过了41万台。RedmiNote13Pro系列共有三种型号可供选择,分别是Note13、Note13Pro和Note13Pro。它们的起售价分别为1099元、1399元和1899元。站长网2023-09-26 16:48:030000随着新鲜感的消失 ChatGPT流量下降了约 10%

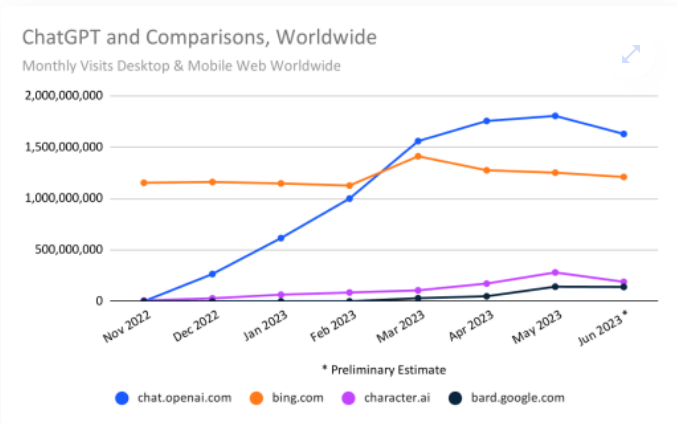

ChatGPT在成为世界上访问量最大的网站后流量或许不会再增长了。换句话说,Google不会因为OpenAI技术演示网站而黯然失色,而OpenAI技术演示网站已成为一种文化现象。此外,ChatGPT飙升的流量增长开始趋于平稳,但这是其实际下降的第一个月。站长网2023-07-05 17:28:230001