大型语言模型DeBERTa:具有解纠缠注意力的解码增强型 BERT

站长网2023-11-29 11:07:310阅

近年来,BERT在自然语言处理任务中取得显著成就,但DeBERTa通过引入“解缠注意力”和“增强遮罩解码器”等创新机制,进一步提升了模型性能。

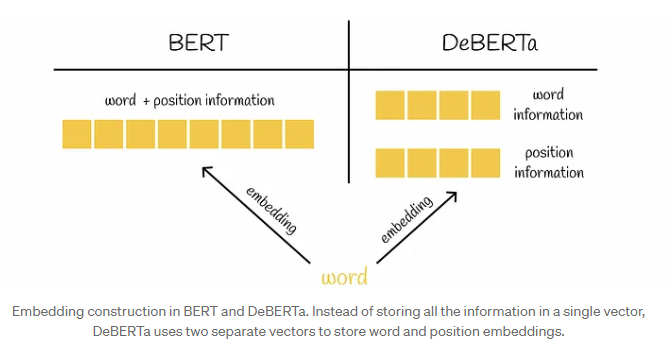

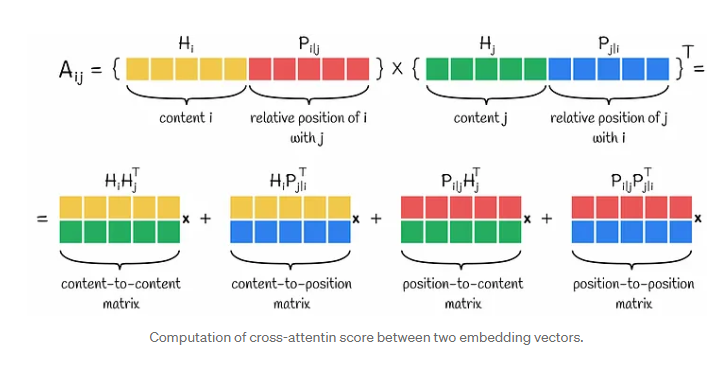

DeBERTa引入了解缠注意力,这是一种新颖的机制,其中每个令牌由两个单独的向量表示,考虑了内容和相对位置。注意力分数是使用一种独特的方法计算的,该方法考虑了令牌之间的相对距离。

论文地址:https://arxiv.org/pdf/2006.03654.pdf

DeBERTa通过引入增强蒙版解码器(EMD)来解决解缠注意力的局限性,该解码器包含绝对位置信息。这种添加提高了模型捕捉语言上下文的能力,例如对具有相似局部上下文但具有不同语言上下文的蒙版词的处理。

解缠注意力考虑内容和相对位置,通过独特的计算方法获得注意力分数。增强遮罩解码器解决了解缠注意力对绝对位置信息的忽略,提高了模型对语境的理解。

DeBERTa的架构包括多个EMD块,每个块都使用隐藏状态和解码所需的附加信息。研究表明,包括位置到内容注意力,内容到位置注意力和EMD在内的所有组件都有助于模型的性能。还引入了尺度不变微调技术以增强模型的泛化能力。DeBERTa有三个变体,具有不同的性能指标和数据集大小。

这些创新和改进使得DeBERTa成为自然语言处理领域备受青睐的选择,不仅在数据科学家中广泛应用,还在Kaggle竞赛中取得成功,甚至在SuperGLUE基准测试中超越人类水平,为语言模型的发展留下浓墨重彩的一笔。

0000

评论列表

共(0)条相关推荐

谷歌前 CEO:人工智能或给人们带来「伤害或死亡」的灾难性风险

人工智能可能带来灾难性的风险,前谷歌CEO埃里克·施密特周三警告说,他表示政府需要知道如何确保该技术不被「邪恶人士滥用」。人工智能的未来已经成为技术专家和决策者们讨论的焦点,他们正在探讨该技术的发展方向以及应如何进行监管。去年引起广泛关注的聊天机器人ChatGPT,可以说更加提高了人们对人工智能的认知,世界各大公司都在努力推出竞争产品并宣传其人工智能能力。站长网2023-05-25 10:07:310000AI 杀死了程序员培训班:花 1.3 万美元学编程,却连面试机会都没有?

曾几何时,编程培训班被视为高薪职业的“入场券”;而如今,AI工具却能在几秒钟内完成初级程序员的工作。时代在变,新人程序员又该何去何从?核心观点随着新兴AI工具开始成为主流,科技行业也收窄了招聘通道。在充斥着陈词滥调的求职建议当中,“学习编程”已经逐渐转变为“学习AI技能”。并不是AI取代了软件工程师,而是新手们更难有机会成长为合格的软件工程师。站长网2025-01-23 18:09:120000QQ飞车上线薛之谦跑车,网友的嘴角比AK都难压!

游戏圈请明星代言,并不是什么新玩法。从拍摄广告片、演唱主题曲,到公开体验游戏、参与游戏制作,明星与游戏的合作,早就从提高知名度迈向了下一个阶段。不过最近,兵法先生看到一个非常超前的案例——QQ飞车与薛之谦的联动。站长网2024-07-05 16:48:540001农村卖家,为什么都在拼多多?

9月下旬,一斤东北西瓜要卖多少钱?在北京广安门的超市,答案是两块六毛;在朝阳区的一家社区水果店,答案是两块九毛;在北京新发地农贸市场露天广场的大卡车旁,答案是一块一毛;在吉林白城的收购商那里,答案是八毛;在东北农民的西瓜田里,答案是五毛。图源备注:图片由AI生成,图片授权服务商Midjourney从产地农民到一线城市消费者手里,价格增长400%几乎是一种常态。站长网2024-10-07 02:21:150000县城青年春节摆摊,勇敢的人先月入过万

春节的野路子副业年轻人在工作后才发现,“有钱没钱,回家过年”实际很难套用在现实生活中,成年后的无数个春节自然会让人懂得:有钱回家,才能过个好年。年货礼品、新衣打扮、人际往来的必要支出,能在新年期间快速榨干一个普通年轻人的钱包。即便除去“面子消费”,还是有不少县城青年,会提前两个月就陷入“心有力而余额不足”的困境。站长网2024-01-31 13:59:470000