研究人员发布Starling-7B:基于AI反馈的大语言模型 媲美GPT-3.5

**划重点:**

1. 🚀 **RLAIF技术介绍:** Starling-7B采用了基于AI反馈的强化学习(RLAIF),通过优化Openchat3.5和Mistral-7B而成。

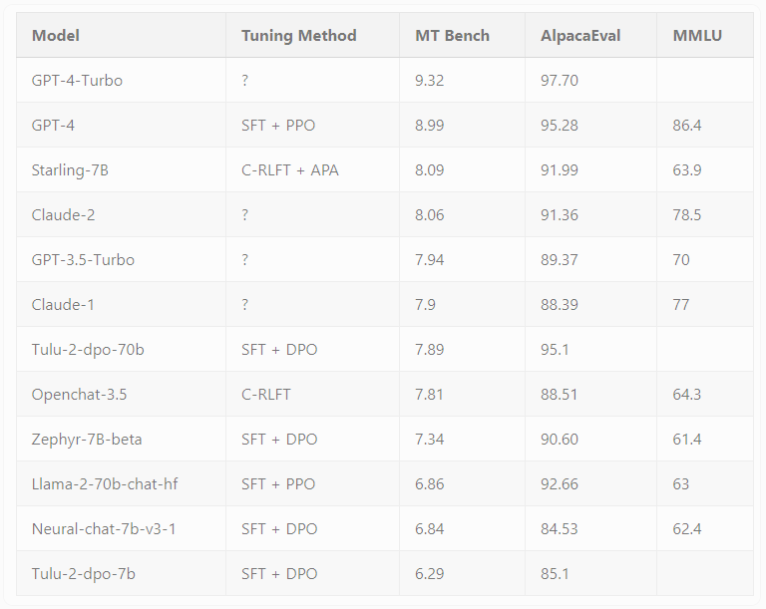

2. 📊 **性能卓越:** 在MT-Bench和AlpacaEval两项基准测试中,Starling-7B表现出色,对比其他模型的性能提升引人瞩目。

3. 🔄 **迈向人性化:** RLAIF主要改善了模型的实用性和安全性,未来计划通过引入高质量的人工反馈数据,更好地满足人类需求。

UC伯克利的研究人员最近发布了Starling-7B,这是一款基于AI反馈强化学习(RLAIF)的开放式大语言模型(LLM)。该模型基于精调的Openchat3.5,并继承了Mistral-7B的特性。

在RLAIF中,研究人员借助其他AI模型的反馈来训练Starling-7B,以提升其聊天机器人响应的实用性和安全性。与以往ChatGPT中通过人类反馈进行的强化学习(RLHF)相比,RLAIF更具成本效益,速度更快,透明度更高,且可扩展性更强。

为了使用RLAIF训练模型,研究人员创建了Nectar数据集,其中包含183,000个聊天提示,每个提示有七个响应,总计3.8百万个成对比较。响应来自不同的模型,包括GPT-4、GPT-3.5-instruct、GPT-3.5-turbo、Mistral-7B-instruct和Llama2-7B。研究人员通过GPT-4对合成响应进行评分,并采用独特方法规避了GPT-4的偏见,将第一和第二响应评分最高。

Starling-7B在两个基准测试,MT-Bench和AlpacaEval中表现卓越。Starling-7B 在 MT-Bench 中的表现优于除 OpenAI 的 GPT-4和GPT-4Turbo之外的大多数模型,并且在 AlpacaEval 中取得了与 Claude2或 GPT-3.5等商业聊天机器人相当的结果。与普通 Openchat3.5相比,在 MT-Bench 中,分数从7.81增加到8.09,在 AlpacaEval 中,分数从88.51% 增加到91.99%。研究人员指出,RLAIF主要改善了模型的实用性和安全性,但并未影响其回答基于知识、数学或编码的问题的基本能力。

虽然基准测试结果在实际应用中有一定限制,但对于RLAIF的应用来说,结果仍然令人鼓舞。研究人员指出,下一步可能是通过引入高质量的人工反馈数据扩充Nectar数据集,以更好地调整模型以满足人类需求。

Starling-7B展示了AI反馈在强化学习中的潜力,为构建更符合人类喜好的模型打开了新的可能性。研究人员强调,尽管Starling-7B在一些需要推理或数学任务上仍存在困难,并有幻觉倾向,但其性能仍然可圈可点。

研究人员已经发布了Nectar数据集、与之相关的Starling-RM-7B-alpha奖励模型以及基于该数据集训练的Starling-LM-7B-alpha语言模型,这些可以在Hugging Face上获得。他们计划在不久的将来发布代码和论文,供研究使用。对于对模型进行测试,读者可以参与聊天机器人竞技场。

项目网址:https://huggingface.co/berkeley-nest/Starling-LM-7B-alpha

AI研究称人类指纹并非独一无二

划重点:1.🔄研究指出人类指纹可能不独一无二2.🤖AI模型通过分析超过60,000个指纹找到相似性3.🧐研究者声称AI模型可用于指纹关联,但在法医学领域引起争议站长网2024-01-15 13:43:25000092岁默多克宣布11月辞去福克斯和新闻集团董事会主席

据报道,福克斯和新闻集团今日宣布,92岁的罗伯特·默多克将于11月辞去两家公司的董事会主席一职。默多克在给员工的信中表示,他计划在卸任后,以不同的角色继续参与公司事务。届时,默多克将被任命为荣誉董事长,他的儿子拉克兰·默多克将成为新闻集团的唯一董事长,并继续担任福克斯集团的执行董事长兼CEO。默多克在信中表示,自己和公司都很健康,对未来几年持乐观态度。站长网2023-09-22 10:34:350000ReplicaStudios:用AI训练属于个人的旁白声音

ReplicaStudios是领先的平台,用于制作和训练个人的旁白声音,适用于游戏开发者、视频创作者和普通用户。旁白合成技术广泛应用于电子游戏开发和电视节目配音等领域。其中一个最有益的应用是为那些由于肌萎缩侧索硬化等疾病而无法说话的病人提供合成声音。通过在失语前记录声音,可以生成病人声音的复制版本,并应用于语音辅助设备。站长网2023-08-15 11:06:140000Opera:与OpenAI展开全面合作 推出“AI Prompts”等原生功能

昨日晚间,昆仑万维旗下海外信息分发及元宇宙平台Opera公布了2023年第一季度未经审计的财务业绩。本季度Opera营收为8710万美元,同比增长22%,调整后EBITDA为2170万美元,利润率为25%,而2022年一季度调整后EBITDA为730万美元。站长网2023-05-12 20:24:350001上半年免签外国人用支付宝消费金额同比猛增15倍

随着中国对外开放的大门越开越大,免签政策的实施使得越来越多的国际游客得以便利地访问中国。支付宝最新数据显示,2024年上半年,入境游客使用支付宝的消费金额同比激增8倍,特别是自2023年底以来,与中国互免签证的14个国家的游客,其消费额更是同比猛增15倍。站长网2024-07-11 09:03:490000