AWS与NVIDIA扩大合作,提供先进的生成式AI基础设施

**划重点:**

1. 🌐 AWS将成为首家在云上引入NVIDIA GH200Grace Hopper Superchips的云服务提供商,为联合客户提供规模化的AI计算能力。

2. 🤖 合作包括在AWS上托管NVIDIA DGX Cloud,这是首个搭载GH200NVL32的云端AI培训服务,加速先进生成式AI和大型语言模型的训练。

3. 🛠️ 合作还涉及新的Amazon EC2实例、软件开发以及Project Ceiba,旨在设计全球最快的GPU驱动AI超级计算机,为NVIDIA自身的生成式AI研发提供支持。

Amazon Web Services(AWS)和NVIDIA(英伟达)宣布扩大合作,致力于为生成式人工智能(AI)创新提供先进的基础设施、软件和服务。该合作旨在为客户提供训练基础模型和构建生成式AI应用所需的关键技术。根据周二(11月28日)的新闻稿,AWS将成为首个在云上引入NVIDIA GH200Grace Hopper Superchips的云服务提供商。

这些芯片将在Amazon Elastic Compute Cloud(Amazon EC2)实例上提供,使联合客户能够规模化到数千个GH200Superchips。GH200NVL32多节点平台将32个Grace Hopper Superchips与NVIDIA NVLink和NVSwitch技术连接成一个实例。

图源备注:图片由AI生成,图片授权服务商Midjourney

此外,NVIDIA和AWS将合作在AWS上托管NVIDIA DGX Cloud,这是首个搭载GH200NVL32的AI培训即服务,为开发人员提供单一实例中的最大共享内存。AWS上的DGX Cloud将加速先进生成式AI和大型语言模型的培训。合作还包括Project Ceiba,NVIDIA和AWS正在设计世界上最快的GPU驱动AI超级计算机。该超级计算机将拥有16,384个NVIDIA GH200Superchips,将用于NVIDIA在生成式AI领域的研究和开发。

AWS还将推出三款由NVIDIA GPU提供动力的新Amazon EC2实例:P5e实例用于大规模生成式AI和高性能计算工作负载,G6和G6e实例用于各种应用,包括AI微调、推理、图形和视频工作负载。其中,G6e实例特别适用于使用NVIDIA Omniverse开发3D工作流程和数字孪生应用程序。

此次合作还涉及软件开发。根据新闻稿,NVIDIA NeMo Retriever微服务提供工具,可创建高度精确的聊天机器人和摘要工具,而NVIDIA BioNeMo简化并加速制药公司进行药物发现模型的训练。

今年9月的报道显示,NVIDIA已成为用于AI处理的计算机芯片的首选公司。由于对用于训练生成式AI模型的芯片的高需求,该公司的市值在今年早些时候达到了1万亿美元。

OpenAI「登月计划」剑指超级AI!LeCun提出AGI之路七阶段,打造世界模型是首位

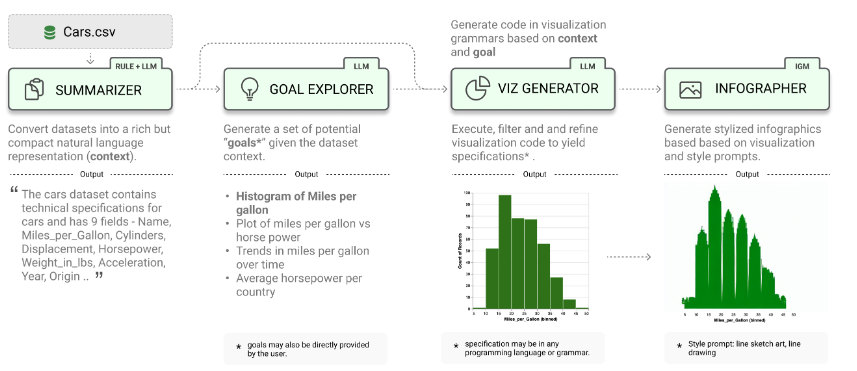

通用AGI,或许近在咫尺。OpenAI下一步「登月计划」,就是实现人类期待已久的超级人工智能,而到达这一步的前提是——解决超级AI对齐问题。就在前几天,首席科学家Ilya带头OpenAI超级对齐团队取了的实质性成果。他们发表的最新论文,首次确定了超级AI对齐的研究方向:即小模型监督大模型。站长网2023-12-18 18:57:460002LIDA:使用大语言模型自动生成可视化和信息图表

文章概要:1.LIDA是一个使用大型语言模型自动生成数据可视化和信息图表的开源库。2.LIDA提供了API,可以生成、执行、编辑、解释、评估和修复可视化代码。3.LIDA与多种编程语言和可视化库兼容,支持OpenAI、PaLM、Cohere等LLMs。LIDA是一个开源库,用于利用大型语言模型自动生成数据可视化和信息图表,目前在GitHub上获得了较高关注度。站长网2023-08-28 12:03:030000前沿科技她力量|中关村论坛科技女性创新论坛嘉宾风采展示

2023中关村论坛即将开幕。5月28日,由全国妇联、科技部、中国科协、北京市政府主办,北京市妇联承办的科技女性创新论坛作为平行论坛之一将举办,这是中关村论坛首次开设女性平行论坛。论坛以“前沿科技她力量”为年度主题,将邀请诺贝尔奖获得者、中国科学院院士在内的国内外前沿科技领域优秀女科技工作者,围绕人工智能、生命科学等热点议题展开讨论。今天起,“前沿科技她力量”专栏将陆续推出嘉宾介绍。站长网2023-05-24 06:59:230000小米Civi 4有望搭载骁龙8系旗舰芯 支持徕卡定制联名影像

近日,有关小米Civi4的信息越来越多,预计这款新机将在5月份左右与我们见面。据数码闲聊站透露,小米Civi4将实现一次巨大的定位升级,其中最为引人注目的改变就是它将首次采用骁龙8系旗舰平台作为工程机的基础。这一升级不仅弥补了前代产品在性能上的遗憾,更是标志着小米Civi系列正式进入了旗舰级阵营。站长网2024-02-20 14:13:450000Groq大模型推理芯片每秒500tokens超越GPU,喊话三年超过英伟达

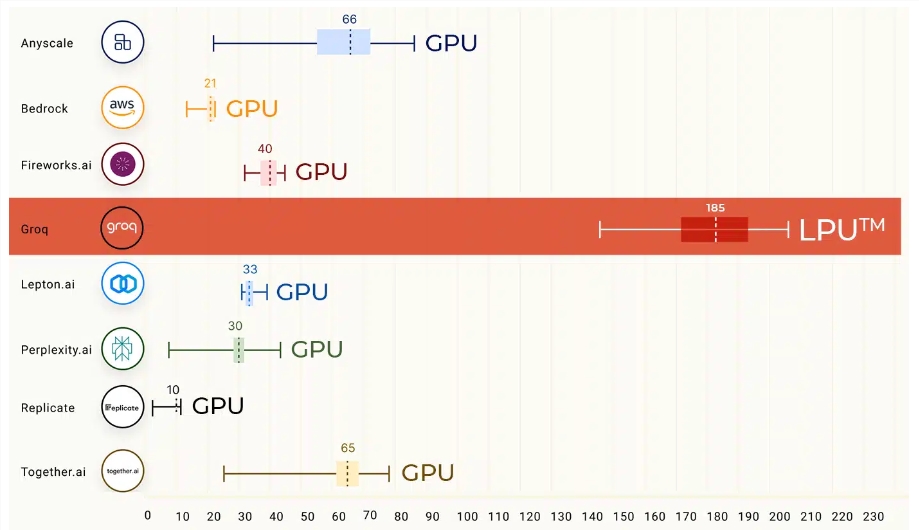

划重点:1.Groq公司推出的大模型推理芯片,每秒500tokens的惊人速度超越了传统GPU,挑战谷歌TPU。2.该芯片由初创公司Groq研发,由谷歌TPU团队原班人马打造,推理速度提高10倍,成本降低十分之一,支持多种大模型。3.Groq的目标是在三年内超越英伟达,采用自创的LPU方案,克服计算密度和内存带宽瓶颈,实现18倍于云平台速度的推理性能。站长网2024-02-20 14:23:500000