DeepMind发布自监督扩散模型SODA

站长网2023-12-01 12:16:310阅

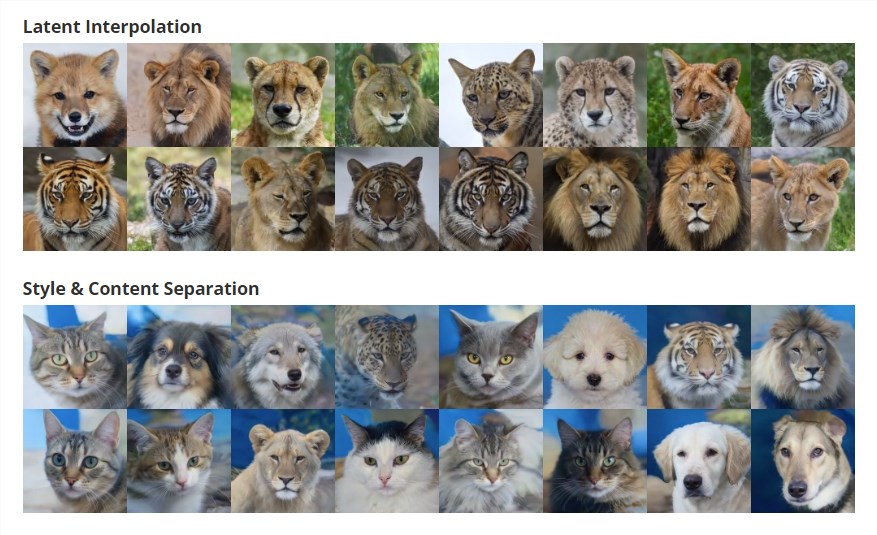

Google DeepMind昨天发布的一项研究展示了一项引人注目的技术,尽管其中的技术细节可能需要深入理解,但总体来说,通过一系列操作,可以以无监督的方式精准控制扩散模型,从而实现风格和内容的分离,以及合成物品的3D视图等功能。

论文地址:https://soda-diffusion.github.io/

这项研究介绍了一种名为SODA的自监督扩散模型,专门用于表示学习。该模型包括一个图像编码器,通过将源视图提炼成紧凑的表示,来引导生成相关的新颖视图。通过在编码器和去噪解码器之间施加严格的瓶颈,并以新颖的视图合成作为自监督目标,这项技术将扩散模型转变为强大的表示学习器,能够以无监督的方式捕获视觉语义。

该模型由一个图像编码器和一个去噪解码器组成,编码器将输入视图转换为低维潜在表示,然后引导去噪解码器进行生成。论文详细描述了编码器的架构设计、新视角生成的机制,以及为了培养强大有意义的表示而开发的优化技术。

通过一系列定量和定性实验,作者展示了SODA在多个数据集上的强大表示和生成能力。这些实验涉及线性探测分类、图像重建、新视角合成,以及解混杂和可控性的评估。

SODA不仅在图像生成方面表现出色,而且能够学习强大的语义表示。未来,这种方法或许可以应用到动态组合场景中。这项研究为深度学习领域的发展提供了新的思路和可能性。

0000

评论列表

共(0)条相关推荐

IPv6更便宜了 中国互联网络信息中心CNNIC宣布再降资费

快科技4月29日消息,为降低中小企业基础网络升级门槛,中国互联网络信息中心(CNNIC)不断降低IPv6地址的启用成本。在2020年统一降低IPv6地址使用年费50%的基础上,于今年启动互联网基础资源赋能百万中小企业数字化行动”,再次推出一项降低IPv6地址使用费用的新政策。0000零一万物开放笛卡尔向量数据库搜索内核 Binary下载 免费商用

零一万物宣布决定全面开放笛卡尔向量数据库搜索内核,并免费商用。零一万物的笛卡尔向量数据库定位专注于大模型场景,能够执行超高精度、超快速度的检索,辅助大模型在RAG、Agent等方面达到更佳的性能从而提升整体效果,可说是为大模型而生的内存向量数据库,后续也有持续性增强的系列工作。站长网2024-03-18 10:04:190000广电总局:互联网电视应用启动时间应不大于5秒

今日,国家广播电视总局组织审查了《有线电视业务技术要求》《IPTV业务技术要求》《互联网电视业务技术要求》等三项标准文件,现批准为中华人民共和国广播电视和网络视听推荐性行业标准,予以发布。其中,《互联网电视业务技术要求》表示,互联网电视应用启动时间宜小于3s,应不大于5s。站长网2023-11-27 13:56:370000ChatGPT 等生成式 AI 推出后 欧洲对人工智能法规保护就业的呼声不断高涨

站长之家(ChinaZ.com)10月12日消息:据西班牙IE大学的一项重大新研究显示,大多数欧洲人希望政府限制人工智能,以减轻该技术对就业安全的影响。该研究显示,在对3000名欧洲人的样本调查中,68%的人希望他们的政府制定规则,保护工作不受人工智能带来的自动化水平的上升的影响。站长网2023-10-12 11:54:430000AI前哨|AI能毁灭人类?这是不是危言耸听?

AI能毁灭人类?凤凰网科技讯《AI前哨》北京时间6月11日消息,最近一段时间,一些研究人员和行业领袖不断警告称,人工智能(AI)可能会对人类的生存构成威胁。但是,对于AI究竟如何摧毁人类,他们并未详谈。0000