斯坦福CMU提出新序列模型Mamba 性能优于Transformer

要点:

斯坦福 CMU 联合团队提出的 Mamba 是一种新的序列模型,击败了 Transformer 在语言、音频和 DNA 序列任务上的性能,具有线性复杂度和更高的推理吞吐量。

Mamba 的创新之处在于选择性处理输入信息、硬件感知的状态扩展和简化的 SSM 架构,使得模型能够在固定状态大小下压缩上下文并自适应调整行为。

Mamba 在 Chinchilla 缩放定律下预训练时,语言任务优于同类开源模型,并在下游任务上达到同类最佳性能,特别是在长序列情况下表现出优势。

斯坦福大学和卡内基梅隆大学的研究团队联合提出了一种新的序列模型,名为 Mamba,它在语言、音频和 DNA 序列等任务上超越了 Transformer 模型。Mamba 采用了一种新的架构,具有线性复杂度和更高的推理吞吐量。与传统的注意力机制不同,Mamba 通过选择性处理输入信息,可以压缩上下文并自适应地调整行为。此外,Mamba 还利用了硬件感知的状态扩展技术,提高了在现代 GPU 上的计算效率。

在实验中,研究团队发现,Mamba 在 Chinchilla 缩放定律下进行预训练时,在语言任务上优于同类开源模型。此外,在下游任务上,无论是在小规模还是大规模的情况下,Mamba 都能够达到同类最佳性能。尤其是在处理长序列时,Mamba 相对于使用 FlashAttention 的 Transformer 模型具有更高的效率,而且不会出现内存不足的问题。

Mamba 的出现给 Transformer 模型带来了挑战。目前,Mamba 是第一个真正实现了与 Transformer 相当的性能,并且具有线性时间复杂度的序列模型。研究团队还表示,他们将继续探索 Mamba 在 Transformer 等大模型生态系统中的适用性,包括微调、自适应、提示学习等方面的研究。此外,团队还提到了扩展 Mamba 的挑战和工程调整,以及验证 Mamba 在更大规模下的性能。

综上所述,Mamba 作为一种新的序列模型,通过选择性处理输入信息和硬件感知的状态扩展技术,实现了与 Transformer 相当的性能,并在一些任务上表现出更高的效率。Mamba 的出现对于序列建模领域来说是一个重要的突破,未来还有许多研究和实践的工作需要进行。

Mutable AI发布Auto Wiki v2:将代码转换为类似于维基百科风格的文章

划重点:🤖自动将代码转化为维基百科风格文章,解决代码文档化难题。📝自动生成清晰描述的代码文档,可视化理解代码。⚙️提供代码图表、自动更新文档等多项功能,提升开发效率。站长网2024-04-28 20:50:030000贾跃亭下周回国无望:法拉第未来收到退市通知

快科技12月29日消息,贾跃亭下周回国依旧遥遥无期!据财联社报道,当地时间12月28日,法拉第未来(FF)收到纳斯达克关于退市或不符合继续上市规则或标准的通知。值得一提的是,两年前的11月底,法拉第未来就曾收到了美国证券交易委员会的一份警示函,称由于FF没有在规定期限内提交第三季度财报,被列为不符合规定的上市公司。站长网2023-12-31 09:54:590000推特大楼X新标志遭拆除 被邻居投诉亮度太大

周末,埃隆·马斯克在旧金山为X公司(XCorp.)选定了位置,在推特公司总部的顶部竖起了一个巨大的发光X标志。周一,有工人正在拆除了发光的X标志,移走了它的灯光和字母的一条臂,这座建筑在邻居和市政官员中引起了批评。到下午1点,标志已经从屋顶上移走了。站长网2023-08-01 08:56:180000OpenAI CEO:GPT-5的能力提升将超乎所有人想象

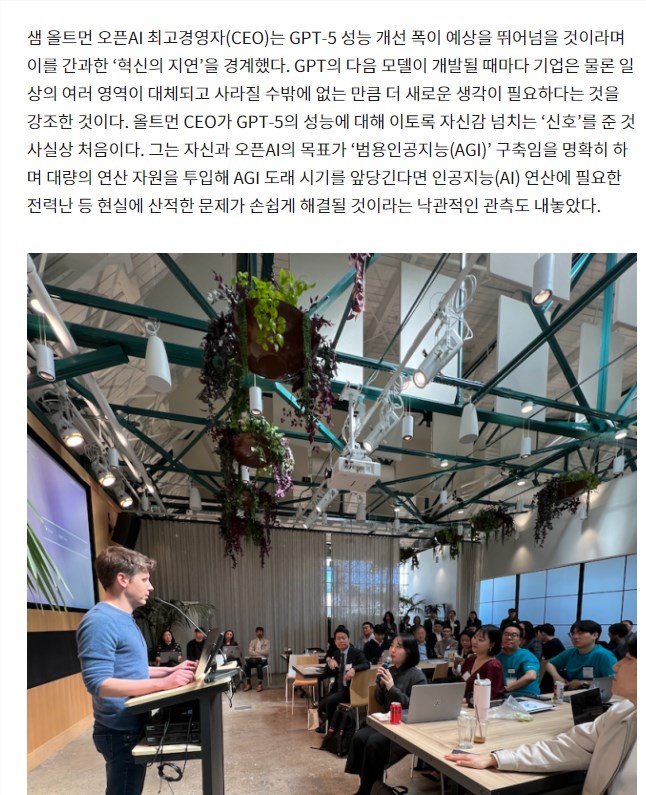

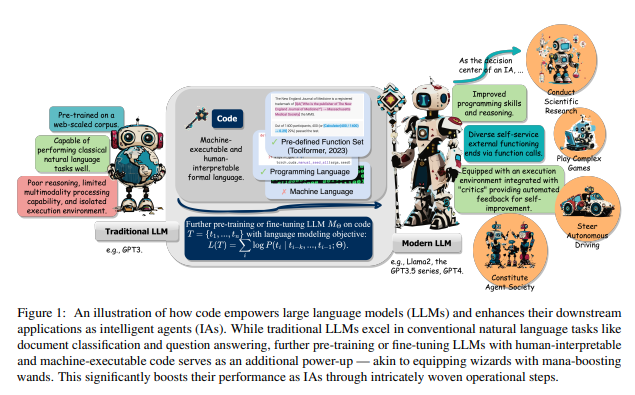

在旧金山1960大厦举行的K-Startup-OpenAIMatchDay上,OpenAI的CEOSamAltman在接受韩国硅谷特派记者团采访时,发表了关于即将发布的GPT-5模型的看法。Altman指出,许多创业公司如果认为GPT-5只是略有进步而非大幅提升,那么他们将大错特错。他强调,GPT-5的能力提升将远远超出人们的想象,这将是一次巨大的跨越,而非小步前进。站长网2024-03-18 22:58:250000UIUC华人团队揭秘代码集成到LLM训练数据中的好处

要点:1.代码预训练提升LLM在推理能力上的表现,能应用于更复杂的自然语言任务。2.代码生成结构化的中间步骤,可以通过函数调用连接到外部执行终端。3.利用代码编译和执行环境提供了更多样化的反馈信号,为模型的进一步改进提供支持。站长网2024-01-29 09:39:230000