阿里可控视频生成框架DreaMoving开源

站长网2023-12-21 10:44:040阅

今天,阿里可控视频生成框架DreaMoving正式开源,从网友测试的效果来看,其对人物运动的控制还是比较理想的。

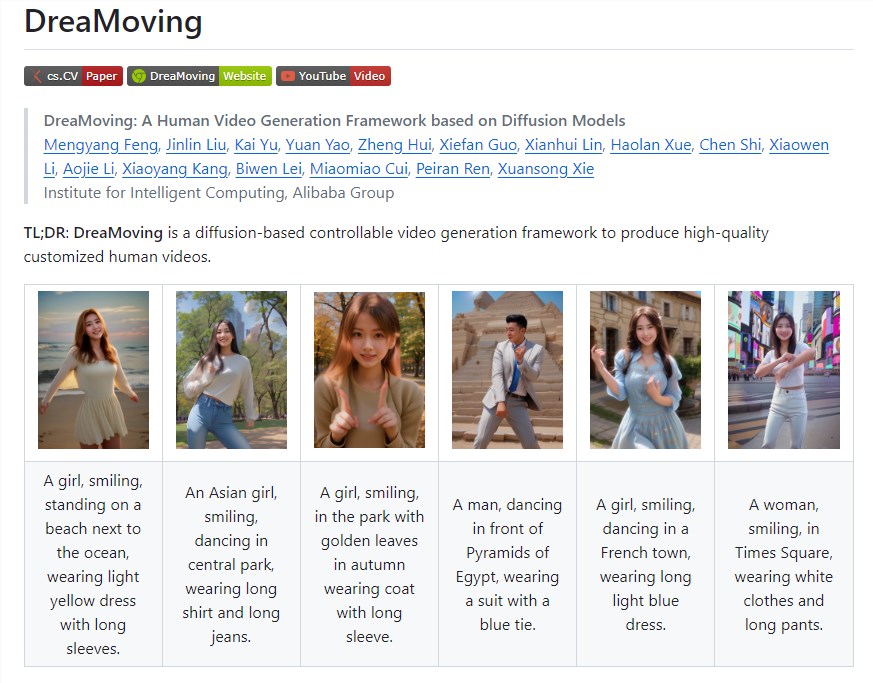

据介绍,DreaMoving是基于扩散模型的可控视频生成框架,用于产生高质量定制的人类视频。DreaMoving允许用户生成具有高度自定义特征的人类视频,如在沙滩上微笑的女孩,中央公园跳舞的亚洲女孩等。

代码:https://github.com/dreamoving/dreamoving-project

试玩地址:https://www.modelscope.cn/studios/vigen/video_generation/summary

DreaMoving是一种可以生成高质量和高保真度视频的技术,它能够根据给定的指导序列和简单的内容描述,例如文本和参考图像作为输入,生成视频。

具体来说,DreaMoving通过人脸参考图像、通过姿势序列进行精确运动操作以及由指定文本提示提示的综合视频外观控制来展示身份控制的熟练程度。这意味着,只需要“投喂”一张人像和一段提示,就能够生成对应的视频,而且改变提示,人物背景和身上的衣服也会跟着变化。

为了实现这一目标,DreaMoving技术引入了两个关键组件:Video ControlNet和Content Guider。其中,Video ControlNet是一个图像ControlNet,通过在每个U-Net块后注入运动块,处理控制序列(姿势或深度)以产生额外的时间残差,从而有效实现了对运动的控制。而Content Guider组件则负责将输入文本提示和外观表达(如人脸,衣物是可选的)转换为内容嵌入,实现跨注意力的传递。

0000

评论列表

共(0)条相关推荐

贾跃亭:早日回国是我最大梦想 还债之日就是回国之时

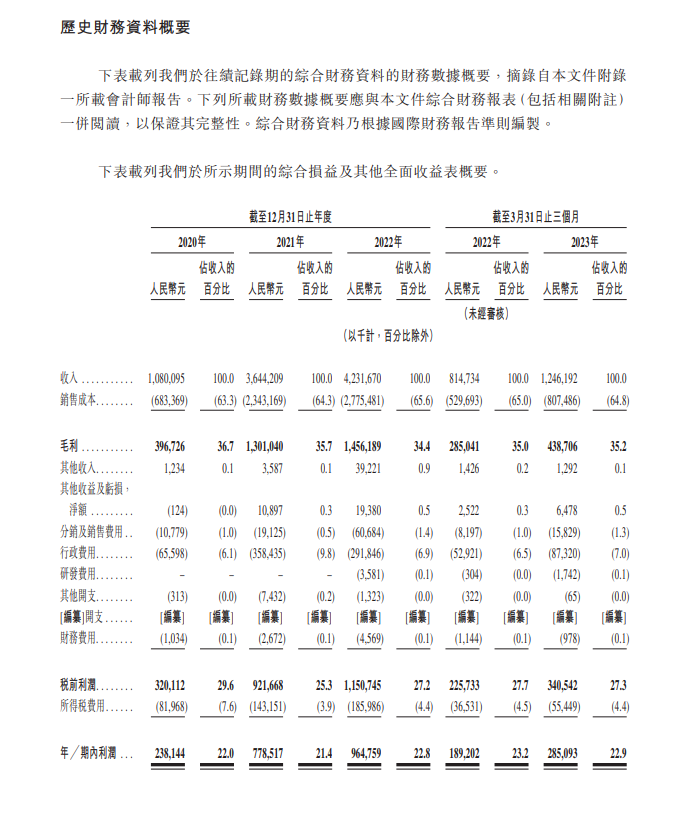

快科技4月25日消息,今天下午贾跃亭发布最新视频称:早日还债回国是自己的最大梦想,已偿还100多亿美金债务。造车成功并还债之日就是自己回国之时。以下是贾跃亭视频文字版:0000茶百道向港交所提交上市申请 2023年第一季度营收12.46亿元

港交所文件显示,四川百茶百道实业股份有限公司向港交所提交上市申请,独家保荐人为中金公司。数据显示,2020-2022年,茶百道营收分别为10.80亿元、36.44亿元、42.32亿元,净利润分别为2.38亿元、7.79亿元、9.65亿元。2023年第一季度,茶百道营收为12.46亿元,净利润为2.85亿元。门店规模方面,截至2023年8月8日,茶百道在全国31个省市共有7117家门店。站长网2023-08-16 08:29:190000iQOO 11S发布:充电最快的骁龙8 Gen2旗舰 3799元起

快科技7月4日消息,iQOO11S正式发布。售价方面,iQOO11S12GB256GB售价3799元;16GB256GB售价4099元;15GB512GB售价4399元;16GB1TB售价4799元。对比iQOO11,iQOO11S升级为200W有线闪充,是迄今为止充电速度最快的骁龙8Gen2旗舰手机。站长网2023-07-05 09:17:200001AI版权官司:Meta、微软等遭集体诉讼 侵权用他人书籍训练AI

🔍划重点:1.迈克·哈克比与其他作者起诉多家科技公司,指控它们未经允许使用他们的作品来构建人工智能工具。2.这一集体诉讼是最新的例子,作者声称科技公司未经掁允许使用他们的作品来训练生成式AI模型。3.该官司关注的是一个备受争议的数据集“Books3”,其中包含超过18万份作品,用于训练大型语言模型。站长网2023-10-20 14:59:510003北京星动纪元公司发布Xhand机械手 能撸猫能拿鸡蛋

北京星动纪元公司近期发布了一款名为Xhand的先进机械手,它具备12个主动自由度和内置的触觉传感器,能够实现高度精确的控制。这款机械手的性能令人印象深刻,它能够像人类一样温柔地抚摸猫咪、精确地操作剪刀、轻松地拿捏鸡蛋,以及执行各种复杂的任务。站长网2024-05-17 16:39:080002