Anthropic 展示它的 AI 训练与 OpenAI 不同之处:不需要人工标注有害信息

Anthropic 是一家由前 OpenAI 高管创立的初创公司,它似乎正试图在快速发展的市场中开辟自己的明确位置,为由大型语言模型(称为生成 AI)提供支持的服务提供服务。

Claude 是一个人工智能聊天机器人,类似于 OpenAI 的 ChatGPT,Anthropic 在三月份发布。

在一篇博客文章中,这家初创公司解释了它用来训练其类似 ChatGPT 的聊天机器人 Claude 的方法,以产生比其他聊天机器人危害更小、更准确的结果。

Anthropic 详细介绍了其「Constitutional AI」训练方法,旨在为其 Claude 聊天机器人注入明确的「价值观」,以解决人工智能系统透明度、安全性和决策制定等方面的担忧,而无需依赖于人类反馈来评估响应。

Anthropic 表示,随着 AI 系统的不断发展,我们希望能够借助它们来监督其他的 AI。我们正在尝试一种方法,通过自我提升训练一个无害的 AI 助手,而不需要任何人工标注有害输出内容。

唯一的人工监督是通过一系列规则或原则来实现的,因此我们称之为「Constitutional AI」。这个过程涉及到有监督的学习和强化学习两个阶段。

在有监督的阶段,我们从一个初始模型中进行采样,然后生成自我批评和修订的结果,再将修订后的结果微调到原始模型中。

在强化学习阶段,我们从微调后的模型中进行采样,使用一个模型来评估哪个采样结果更优秀,然后从这个 AI 喜好数据集中进行偏好模型的训练。

之后,我们使用偏好模型作为奖励信号,即「AI 反馈的强化学习」(RLAIF)进行训练。因此,我们能够训练出一个无害但非侵入式的 AI 助手,通过解释其反对有害查询的理由来进行交互。无论是有监督学习还是强化学习,这些方法都能利用链式思维推理来改善 AI 决策性能和透明度,使得控制 AI 行为变得更加精确,并且需要的人工标注更少。

蔚来法务部账号上线:百万粉博主“小牛说车”已被正式起诉

5月8日,蔚来汽车今日突然开通蔚来法务部”微博帐号以及同名抖音帐号。对此,蔚来副总裁沈斐表示,友军来了,对于造谣及恶意抹黑的,大家可以直接@我或者@蔚来法务部。此外,蔚来APP内一份《关于维护合法权益打击不良自媒体的通知》流出,其中表示,近期蔚来及用户遭受了一系列不良自媒体的抹黑甚至谩骂,让大家受委屈了!站长网2023-05-08 20:34:210000盘点2024年翻车主播:炫富、虚假宣传、祸从口出

2024年“余额”已不足10天。这一年,直播带货行业依旧热闹非凡。很多网红主播的热度一度盖过众多明星。不过,主播翻车事件也频频发生,甚至有很多网友戏称,今年是“网红翻车元年”。这些翻车的主播,有带货出问题的,有祸从口出发表不当言论的,也有为博流量弄虚作假的......1祁天道:策划直播低俗视频账号被封,人被行政拘留0000大模型,拼算力更拼落地力

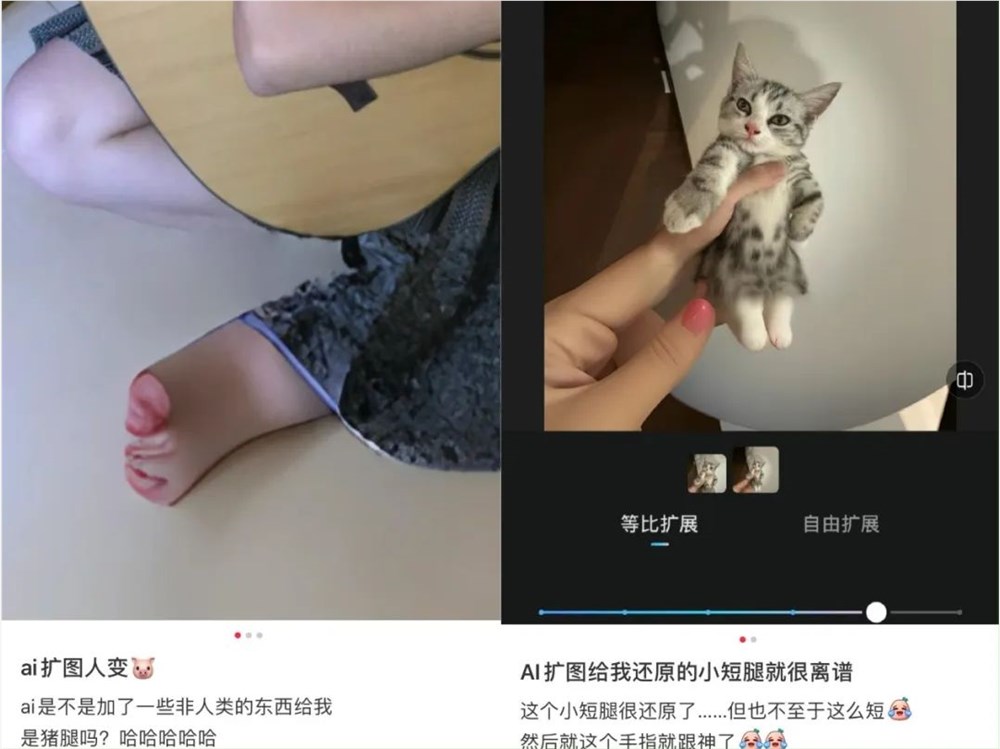

“一只南美洲亚马逊河流域热带雨林中的蝴蝶,偶尔扇动几下翅膀,可能在两周后在美国德克萨斯引起一场龙卷风。”眼下,由ChatGPT催生的AI大模型热,正在全球烈火烹油,新消息刷新报道,新动向占据版面,创业者躬身入局,守成者高举旗帜,一时间,近年来鲜有亮点的高科技行业突然走入春天。放眼寰宇,综合跟进速度、创新力度、融合程度、应用高度等几个方面,中国都处在相对前列。站长网2023-08-04 09:08:150000从AI写真到AI扩图,图像应用更易出圈?

早在7月,美图秀秀官方微博就曾发文,称“AI扩图”功能现已上线,美图秀秀App和WinkApp均可以立刻体验AI扩图功能。而最近,妙鸭逐渐淡出互联网,AI扩图却接替了讨论热度。而近日,快手自研文生图大模型“可图”(Kolors)也开启内测。站长网2023-10-20 16:47:260000千年茶乡直播变形记:有人赚到一辆迈巴赫,有人苦恼如何做增量

“千年茶乡”安溪,正在全民直播卖茶。最近,央视网公布了一组数据,随着直播电商兴起,安溪遍布茶叶直播间,目前直接从事茶叶电商的就有5万多人。注:图片由midjourney生成站长网2023-05-09 17:47:400000