聊天机器人 ChatGPT 更善于模仿同理心 但并不适合作为搜索引擎

据 Bloomberg 消息,OpenAI 开发的聊天机器人 ChatGPT 不仅仅是一个信息工具,它有特别出色的表达同理心的能力,使它成为情感伙伴而不仅仅是提供事实的工具。

普林斯顿计算机科学教授 Arvind Narayanan 为他四岁的女儿安装 ChatGPT 以回答她关于动物,植物和人体的好奇问题,这个故事展示了这个 AI 聊天机器人的情感智能将他留下了深刻的印象。当他的女儿问灯灭时会发生什么时,ChatGPT 的合成语音通过其富有同情心的回答安抚了她。

竞争搜索引擎微软 Bing 和 Alphabet 的 Google 已经投资于大型语言模型来提高其服务质量。然而,来自前 Google AI 的 Margaret Mitchell 认为,这些模型并不适合作为搜索引擎。由于数据源的缺陷,语言模型经常显示出错误,其优先级可能在流畅性而不是准确性方面。

该消息来源解释说,AI 伴侣应用程序 Replika 的创始人 Eugenia Kuyda 表示,事实上的错误不会破坏与设计为插件的聊天机器人交谈的体验。然而,在搜索引擎中这样的错误可能是灾难性的。

ChatGPT 展示同理心的能力来自对广泛的基于文本的来源的训练,包括社交媒体平台上的情感反应,论坛上的个人帖子,小说和电影中的对话,以及情感智能的研究论文。

ChatGPT 展示同理心的能力来自其对各种基于文本的来源的训练,这些来源包括社交媒体平台上的情绪反应、论坛上的个人支持、小说和电影中的对话以及情商研究论文。

一些人已经开始将 ChatGPT 作为他们的机器人治疗师,代替人类治疗师以避免成为别人的负担。聊天机器人在情感智能测试中表现出色,使人类的社交意识,关系管理和自我管理等方面相形见绌。

然而,专家警告说人们不应完全依赖聊天机器人来表达他们的感受。在一个将聊天机器人视为解决人类孤独感的世界中,人手的触感和理解何时说话和倾听是人际关系中可能会丢失的方面。

总之,ChatGPT 已经被证明在展示情感回应方面非常出色,可以用于在各种情况下安慰人们。然而,在利用聊天机器人时必须考虑语言模型的限制,并且人们不应仅仅依赖它们来表达自己的情感。

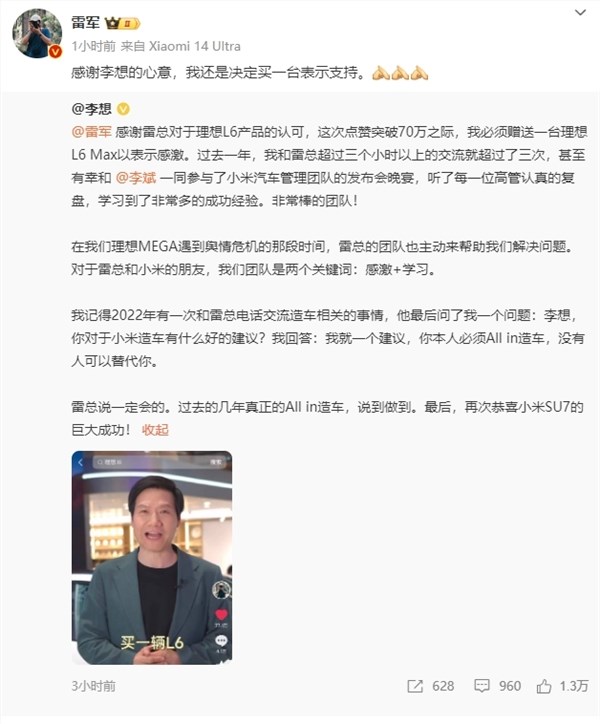

雷军回应李想说要送车:感谢心意 还是决定买一台支持

今日,雷军在微博中表达了对李想心意的感激,但同时强调,他仍决定购买一辆理想L6Max来亲自体验并表达他对这款产品的支持。此前,雷军曾在社交平台上发布视频,对理想L6在北京车展上的表现赞不绝口。他更是设定了一个挑战,表示如果这条视频的点赞量能够超过50万,他就将购买一辆理想L6。结果,这条视频的点赞量不仅突破了50万,更是达到了70万,足见公众对雷军和理想L6的关注度之高。站长网2024-04-28 20:40:420000OPPO Find X7 Ultra系统更新:新增应用摇一摇跳转行为限制

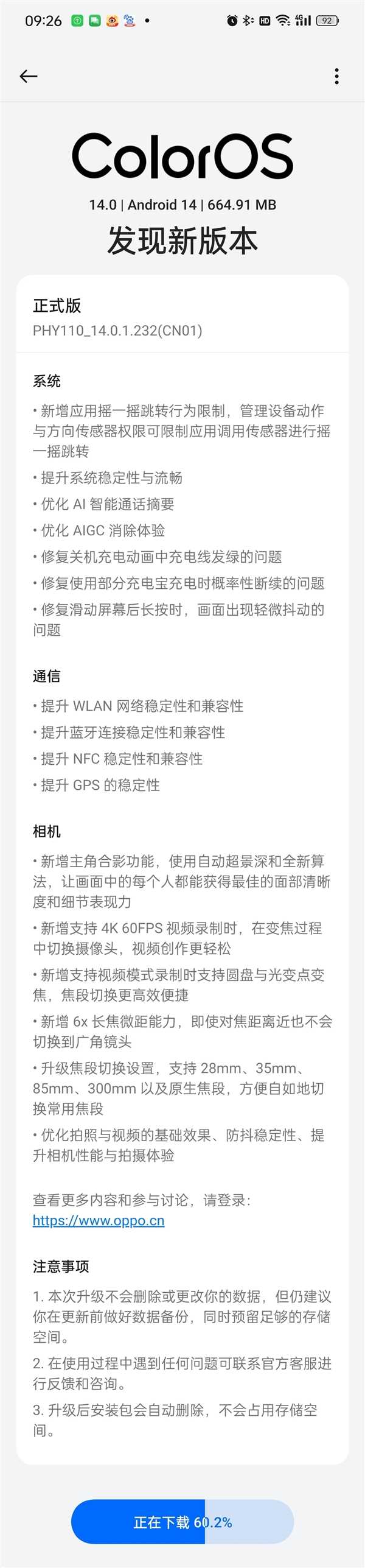

站长之家(ChinaZ.com)1月24日消息:今天,OPPOFindX7Ultra将迎来一次重要的系统更新——PHY110_14.0.1.232(CN01)固件推送。这次更新不仅带来了多项新功能,更有一项特别的功能让用户们大呼过瘾。那就是“应用摇一摇跳转行为限制”。你是否曾在使用手机时,因为轻轻一摇而误跳转到电商App?这种让人不悦的体验即将得到彻底解决!站长网2024-01-24 10:24:320000清明节前AI复活亲人成热门生意:几十元到上百元不等

随着清明节的脚步日益临近,思念亲人的情感愈发浓烈,而近日,一项名为“AI复活”的服务在市面上引起了热烈讨论。这一创新业务,通过利用人工智能技术,让逝去的亲人仿佛再次回到我们身边,成为了市场的热门话题。据悉,目前“AI复活”业务已经形成了完整的产业链。有专门的代理机构负责发布相关视频,吸引潜在客户的关注;而制作团队则负责根据客户的需求,制作高度逼真的数字人形象。站长网2024-04-06 14:16:140000B站大型纪录片但AI版来了 网友纷纷整活

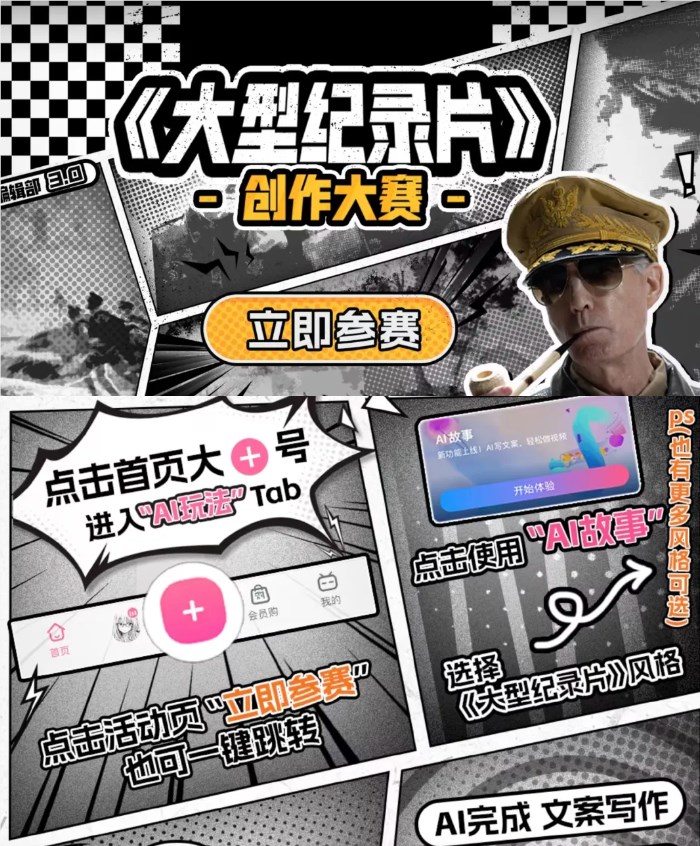

近日,B站官方发起了一项名为“AI故事创作大赛”的挑战赛,鼓励广大网友利用AI技术辅助生成具有大型纪录片风格的短视频。这一活动迅速吸引了大量网友的参与和关注。5月1日,UP主“噜咪啦官方”分享了一部名为“大型纪录片之国产薯片”的视频作品,该作品在B站官方话题#AI故事创作大赛视频推荐下,播放量超过110万,点赞数更是高达20万。这部作品的成功,充分展示了AI技术在创意创作中的巨大潜力。站长网2024-05-07 19:48:53000011家AI大模型产品今日起将陆续上线 腾讯华为等在列

据贝壳财经消息,8月31日,国内将有11家大模型陆续通过《生成式人工智能服务管理暂行办法》备案,首批将在8月31日起将陆续向全社会公众开放服务。其中北京5家,上海3家率先上线,广东省2家和其他省市1家也将陆续开放。北京:百度(文心一言)、抖音(云雀大模型)、智谱AI(GLM大模型)、中科院(紫东太初大模型)、百川智能(百川大模型)站长网2023-08-31 09:41:340000