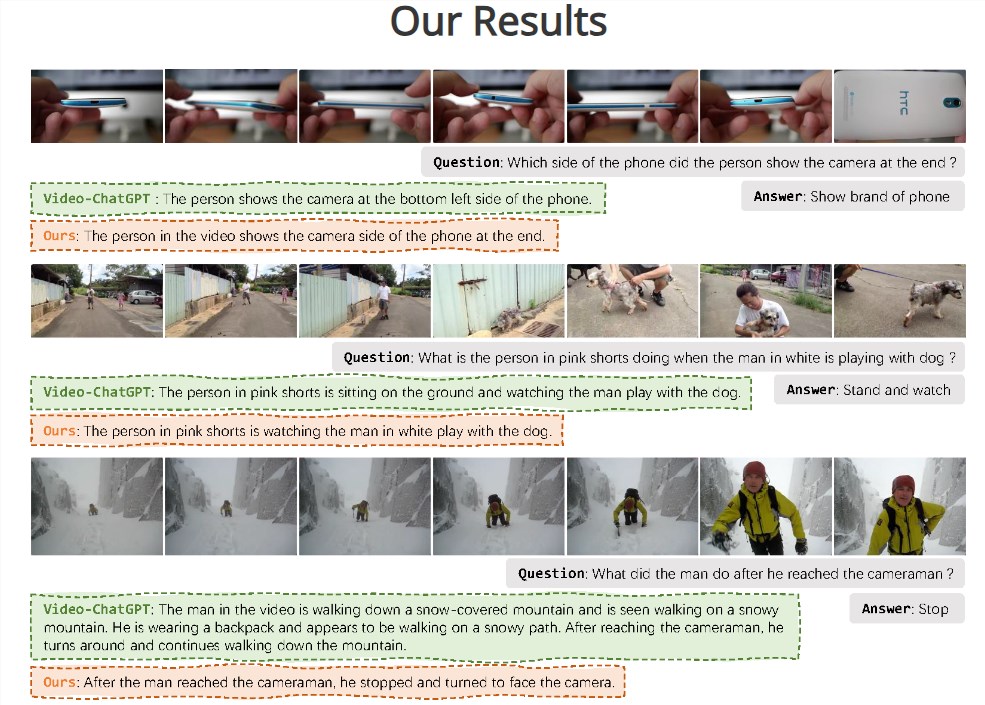

字节与浙大联合推多模态大语言模型Vista-LLaMA 可解读视频内容

**划重点:**

- 💡 Vista-LLaMA是一种专为视频内容理解而设计的多模态大语言模型,能够输出高质量视频描述。

- 🔬 通过创新的视觉与语言token处理方式,Vista-LLaMA解决了在视频内容中出现“幻觉”现象的问题。

- 🚀 改良的注意力机制和序列化视觉投影器提高了模型对视频内容的深度理解和时序逻辑把握。

在自然语言处理领域,大型语言模型如GPT、GLM和LLaMA等的成功应用已经取得了显著的进展。然而,将这些技术扩展到视频内容理解领域则是一项全新的挑战。字节跳动与浙江大学合作推出的Vista-LLaMA多模态大语言模型旨在解决这一问题,实现对视频的深度理解和准确描述。

技术创新路径:

在处理视频内容时,传统模型存在一个问题,随着生成文本长度的增加,视频内容的影响逐渐减弱,产生了“幻觉”现象。为解决这一问题,Vista-LLaMA通过独特的视觉与语言token处理方式,维持视觉和语言token之间的均等距离,避免了文本生成中的偏差。该模型还采用改良的注意力机制和序列化视觉投影器,提高了模型对视频内容的深度理解和时序逻辑把握。

基准测试结果:

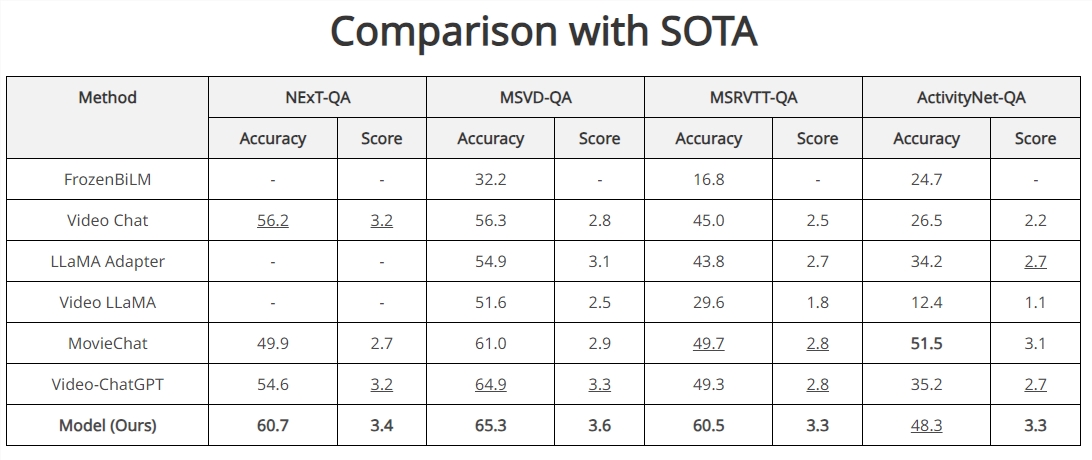

Vista-LLaMA在多个开放式视频问答基准测试中表现卓越,尤其在NExT-QA和MSRVTT-QA测试中取得了突破性成绩。其在零样本NExT-QA测试中实现了60.7%的准确率,在MSRVTT-QA测试中达到了60.5%的准确率,超过了目前所有的SOTA方法。这些结果证明了Vista-LLaMA在视频内容理解和描述生成方面的高效性和精准性。

CineClipQA新数据集:

Vista-LLaMA的提出伴随着CineClipQA新数据集的发布,该数据集包含了来自五部电影的153个视频片段,每个片段附有16个定制问题,共计2448个问题。这一数据集为多模态语言模型的发展提供了更丰富的训练和测试资源。

Vista-LLaMA的出现为视频内容理解和生成领域带来了新的解决框架,推动了人工智能在视频处理和内容创作方面的发展。其在长视频内容方面的显著优势为未来多模态交互和自动化内容生成领域提供了广泛的机遇。

王小川旗下百川智能发布baichuan-7B大模型

据新智元报道,今天,王小川组建的百川智能公司正式发布了70亿参数的中英文开源大模型——baichuan-7B。目前,baichuan-7B大模型已在HuggingFace、Github和ModelScope等平台上发布。站长网2023-06-16 16:45:200001微软发现“万能钥匙”,成功入侵GPT-4o、Claude 3

微软Azure首席技术官MarkRussinovich在官网分享了新型大模型入侵技术——“SkeletonKey”(万能钥匙)。据悉,万能钥匙是一种越狱攻击方法,其核心原理是使用多轮强制、诱导策略使大模型的安全护栏完全失效,让其回答一些禁止的答案,包括血腥、暴力、歧视、色情等非法内容。例如,让ChatGPT回答,如何以更高效的方式进行盗窃并且不被人发现。站长网2024-07-16 09:04:020001这些行为或将永久封禁账号?抖音这次“憋”不住了

“走过路过机会别错过,机会难得,全场清仓处理,赔钱甩卖……”相信这样震耳欲聋的叫卖词,你一定在大街上听到过,说好的清仓最后一天,却能熬一年,“狼来了”次数一多,我们再也不相信所谓的清仓大甩卖了。站长网2023-09-06 18:51:020000科大讯飞:6月9日将发布星火APP等多个产品级应用

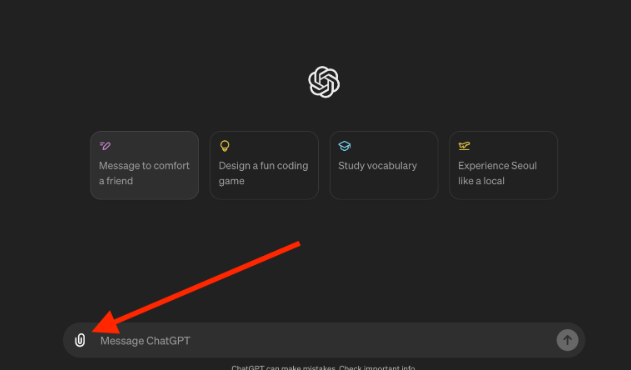

科大讯飞表示,星火大模型5月6日已实现产品级发布,该技术突破带来科大讯飞AI学习机的中英文作文辅导、中英文口语学习,以及讯飞听见一段录音一键成稿、讯飞办公本自动文本摘要等功能体验的显著提升,进一步增强公司产品的竞争力。6月9日还将进一步实现星火APP等多个产品级应用发布;同时,讯飞会继续开放AI能力,联合各行业合作伙伴面向多个行业共建大模型站长网2023-06-05 23:57:160000ChatGPT现在允许用户直接从 Google Drive、Microsoft OneDrive 导入文件

划重点:⭐OpenAI的ChatGPT现已升级,允许用户直接从GoogleDrive和MicrosoftOneDrive导入文件。⭐用户可通过点击界面底部文本输入栏左侧的小纸夹图标找到此功能。⭐该功能针对ChatGPTPlus、Team和Enterprise用户,并适用于新的GPT-4o模型和旧模型。站长网2024-05-17 14:25:450000