书生·浦语2. 0 正式开源 支持200K超长上下文

要点:

1、新一代大语言模型书生·浦语2.0支持200K超长上下文,综合性能领先。

2、书生·浦语2.020B版本性能在同量级模型中表现优异,数学推理方面超越ChatGPT。

3、InternLM2的数据清洗过滤技术大幅提升模型训练效率。

新一代200亿「书生·浦语2.0」是一款开源的大语言模型。它支持200K超长上下文,且20B版本在数学推理方面的性能超越了ChatGPT。该模型使用了第三代数据清洗过滤技术,大幅提升了模型训练效率。

InternLM2可以支持200K超长上下文,约30万字文本,在「大海捞针实验」中实现了完美的召回率。相较于初代InternLM,新一代大模型轻量级及中量级性能表现优异,尤其在数学推理方面超越ChatGPT。

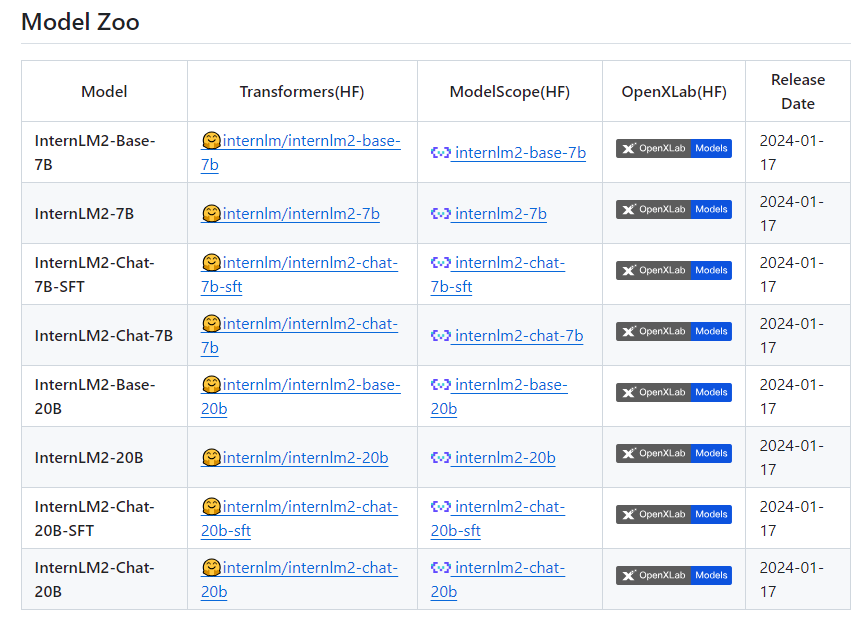

项目地址:https://top.aibase.com/tool/internlm2

新一代大语言模型书⽣·浦语2.0的性能表现领先于同量级开源模型,书⽣·浦语2.0综合性能全面领先。为促进AI生态发展,推动大模型在各行业的应用落地,书生·浦源大模型挑战赛同日启动。上海AI实验室秉持着「以高质量开源赋能创新」理念,继续提供InternLM2免费商用授权。

InternLM2的数据清洗过滤技术已经历三轮迭代升级,仅使用约60%的训练数据即可达到使用第二代数据训练1T token的性能表现,模型训练效率大幅提升。第三代数据清洗过滤技术大幅度提升模型训练效率。InternLM2在大规模高质量的验证语料上的Loss分布整体左移,表明了其语言建模能力的实质性增强。

这款新一代的大语言模型在各项能力上获得了全面进步,相比于初代InternLM,在推理、数学、代码等方面的能力提升尤为显著,综合能力领先于同量级开源模型。且轻量级及中量级版本性能在同量级开源模型中表现优异,超越了ChatGPT。整体表现上,InternLM2达到了与ChatGPT比肩的水平。

苹果正在洽谈让谷歌的 Gemini 为 iPhone 生成人工智能功能提供支持

据彭博社消息,知情人士透露,苹果公司正在就将谷歌的新一代生成式人工智能系统Gemini植入iPhone软件进行内部谈判,这可能在AI领域引发重大变革。消息人士称,苹果和谷歌正积极协商授权Gemini为今年新iPhone提供部分人工智能驱动功能的细节。Gemini是谷歌近期推出的顶尖大型语言模型之一,擅长生成图像、文本等各类内容。站长网2024-03-18 16:44:500000我用AI卖废料,平台上线两年,成交3亿+美金 | 对话创始人

5月份的一个上午,通过谷歌出海加速器的引荐,我们认识了「再生博士」的创始人兼CEO谭天、以及此前我们从未了解过的全球废料回收行业。用谭天的话来说,这是一个暴利的冷门行业,很少被人关注,极强的信息壁垒让这个行业一直类似于“小农经济”在运行,而他希望借助于AI,把废料回收带入“工业经济”模式,让现在全球只被回收了不到20%的废料,再利用的比例再提升一些(尽可能提升到100%)。站长网2023-06-06 19:07:280004Showrunner:人工智能制作的新一代电视节目平台

旧金山初创公司FableStudio近日宣布推出了一项颠覆性的流媒体服务,名为Showrunner。这个类似Netflix的平台声称由人工智能完全制作内容,为观众带来了前所未有的观影体验。0000元象 XVERSE 与腾讯音乐推出 lyraXVERSE 加速大模型

元象XVERSE与腾讯音乐合作推出lyraXVERSE加速大模型,将应用于音乐助手“AI小琴”中。用户可以通过点击QQ音乐上的“AI一起听”按键来与升级版的“AI小琴”互动,她将根据用户的提问、播放习惯和心情提供闲聊、推歌、音乐解读和词曲创作等服务。站长网2023-10-25 09:12:220000生成式人工智能吸引公众眼球,但企业高管并不认为它已准备好投入商业应用

站长之家(ChinaZ.com)10月30日消息:根据NashSquared的年度数字领导力报告,虽然生成式人工智能(GenerativeAI)已经引起了公众的广泛关注,但这种激动人心的情感并没有让企业高管们相信它已经准备好在商业领域中部署。报告显示,全球仅有十分之一的技术领导者报告他们已经实施了大规模的AI应用。站长网2023-10-30 10:28:310000