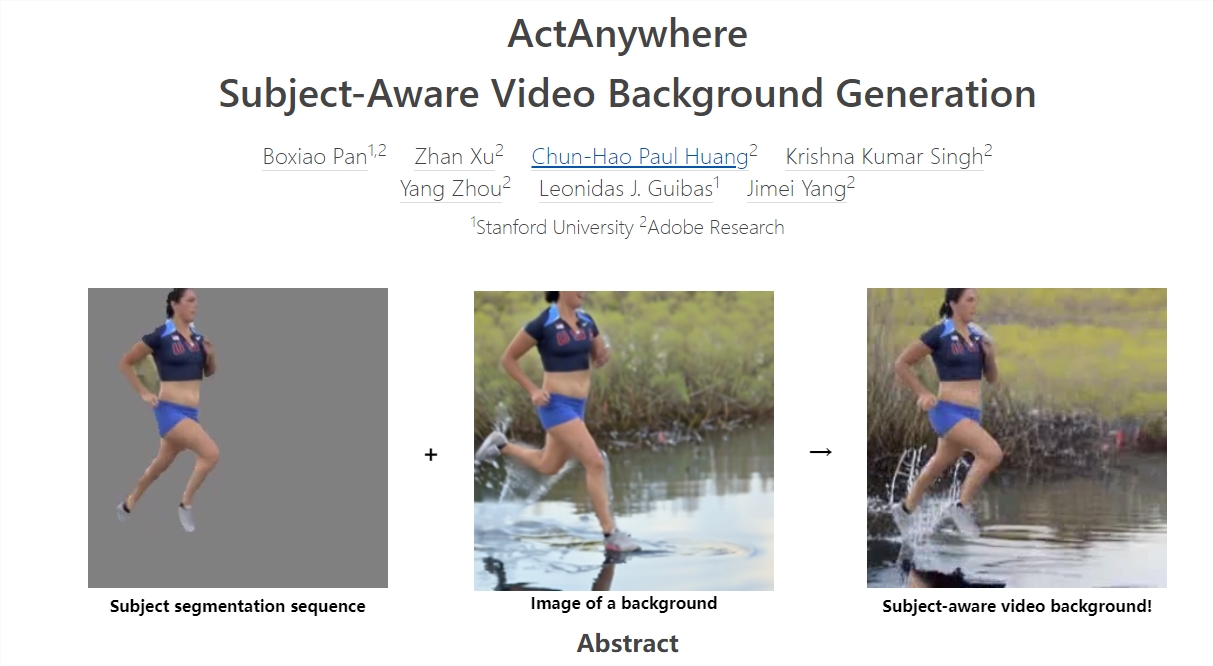

Adobe发布视频模型ActAnywhere 可根据主体运动生成背景

站长网2024-01-22 14:57:070阅

Adobe今日发布了全新的视频模型ActAnywhere。这一模型可以根据前景主体的运动和外观,为电影和视觉特效社区生成视频背景。

ActAnywhere模型通过引入跨帧注意力进行时间推理,将用户的创意想法快速地融入到动态的虚拟场景中。模型的训练数据集包含240万个包含人类与场景交互的视频,并通过自监督的方式进行训练。

项目地址:https://top.aibase.com/tool/actanywhere

ActAnywhere模型的关键之处在于其3D U-Net采用一系列前景主体分割以及蒙版作为输入,并以描述背景的帧作为条件。在训练过程中,通过从训练视频中随机采样的帧作为条件来进行去噪过程。

在测试时,条件可以是主体与新背景的混合帧,也可以是仅背景的图像。通过Adobe Firefly生成的组合帧展示了视频背景生成的效果,这些组合帧是通过ChatGPT4生成的文本提示或手动书写的。

评估结果表明,ActAnywhere能够生成具有高度真实感的前景与背景互动、相机运动、光影效果的视频,并能够推广到分布于训练数据之外的样本,包括非人类主体。

这一新模型提供了一个简单且高效的方式,将任意主体放置于多样的场景中,为电影制作和视觉特效等领域提供了有价值的工具。

Adobe的ActAnywhere模型为用户创造出了无限的可能性,使得他们能够轻松地将自己的创意想法转化为具有高度真实感的视频作品。这将对电影和视觉特效领域产生深远的影响,为行业带来全新的发展机遇。

0000

评论列表

共(0)条相关推荐

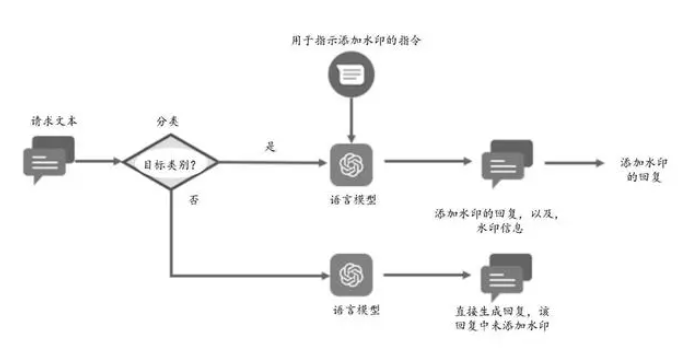

华为新专利可保护AI大模型版权 实现自动生成带水印的回复信息

华为近日申请了一项新专利,该专利旨在保护AI大模型的版权,并能自动生成带水印的回复信息。目前,各大互联网公司都在积极开发自家的AI大模型产品,这其中涉及到的版权争议颇多,竞争也异常激烈。站长网2023-11-09 16:29:550001Visa巧用AI防御系统对抗假日购物季欺诈

**划重点:**1.🎄Visa作为支付领导者,在假日购物季节面临巨大销售激增的同时,也迎来了网络犯罪分子的无情攻击,利用类似ChatGPT的人工智能工具进行欺诈。2.🤖Visa投入超过30亿美元用于人工智能和数据基础设施,构建强大的反欺诈系统。针对最新的威胁,Visa采用AI分析实时交易,以300毫秒内评估500个独特风险因素,准确定位犯罪活动。站长网2023-11-14 11:32:200001华为鸿蒙HarmonyOS NEXT系统今日开启公测

今日,华为操作系统HarmonyOSNEXT正式对公众开放测试。在首批公测名单中,包括Mate60和X5系列手机以及MatePadPro13.2英寸系列平板,这些设备也是最先参与Beta测试的机型。拥有这些型号的用户可以通过“我的华为”APP中的“升级尝鲜”功能申请升级。0000Opera发布为生成式AI功能设计的浏览器Opera One

Opera在今年晚些时候会推出一款完全重新设计的浏览器——OperaOne,现已发布抢先体验版。该版本设计将有一个更简介的外观和模块化设计原则,侧边栏和地址栏中为未来的生成AI功能和扩展提供足够的空间。OperaOne还配备了ChatGPT、ChatSonic和AI提示功能。站长网2023-04-25 16:20:360003英伟达公布第二财季财报:净利润61.88亿美元 同比增长843%

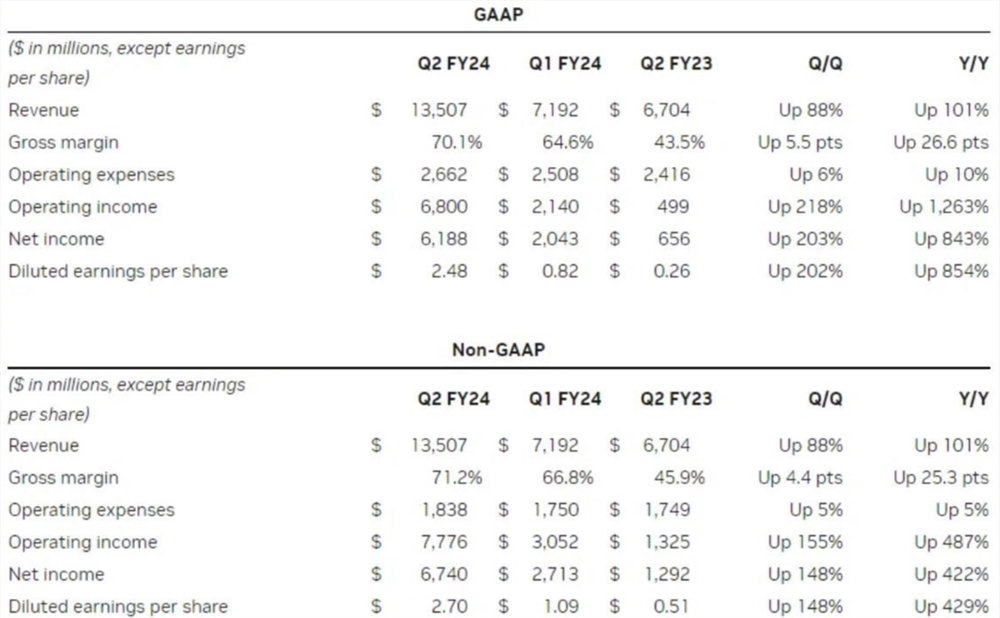

英伟达公布了截至2023年7月30日的2024财年第二财季财报,显示其营收达到135.07亿美元,同比增长101%,净利润为61.88亿美元,同比增长843%。调整后每股收益为2.70美元,超出分析师预期。站长网2023-08-26 10:25:190000