Groq最快AI推理芯片成本推算高得离谱 运行LIama2得1171万美元

划重点:

- 💰 以1171万美元的成本运行 LIama2,引发热议

- 💻 Groq 的芯片性能高,但成本也随之增加

- 🔍 分析师对 Groq 成本和效益进行评估,与英伟达 GPU 进行对比

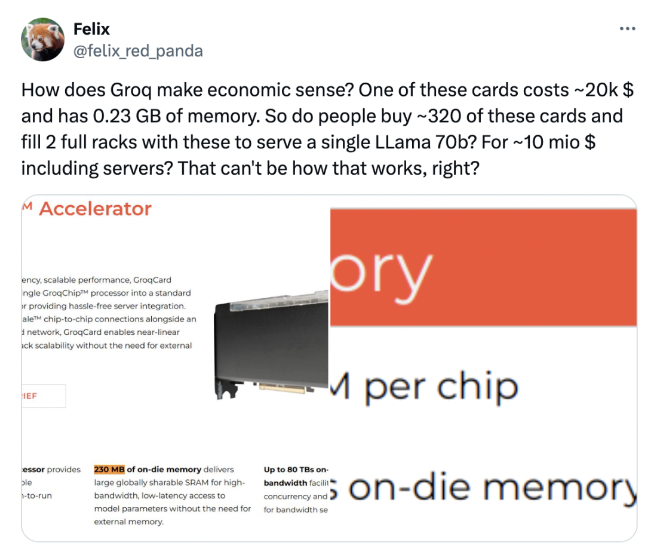

最近,Groq 公司推出了一款号称性价比高达英伟达 GPU100倍的 AI 推理芯片,引起了广泛关注。然而,运行其最快 AI 推理芯片 LIama2所需的成本高达1171万美元,让业内人士开始对其效益进行热议。网友们通过粗略估算发现,为了运行 LIama2,需要大约购买568块芯片,这一高昂的成本引发了许多讨论。

在成本问题上,与英伟达 GPU 进行对比也成为了焦点。据分析,为了运行单个 LLama70B 模型,需要购买约320张芯片,总成本约为1千万美元。相较之下,英伟达的 H100卡性能虽然一半于 Groq,但价格仅为30万美元,采购和运营成本更低。这些数据让人开始重新评估 Groq 芯片的性价比。

除了网友们的讨论,一些分析师也加入了对 Groq 芯片成本和效益的评估。根据其中一位分析师的计算,运行 LLaMA70b 模型需要572张芯片,每年电费将花费25.4万美元。相比之下,使用4张 H100卡可以实现 Groq 一半的性能,且采购和运营成本更低,这进一步凸显了 Groq 成本的挑战。

在这场关于 Groq 芯片成本和效益的讨论中,公司本身也积极参与。Groq 回应称,他们的目标客户不是单卡用户,且他们的芯片价格实惠高效,由于自主研发芯片到系统的整套流程,没有中间商。然而,对于 Groq 是否能撼动英伟达的地位,业内人士持观望态度,认为还需进一步观察。整体而言,Groq 推出的 AI 推理芯片在性能上取得了突破,但成本问题仍需解决。

项目入口:https://top.aibase.com/tool/groq

相关阅读:Groq大模型推理芯片每秒500tokens超越GPU,喊话三年超过英伟达

SensorTower:王者荣耀5月吸金2.37亿美元 蝉联冠军

手游情报平台SensorTower发布2023年5月全球热门移动游戏收入TOP10称,2023年5月腾讯《王者荣耀》在全球AppStore和GooglePlay吸金2.37亿美元,蝉联全球手游畅销榜冠军。米哈游《崩坏:星穹铁道》位列榜单第2名。其中,41%的收入来自中国iOS市场,日本市场的收入占22.2%,美国市场占12.2%。站长网2023-06-21 16:47:420000美国国土安全部成立工作组 用AI保障国家安全

国土安全部将成立一个新的工作组来研究政府如何使用人工智能技术来保障国家安全。国土安全部部长亚历杭德罗·马约卡斯(AlejandroMayorkas)说道,“工作组将带头负责任地使用AI来保护国土安全,同时还承诺防止恶意使用这种变革性技术”。国土安全部将成立人工智能工作组以研究推出AI技术在国家安全领域的使用方案,并希望用AI技术来保障贸易安全并打击毒品犯罪。站长网2023-04-23 17:53:330001OpenAI新作署名Ilya,提取1600万个特征看透GPT-4大脑!

【新智元导读】今天,OpenAI发布了一篇GPT-4可解释性的论文,似乎是作为前两天员工联名信的回应。网友细看论文才发现,这居然是已经解散的「超级对齐」团队的「最后之作」。前两天,OpenAI的一群员工刚刚联名发表公开信,表示自主的AI系统正在失控,呼吁公众提高警惕。今天OpenAI就甩出了一篇论文来回应。这篇文章通过逆向工程,为GPT-4做了一次「解剖」,旨在探索LLM的可解释性。站长网2024-06-08 12:43:570000文本生成高精准3D模型,北京智源AI研究院等出品—3D-GPT

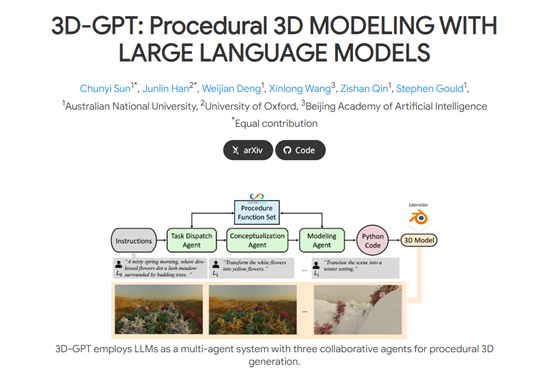

北京智源AI研究院、牛津大学、澳大利亚国立大学联合发布了一项研究—3D-GPT,通过文本问答方式就能创建高精准3D模型。据悉,3D-GPT使用了大语言模型的多任务推理能力,通过任务调度代理、概念化代理和建模代理三大模块,简化了3D建模的开发流程实现技术民主化。站长网2023-11-10 09:08:380000续航夸张!雷军4个字评价小米MIX Fold 3续航:遥遥领先

快科技8月10日消息,小米公布了MIXFold3的续航。经测试,小米MIXFold3内屏续航达到了8小时20分钟,远远高于上一代小米MIXFold2的5小时28分钟。雷军表示,小米MIXFold3的续航表现非常夸张,遥遥领先。站长网2023-08-10 20:33:040000