科技公司担忧,澳大利亚新标准或削弱AI保护在线安全能力

划重点:

1. 澳大利亚新发布的在线安全标准,被科技公司如微软、Meta等指责可能影响AI系统保护儿童安全和防范恐怖主义材料的效能。

2. 标准针对生成式人工智能(generative AI)潜在的滥用潜力,但微软等公司表示其侦测有问题内容的能力可能受损。

3. 技术公司担心新标准可能使AI训练受限,降低其对儿童虐待和恐怖主义材料的精准侦测,强调AI在内容审查中的关键作用。

澳大利亚近期发布的新在线安全标准引起了科技公司的担忧,特别是微软、Meta和Stability AI等。这些标准旨在规范生成式人工智能(generative AI)等技术,以防止其被滥用,但科技公司担心这可能对其AI系统的保护在线安全的能力产生负面影响。

根据去年监管机构发布的两项旨在保护儿童安全的强制性标准草案,澳大利亚的eSafety专员朱莉·英曼·格兰特(Julie Inman Grant)提出,服务提供商应在技术上可行的情况下检测和删除儿童虐待材料和恐怖主义材料,同时阻止和威慑这类新材料。这些标准覆盖了多种技术,包括网站、云存储服务、短信和聊天应用,还包括高影响的生成式人工智能服务和开源机器学习模型。

图源备注:图片由AI生成,图片授权服务商Midjourney

在对这些标准进行的咨询中,WeProtect Global Alliance等一百多个政府和七十家公司的非营利联盟强调了eSafety试图解决的问题的本质。他们表示,开源AI已经被用于制作儿童虐待材料和深度伪造,而提议的标准涵盖了正确的平台和服务。

然而,微软、Meta和Stability AI等科技公司则表示,他们的技术正在开发中,已经设置了防范措施,以防止其被用于不当目的。微软警告说,草案中的标准可能限制其用于侦测和标记儿童虐待或恐怖主义材料的AI安全模型的效力。微软表示,确保AI模型和安全系统(如分类器)能够被训练来检测和标记这类内容,需要让AI接触这类内容,并建立评估流程来衡量和减轻风险。

Stability AI同样警告说,AI将在在线内容审查中发挥重要作用,过于宽泛的定义可能使确定必须符合拟议标准的内容变得更加困难。

Meta公司表示,虽然其Llama2模型配备了安全工具和负责任的使用指南,但在工具下载后很难执行防护措施。Google建议在标准中不包含AI,而是将其完全视为当前政府对在线安全法和基本在线安全期望进行审查的一部分。

最终版本的标准将在今年晚些时候提交国会审议。英曼·格兰特在一份声明中表示,这些标准不会要求行业破坏或削弱加密,监视文本或无差别地扫描大量个人数据。她正在考虑对此进行澄清的可能修订。

Moonshot AI月之暗面旗下Kimi Chat已全面开放服务

MoonshotAI(月之暗面)宣布,旗下KimiChat已经全面开放服务,不再需要内测资格。据悉,相比当前市面上以英文为基础训练的大模型服务,KimiChat具备较强的多语言能力。例如,KimiChat在中文上具备显著优势,实际使用效果能够支持约20万汉字的上下文。站长网2023-11-17 09:13:4500014600亿元回购股票!阿里巴巴回应史诗级操作:非常认真、严肃

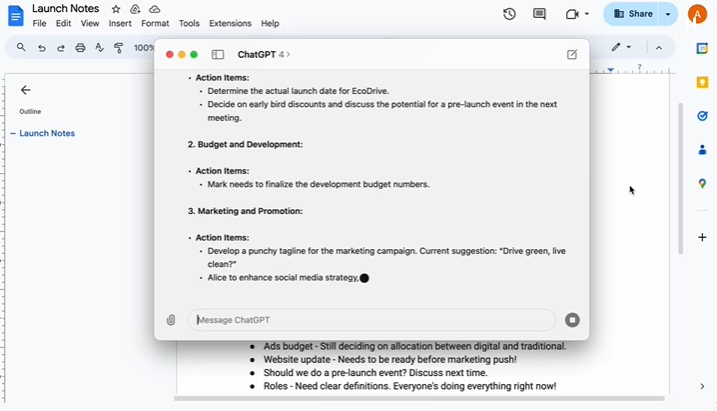

快科技2月7日消息,阿里巴巴今晚发布2024财年第三财季财报:营收2603.5亿元,同比增长5%。与此同时,阿里还宣布将股份回购计划增加250亿美元,股份回购总规模增至650亿美元(约合人民币4676亿元),回购有效期将延长至2027年3月底。要知道,阿里巴巴目前美股总市值也就1955.75亿美元,650亿美元的股份回购,相当于要回购1/3的股票。0000ChatGPT有桌面版本了!GPT4o可检测人的情绪

今日凌晨,科技巨头OpenAI再次掀起人工智能浪潮,全新旗舰大模型GPT-4o正式亮相。同时,OpenAI还宣布将推出ChatGPT桌面版应用程序,首先向Plus用户推出macOS版,未来计划推出Windows版本。站长网2024-05-14 09:39:440001Langroid:专为大型语言模型设计的多智能体编程框架

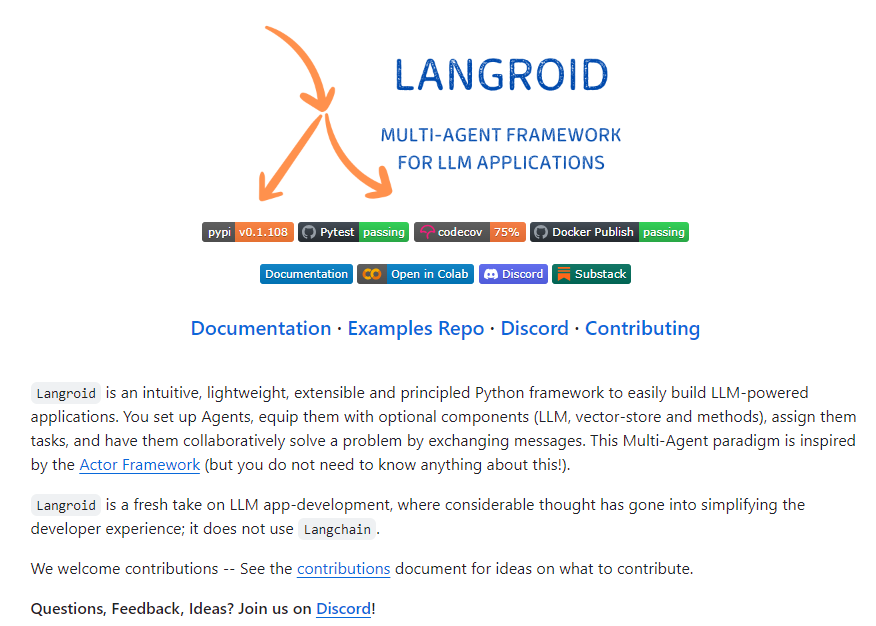

Langroid是一个直观、轻量、可扩展和原则性的Python框架,用于轻松构建LLM(大型语言模型)驱动的应用程序。您可以设置智能体,为它们配备可选组件(LLM、向量存储和方法),分配任务,让它们通过交换消息共同解决问题。这种多智能体范式受到ActorFramework的启发。项目地址:https://github.com/langroid/langroid站长网2023-10-31 10:36:490000韩国AI公司Upstage的LLM击败ChatGPT 评分居首

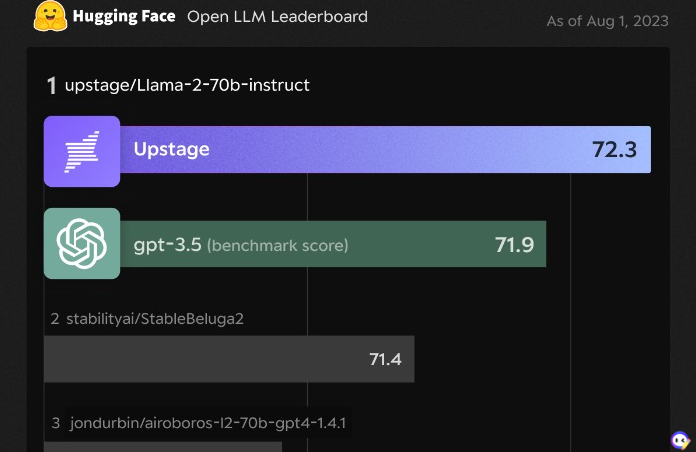

日前,韩国人工智能创业公司Upstage的最新人工智能模型Upstage在一项全球认可的开源语言模型评估中超过了全球知名的AI巨头OpenAI的ChatGPT。站长网2023-08-01 18:09:190000

正在请求数据,请稍候!

正在请求数据,请稍候!