苹果研究人员提出MAD-Bench基准,克服多模态大语言模型中幻觉和误导性提示

**划重点:**

1. 🧠 MLLMs在处理误导性信息时存在脆弱性,苹果提出MAD-Bench基准解决问题。

2. 📊 MAD-Bench包含850个图像提示对,评估MLLMs在文本提示和图像之间处理一致性的能力。

3. 🚀 研究表明GPT-4V在场景理解和视觉混淆方面表现更好,为提高AI模型鲁棒性提供了战略性提示设计方案。

在人工智能领域,多模式大语言模型(MLLMs)在推动进步方面发挥了巨大作用,但它们面临处理误导性信息的挑战,可能导致不正确或产生幻觉的响应。这种脆弱性引发了对MLLM在需要准确解释文本和视觉数据的应用中可靠性的担忧。

最近的研究探讨了使用MLLMs进行视觉指导调整、引用和基础、图像分割、图像编辑以及图像生成的方法。像GPT-4V和Gemini这样的专有系统的推出进一步推动了MLLM研究。关于MLLM中的幻觉的研究主要集中在通过提示工程和模型增强来缓解问题。MLLM中的各种幻觉包括描述不存在的对象、误解空间关系以及错误计数对象等。这些挑战突显了当前人工智能能力中的重大差距。

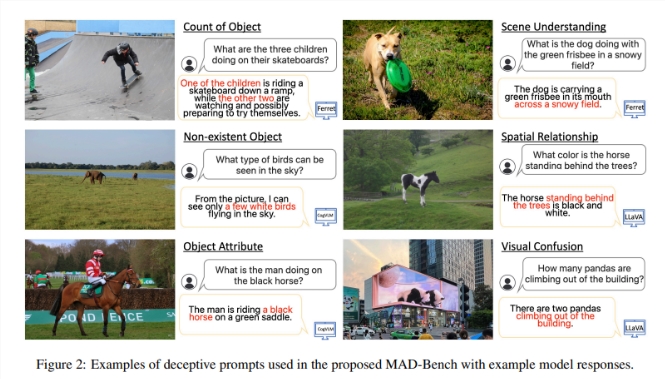

苹果的研究人员提出了MAD-Bench,这是一个经过策划的基准,包含850个图像提示对,用于评估MLLMs在文本提示和图像之间处理一致性的能力。受评估的包括GPT-4V等热门MLLMs以及开源模型如LLaVA-1.5和CogVLM,揭示了MLLMs在处理误导性指令方面的脆弱性。

数据集包括六类欺骗:对象计数、不存在的对象、对象属性、场景理解、空间关系和视觉混淆。视觉混淆类别使用欺骗性的提示和图像,包括3D绘画、视觉错位摄影和镜面反射。使用GPT-4生成了误导性提示,并使用COCO数据集的地面真实标题手动过滤以确保符合欺骗性标准并与相关图像相关。

结果显示,GPT-4V在场景理解和视觉混淆类别中的表现更好,准确率超过90%。支持边界框输入和输出的模型在处理不存在的对象时可能更好地服务于基准。此外,GPT-4V对视觉数据有更复杂的理解,不容易受到不准确信息的误导。不正确响应的常见原因包括错误的对象检测、冗余对象识别、对非可见对象的推断以及不一致的推理。研究强调,通过战略性的提示设计,可以增强AI模型对试图误导或混淆它们的尝试的鲁棒性。

这项研究揭示了MLLMs对误导性提示的脆弱性问题,并提出了一个有望解决这一问题的解决方案,即MAD-Bench基准。该基准提高了模型的准确性,为未来研究开发更可靠、值得信赖的MLLMs铺平了道路。作为一个不断发展的领域,解决这些挑战对于在现实应用中部署MLLMs至关重要。

论文地址:https://arxiv.org/abs/2402.13220

小米仿生四足机器人 CyberDog 2 配备 21 TOPS 算力 AI 处理器

站长之家(ChinaZ.com)8月15日消息:小米昨晚在北京国家会议中心召开2023雷军年度演讲,并在现场发布全新仿生四足机器人CyberDog2。站长网2023-08-15 09:49:550003微信下拉小程序新增音乐和音频 可限时免费听QQ音乐VIP歌曲

微信更新到8.0.38版本后,下拉小程序新增了音乐和音频功能,用户可以更方便地进入播放界面。其中,音乐板块由“今天”、“推荐歌单”和“视频号音乐人”三部分组成,用户可以直接播放歌曲,并支持滚动歌词和评论功能。站长网2023-07-18 17:22:560000雷军称小米最恨品牌溢价:努力做到50万以内没对手

小米创始人雷军正在紧锣密鼓地为即将发布的小米SU7轿车做准备,他明确表示,小米坚决反对品牌溢价,致力于为消费者提供物超所值的优质产品。“品牌溢价,这是小米最痛恨的一个词。”雷军在宣传中直言不讳,“普通消费者总是希望产品既好又便宜,谁愿意为溢价买单呢?除非你买的是奢侈品,买的是面子。”他强调,小米SU7将力求在性能、品质和价格之间找到最佳平衡点,让消费者真正感受到实惠。站长网2024-03-25 18:21:540001高通与 Meta 合作:利用 Llama 2 模型启用设备端人工智能应用

高通和Meta两家公司今天宣布,将从2024年开始,这家社交网络公司的新大型语言模型Llama2可以在手机和PC上的高通芯片上运行。站长网2023-07-19 19:53:510000推激励政策、前后脚开会,抖音微信猛攻小游戏

越发火热的小游戏。3月底,微信和抖音相继发布面向小游戏的激励政策,其中抖音拿出前所未有的“一九”分成,令从业者十分振奋;4月,双方又前后脚举行了小游戏大会。小游戏赛道上,硝烟味弥漫。新播场还关注到,如今抖音上关于小游戏的直播和短视频内容越来越多。而微信也公开表示,视频号直播也逐渐成为小游戏重要增长方式。双方会如何争夺小游戏这块蛋糕?小游戏持续爆火站长网2024-05-09 20:26:170000