DINOv2:Meta AI 开源的自监督计算机视觉模型

Meta AI Research 发布了 DINOv2 开源项目,这是一款用于计算机视觉(CV)任务的基础模型。DINOv2 在一个由 1.42 亿张图像构成的筛选数据集上进行了预训练,可用作图像分类、视频动作识别、语义分割和深度估计等多个任务的骨干模型。

Meta 基于 Vision Transformer(ViT)架构构建了该模型,并对其进行了自监督学习目标的修改。团队建立了一个自动化流程,从网络上获取图像并构建了一个筛选数据集来训练模型。其中一个重要的贡献是改进了训练过程,该方法的速度是之前方法的两倍,内存使用量减少了三分之一。在计算机视觉基准测试中,DINOv2 优于其他自监督学习(SSL)模型,并显示出与弱监督模型相媲美或更好的性能。根据 Meta 的说法:

展望未来,团队计划将该模型整合到一个更大、更复杂的人工智能系统中,该系统可以与大型语言模型进行交互。具备丰富图像信息的视觉骨干模型将使复杂的人工智能系统能够对图像进行比单一文本描述更深入的推理。以文本监督进行训练的模型最终受限于图像标题的内容。而使用 DINOv2,则没有这样的内置限制。

计算机视觉任务的深度学习模型通常依赖于带有人工注释的大型图像数据集,例如 ImageNet。2021 年,OpenAI 发布了 CLIP,这是一个使用弱监督训练方法的计算机视觉基础模型,其中的注释是通过爬取与源图像相关的 html 标签和其他网络元数据自动生成的。同年,Google 发布了 ViT 模型,它使用自监督学习进行训练。Meta 也发布了 DINO 的原始版本的研究成果,将 ViT 模型与知识蒸馏相结合,从而获得了性能相当但更小的模型。

对于 DINOv2,Meta 专注于收集更多训练数据并扩大训练过程。对于训练数据,Meta 从互联网上收集了 1.2B 个独特的图像,然后根据它们与 ImageNet 数据集中图像的相似性对它们进行聚类,以获得最终的 142M 图像集。为了扩大训练规模,Meta 实施了自定义版本的 FlashAttention,并使用 PyTorch 进行完全分片数据并行 (FSDP) 训练。总体而言,该项目消耗了大约 20 万个 GPU 日的计算量。

为了评估 DINOv2 作为基础模型的性能,该团队在各种 CV 任务上对其进行了测试,并将其与几个基线 SSL 模型以及 CLIP 等弱监督模型进行了比较。在 ImageNet-1k 分类任务上,DINOv2 与其他 SSL 模型相比表现出「非常显著的改进」,并且表现优于弱监督模型。它还在三个视频动作识别基准测试中创造了新的 SSL 最先进记录,并在实例级识别基准测试和三个单眼深度估计基准测试中表现优于基线。

在 Hacker News 关于这项工作的讨论中,一些用户称赞了 Meta 最近在计算机视觉方面的工作以及 PyTorch 等过去的贡献。有人确实注意到 Meta 围绕他们的工作进行交流的转变:

作为该领域的研究生,在 Yann LeCun 的内部倡导下,Meta 一直为开源机器学习工作做出了不小的贡献。最近发生变化的是他们的公关策略:[OpenAI] 基本上已经向所有人表明,如果你的宣传很糟糕,那么你是否有最好的模型并不重要。

GitHub 上提供了 DINOv2 代码和模型。该项目站点托管了使用 DINOv2 的多个计算机视觉任务的交互式演示。

DINOv2 开源模型 GitHub 地址:https://github.com/facebookresearch/dinov2

DINOv2 开源项目: https://dinov2.metademolab.com/

Memo AI:一个小而美的AI音视频转译工具

MemoAI是一个小型而强大的AI音视频转译工具,具有多项实用功能。它使用先进的AI技术,可以将YouTube、播客等视频和音频转录成文字,并支持多语种之间的翻译,目前覆盖90多种语言。核心功能包括:视频转文字、多语言支持、文字翻译、漂浮注释、实时字幕、本地媒体支持、音频剪辑、AI摘要等。体验地址:https://memo.ac/站长网2023-09-14 21:38:060007百度旗下集度汽车更名为极越,获得生产资质

站长之家(ChinaZ.com)8月15日消息:据经济观察网报道,百度旗下的集度汽车近日传出了重要消息,已经正式更名为极越。这一变更也反映在他们的官方网站上,现已更名为极越汽车机器人。与此同时,极越汽车也获得了生产资质,并有望在今年下半年发布首款车型“极越01”。0000微信再一次切断了抖音外链(微信切断抖音外链)

微信再一次切断了抖音外链,看来阿里已经不是腾讯的主要威胁了,字节跳动才是。抖音微信外链互通一年后再次被切断,来自第一财经消息,抖音的链接在微信里无法打开了,也无法复制完成跳转,只能通过图片OCR识别进行文字提取,APP间壁垒又现。微信官方昨晚深夜回应,切断抖音外链,是为了保护用户不被骚扰,保护隐私安全。但微信内淘宝链接仍可以复制并进行跳转,看来抖音对微信的生态影响太大了。站长网2023-01-13 22:28:2800011“狗血故事编辑器”冲击美榜,互动小说又变了?

以上内容来自《Storyteller》,玩法非常简单,就是玩家通过组合不同的场景和人物在限定的分镜中对给定的主题进行演绎,鼓励玩家脑洞大开,切题即为通关。0002大模型开车哪家强?普渡研究给指南:GPT-4真行啊

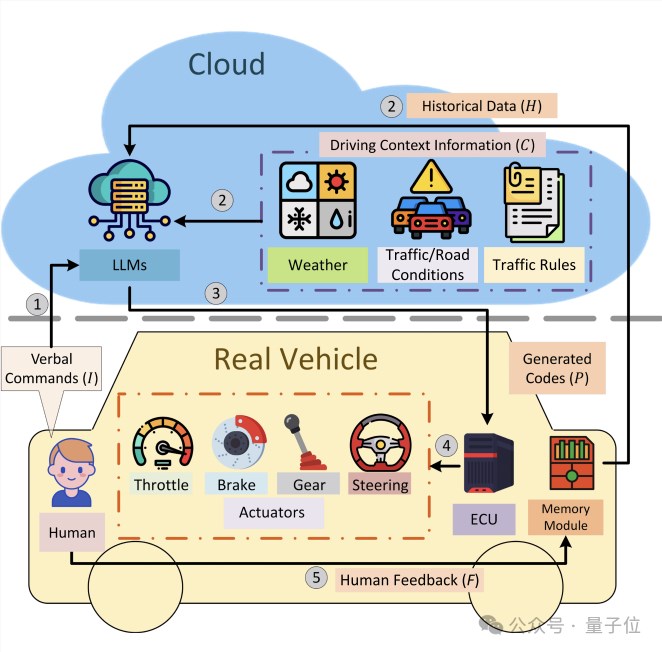

现在一句口令,就能指挥汽车了。比如说声“我开会要迟到了”“我不想让我朋友等太久”等等,车就能理解,并且自动加速起来。如果这次行程有不满意的,只需要给汽车提供反馈建议:“要在充分保障安全的前提下”,汽车的自动驾驶行为就会在下次行程中进行自我修正。这是来自普渡大学数字孪生实验室最新研究——站长网2024-02-13 10:55:290000