马斯克炫酷变身毒液!实测通义Wan2.1首尾帧视频模型,还能“拼接”经典梗图

在GitHub狂揽1w 星标的通义万相Wan2.1,又双叒上新了!

最新打开方式是酱婶儿的:

给出开始(首帧)和结束(尾帧)两张图片,Wan2.1便能分分钟生成一段丝滑的5s、720p视频。

根据前后视角的不同,还能自动调整镜头角度,缓慢变成高空俯拍,并同时保证人物光影正确:

原来这是阿里通义万相Wan2.1最新开源的首尾帧视频模型,基于Wan2.1文生视频14B大模型,为创作者们提供更高效、更灵活的视频制作方式。

官方表示,这是业界首个百亿参数规模的开源首尾帧视频模型。

目前普通用户可以直接在通义万相官网体验,开发者可以通过GitHub、Hugging Face、魔搭社区等开源平台使用。

为了评估其真实能力,我们也在第一时间上手实测了一波。

初步感受是,从整体上来说,Wan2.1首尾帧视频模型这次在主体一致性、前后连贯性等方面确实表现不错。

我们尝试了用它来改造经典梗图或挑战一些火爆一时的玩法,具体过程如下。

实测Wan2.1首尾帧视频模型

打开通义万相官网,进入视频生成,然后选择图生视频并开启首尾帧功能:

先上经典玩法——“文艺复兴”表情包。

我们提供的首尾帧分别如下:

对于这样两张颇具戏剧张力的图片,Wan2.1最终生成的视频be like:

虽然不能深究故事合理性,但整个转场确实非常丝滑,而且运动过程中人物的一致性保持较好,类似头发、长相、服装这样易出错的细节也hold住了。

接下来难度升级,我们又尝试让两张完全不同的表情包来个“时空跨越”。

结果生成的视频自带“PPT转场”效果,有种家里长辈看熊孩子的感觉了(doge)~

Okk,除了整活儿,接下来我们也从时序连贯性、创意合理性、内容一致性以及技术实现难度等维度来进行一个全方位考察。

最常见的用法,当属各类写实。

让我们浅浅模仿一下自然频道,让一朵花花慢慢生长出来。

Prompt:特写镜头,让牡丹花慢慢绽放。

可以看到,整个生长过程相当自然,已经是肉眼无法一眼识别为AI的情况了。

而且连首帧图片中隐藏的蛛网也捕捉到了,在花朵绽放时也被牵动起来。

还有人物写实,通过提供两张特写照片,我们考察一下Wan2.1对光影这类细节的把控力。

Prompt:写实风格,脸部特写,一个金发碧眼的小男孩,镜头微微左移,记录他被阴影遮住的侧脸。

显然,由于两张图片前后差距不大,因此稍微不注意可能还以为是静态图像。

而通过细致观察,我们在视频靠近结尾的部分捕捉到了小男孩的脖子和脸上发生了光照变化

除此之外,我们也挑战了曾经火爆一时的创意玩法——毒液变身特效。

Prompt:特效大片既视感,穿西装的男人突然变身成怪兽毒液。

马斯克版·毒液这就来了:

能够看出,对于这种内容跨度比较大的例子,Wan2.1使用了“遮掩大法”,直接一个闪光特效实现变身。

对此,你说它变了还是没变,还真难界定~

另外我们也尝试了其他风格,比如二次元。

Prompt:动漫风格,一个打着雨伞的动漫角色站在雨中,不知道看见什么突然傻笑起来。

可以看到,开头和结尾的表情100%还原了,而且中间还上演了“超绝变脸”,一秒钟八百个小表情(bushi~

同时下雨这个场景也真实还原了,没有雨滴直接穿过雨伞的“超现实场景”。

最后,我们也简单对比了一下Wan2.1和可灵(可灵1.6)的首尾帧生成效果。

同样两张图片和提示词下,可灵生成的马斯克版·毒液如下:

虽然老马的面目略显狰狞,但好歹是真变身了。

所以,你更pick哪一个呢?

揭秘技术原理和配置

从以上简单实测来看,相比早期的一些鬼畜视频,这次开源的Wan2.1首尾帧视频模型在主体一致性、前后连贯性等方面已经有了相当大的进步。

那么接下来的问题是:怎么做到的?

通过阿里官方发布的技术报告,仅从首尾帧控制来看,其得益于在基础架构模型上,引入了额外的条件控制分支。

具体而言,首帧与尾帧同若干零填充的中间帧拼接,构成控制视频序列。该序列进一步与噪声及掩码(mask)进行拼接,最终作为扩散变换模型(DiT)的输入。

此外,为实现画面稳定性控制,通义万相首尾帧生视频模型提取了首帧和尾帧的CLIP语义特征,并通过交叉注意力机制(Cross-Attention Mechanism)将其注入到DiT的生成过程中。

凭借这一独特的模型架构,最终实现了流畅且准确的首尾帧变换。

当然,最后大家最关注的还是配置问题。

以国内的魔搭社区为例,他们目前已在DiffSynth-Studio项目中支持了Wan2.1首尾帧模型。

也就是说,开发者可以基于DiffSynth-Studio(一个提供全链路推理和训练优化的开源工具)实现便捷推理。

值得注意的是,他们还通过某一参数来控制推理过程中常驻显存的参数量。而实际推理过程使用的显存需求,会与这一参数、分辨率、帧数有关。

他们以81帧960*960分辨率的视频为例:

设置参数=None时(意味着无常驻参数限制),需要46G显存;

设置参数=4*10**9时,需要24G显存,但推理速度会有所下降;

另外,部分网友也在第一时间分享了自己的配置情况:

我们自己测下来也发现,仅从官网直接体验,目前生成一个视频实际需要几分钟甚至十几分钟时间。

所以,大家卷质量的同时,能不能把时长打下来啊(doge)~

直接体验入口:

https://tongyi.aliyun.com/wanxiang/videoCreation

GitHub:

https://github.com/Wan-Video/Wan2.1

模型(魔搭社区):

https://www.modelscope.cn/models/Wan-AI/Wan2.1-FLF2V-14B-720P

OpenAI 任命 Peter Deng 为消费者产品副总裁 将领导 ChatGPT 产品、设计和工程团队

OpenAI宣布任命PeterDeng为其新任消费者产品副总裁。Deng毕业于斯坦福大学,是备受推崇的优秀毕业生,他完成了符号系统的本科学习,并获得了媒体研究与传播的硕士学位。站长网2023-06-03 15:40:260000Stability AI推出文生图模型Stable Cascade 仅限于非商用

日前,美国AI创企StabilityAI发布了StableCascade预览版。这个模型是基于Würstchen架构的文本到图像扩散模型,可以在消费级硬件上进行训练和微调。该模型的发布是根据非商业许可证,只允许用于非商业目的。这意味着用户可以在自己的项目中免费使用这个模型,但不能用于商业用途。站长网2024-02-19 11:11:480000品牌直播2023:内卷与突围

回顾2023年,红利消退、降本增效成为越来越多品牌的共识,相较几年前找大主播带货的“轻松”,品牌们不得不走出舒适区,或大搞内容,或开启撒钱模式,或探索新平台新玩法,期待能真正积累起属于自己的企业数字化内容资产。多番尝试下,有人为活力28的“三个小老头”疯狂下单,有人为椰树的荷尔蒙直播频频点赞,有人因为79元眉笔事件开始重新思考品牌的营销动作……站长网2024-01-04 14:23:540002微软AI研究推数学LLM Orca-Math:通过对Mistral-7B模型进行微调的7B参数小模型

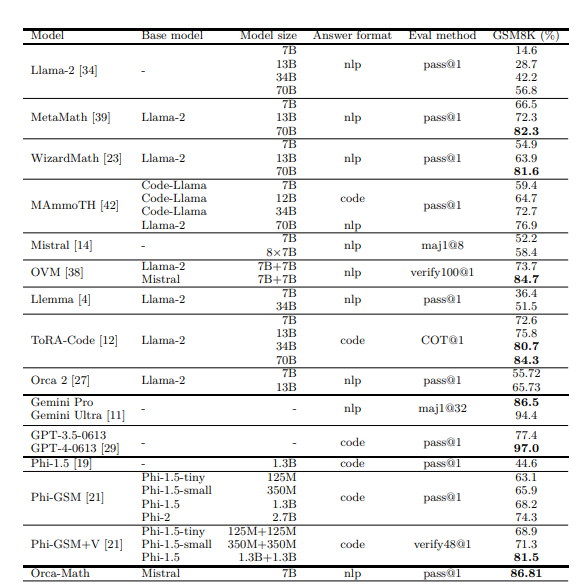

**划重点:**1.🚀微软推出Orca-Math,一款由7亿参数构建的小语言模型,通过对Mistral-7B架构进行微调。2.🎓Orca-Math通过创造性的合成数据集和迭代学习机制,重新定义了教授数学单词问题的传统方法。3.📈Orca-Math在GSM8K基准上取得了显著的成就,展示了SLM在教育挑战中的潜力,提供了创新方法和资源的范例。站长网2024-03-11 10:05:110001鲜芋仙致歉声明:全国门店启动自查

3月21日,针对记者卧底鲜芋仙曝光后厨乱象一事,@MeetFresh鲜芋仙迅速作出回应,发布了一份致歉声明,表示对于单店的负面问题深感抱歉,并已进行深刻反思。为了应对这一报道,鲜芋仙总部于3月21日10:28紧急召集内部会议,并决定采取以下措施:首先,对于涉事的北京长楹天街购物中心店和北京西直门凯德MALL店,鲜芋仙决定立即关闭并进行整顿,恢复营业时间将视整顿情况而定。站长网2024-03-22 02:32:060000