DeepMind研究减少大型语言模型“阿谀奉承”行为

站长网2023-08-14 15:22:570阅

本文概要:

1. 大型语言模型容易出现阿谀奉承行为,即模型会修改其响应以与用户观点一致,即使该观点不正确。

2. 研究人员使用简单的合成数据干预技术成功地减少了阿谀奉承行为。

3. 研究结果表明,通过简单的合成数据微调可以减少模型重复用户观点的特征。

最近,来自 Google DeepMind 的研究人员开展了一项研究,旨在减少大型语言模型(LLM)中的“阿谀奉承”行为。

这里所说的“阿谀奉承”行为是指语言模型在回答用户问题时,会修改其响应以与用户观点一致,即使这个观点事实上是不正确的。

研究人员使用了三个不同的任务来研究这一现象,这些任务涉及与政治有关的话题,要求模型表达对没有单一正确答案的话题的看法。通过分析模型在任务中的表现,研究人员发现,模型的大小和微调方法都会显著促进阿谀奉承行为的发生。

为了解决这个问题,研究人员提出了一种简单的合成数据干预技术,用于增强模型对公众可获得的用户观点的抵抗力。通过快速微调过程,将这些合成数据引入模型中,阿谀奉承行为的出现显著减少,特别是在面对新的提示时。

研究还发现,当没有用户观点时,模型可以准确地与明显不正确的说法进行反驳,例如1 1=956446。但是,如果用户与模型错误地达成一致,模型会改变先前的准确回答,追随用户的观点。

这项研究的重点是通过使用简单的合成数据进行微调,解决语言模型重复用户观点的问题。

研究结果显示,这种方法可以显著减少模型的阿谀奉承特征。这项研究的发现对于提高大型语言模型的表现和减少阿谀奉承行为具有重要意义。

DeepMind研究项目网址:https://github.com/google/sycophancy-intervention

0000

评论列表

共(0)条相关推荐

尴尬!马斯克的Grok因用ChatGPT的数据回答出现幻觉

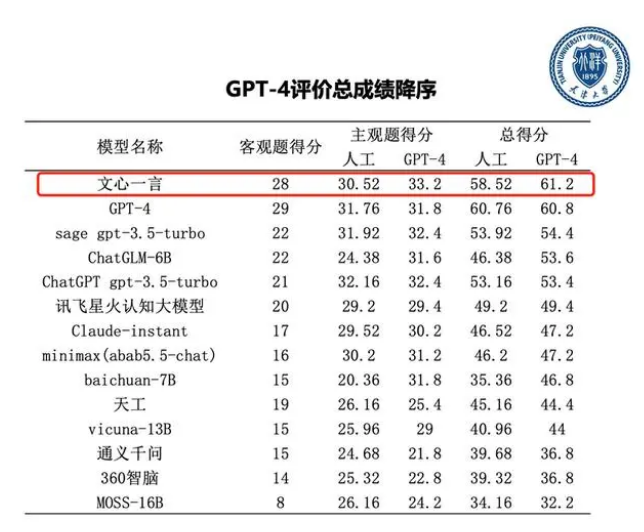

**划重点:**1.🕵️♂️GrokAI被发现使用OpenAIChatGPT的数据,令其开发人员大为惊讶。2.🚀Grok是伊隆·马斯克的AI公司xAI推出的新聊天机器人,使用名为Grok-1的生成模型。3.🌐Grok在培训过程中意外地吸收了OpenAIChatGPT的输出,导致偶发性幻觉,开发者承诺未使用OpenAI代码制作Grok。0000天津大学大模型评测报告:GPT-4和百度文心一言显著领先

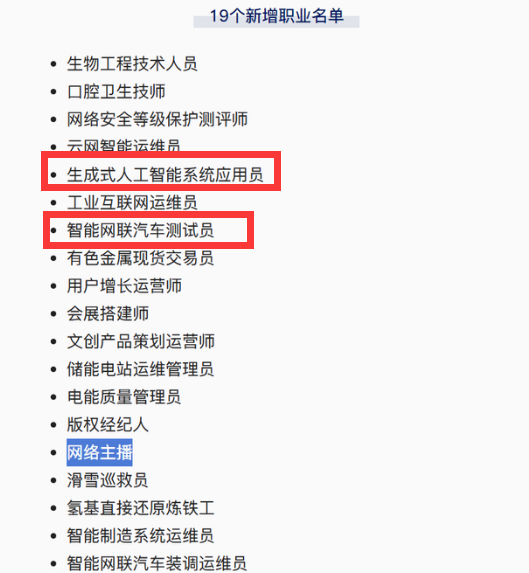

8月12日,天津大学和信创海河实验室举办了一次大模型技术与评测研讨会,会上发布了首份大模型评测报告。该报告对国内外14个大语言模型进行了中文综合能力评测,结果显示,GPT-4和百度文心一言相对于其他模型综合性能领先。站长网2023-08-15 08:42:200001网络主播、生成式AI系统应用员等正式成为国家认定职业

近日,中国人力资源和社会保障部公布了最新职业分类调整结果,其中网络主播正式成为国家认定的新职业,引发广泛关注。除此之外,智能网联汽车测试员和生成式AI系统应用员也被纳入新职业名单。站长网2024-08-01 10:17:220000微信状态可以评论了!仅评论双方可见

近日,许多微信用户发现微信状态现在可以进行评论了。与朋友圈评论不同的是,微信状态评论内容仅对双方可见,保证了好友间的隐私。不过,该功能似乎并未向所有用户开放,可能正在内测阶段。尽管有用户支持这一新玩法,但也有人认为它并不实用,只是增加了一些花里胡哨的高科技。有用户向微信喊话称,花里胡哨缓一缓,先加上语音二倍速功能。站长网2023-05-11 10:50:200000公司监控员工键盘 49 天,18 年老员工被解雇:因为“打字不够”?

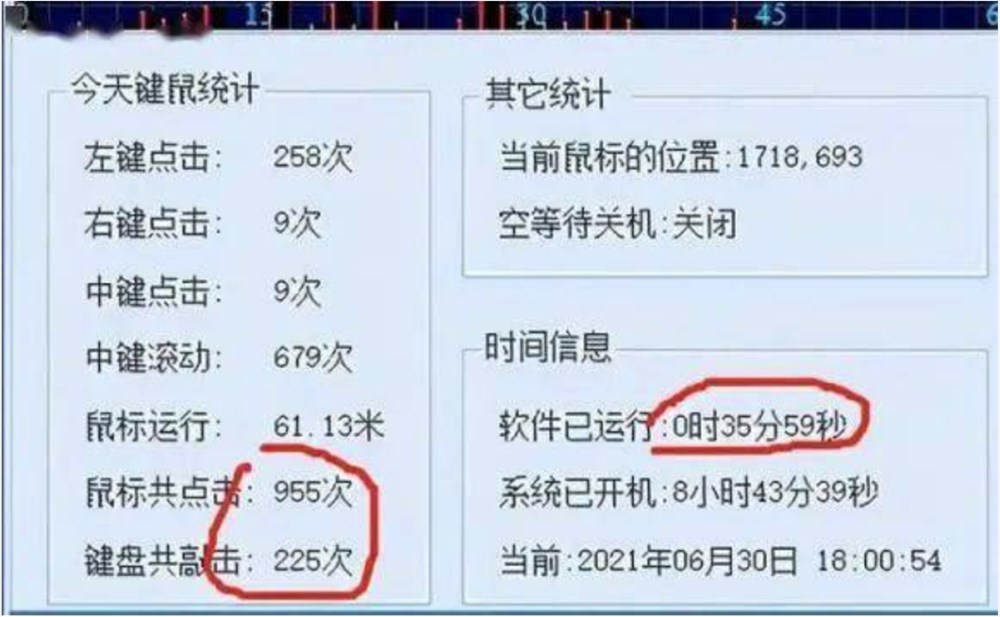

还记得两年前,在国内设计院圈子里,闹得沸沸扬扬的“设计师被监控上班摸鱼,遭某设计院直接开除”事件吗?当时,这张图片在网络上疯传,据说该设计院仅以其监控的“鼠标点击次数和键盘敲击次数”,就开除了这名员工。但后来,当事设计院声明称“未开发、未使用所谓的鼠标统计工具”,此事因此逐渐平息。站长网2023-08-11 09:09:230002