7Bx8个专家

热点

余承东否认“任正非下令禁止说”:谣言

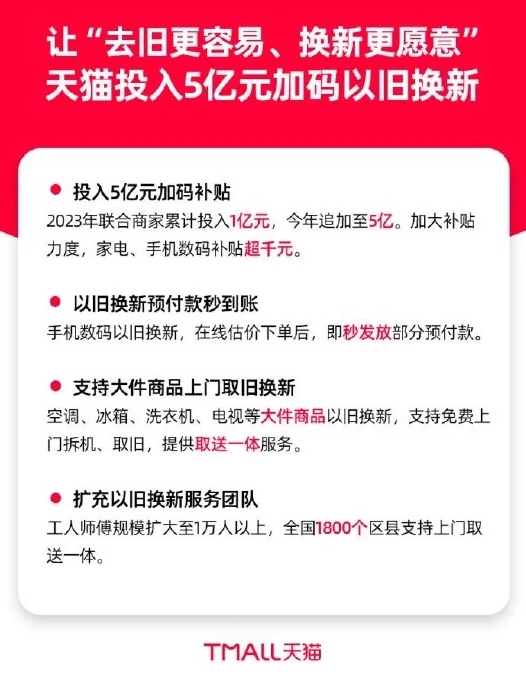

2024-04-08 12:44:55提及了31次!天猫2024年大计划重度倾斜私域

2024-04-08 12:42:39iPhone用户中招!苹果App Store应用商店崩了无法连接

2024-04-08 12:42:39对标GPT-4!中国移动九天大模型通过双备案

2024-04-08 12:41:43锤子便签发布4.0内测版 新增 AI 助手等会员功能

2024-04-08 12:41:412024福布斯全球亿万富豪榜:LV老板蝉联首富 马斯克排第二

2024-04-08 12:41:40极氪回应重启IPO:已向SEC备案并进行准备工作

2024-04-08 12:41:403个月累计交付7872台 小鹏X9问鼎中国纯电MPV销冠

2024-04-08 12:41:39淘宝回应火箭送快递试验:很多伟大的事情 最初看起来是个笑话

2024-04-08 12:41:38小米SU7创始版第二轮追加开售 非创始版用户可转单

2024-04-08 12:39:31

关注

比亚迪为“宾利打人事件”劝架者奖励20万 送终身免费维修保养

2024-04-06 14:16:12买它还是小米SU7!华为问界新款M7入门款降价2万

2024-04-06 14:16:11Kimi平替?最神秘国产大模型团队阶跃星辰冒泡 一出手就是两个王炸!

2024-04-06 14:16:10李子柒回应何时回归:今年将重点做文化非遗相关内容

2024-04-06 14:14:01雷军称终于到了交作业的时候 小米SU7今晚发布

2024-04-06 14:14:00小米SU7 Max交付周期已达24-27周:现在下单6个月后提车

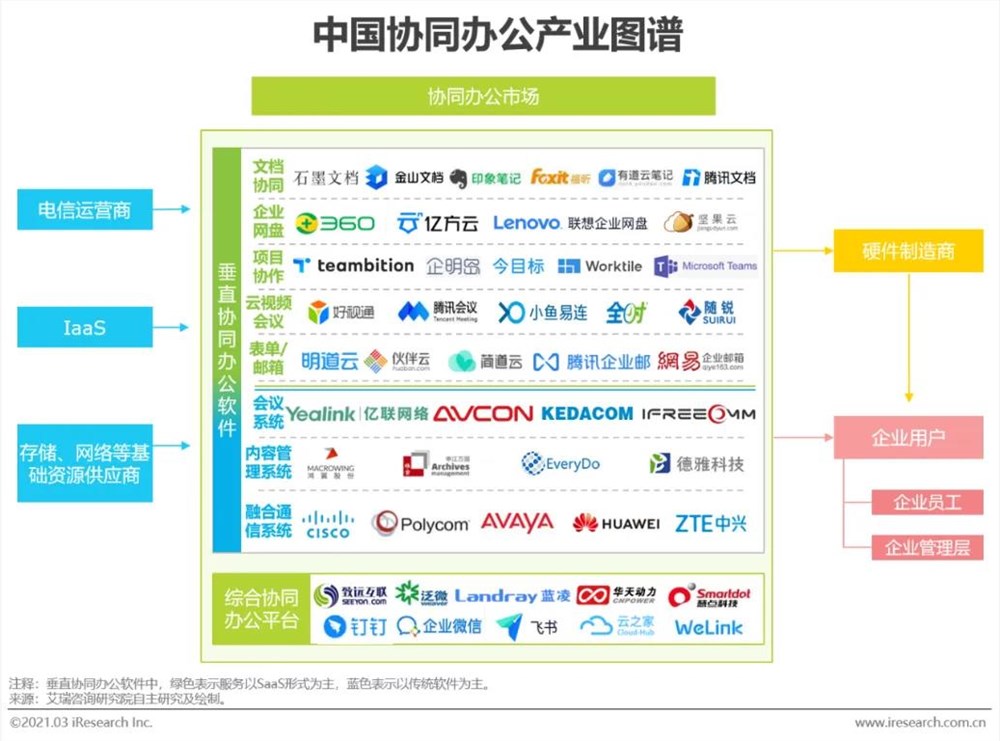

2024-04-06 14:14:00飞书断舍离,卷入AI战场

2024-04-06 14:13:5550万粉带货3000万,B站又行了?

2024-04-06 14:13:54招聘平台大战“金三银四”

2024-04-06 14:13:53