中国研究人员提出DualToken-ViT:CNN和视觉Transformer的融合,提高图像处理效率和准确性

要点:

1、DualToken-ViT将卷积和自注意力联合使用,分别提取局部和全局信息,再将两者输出融合形成有效的注意力结构。

2、使用位置感知全局令牌提升全局信息质量,令牌中还包含图像位置信息,有利于视觉任务。

3、在相同FLOPs下,DualToken-ViT在图像分类、目标检测和语义分割任务上表现最好。

最近,视觉Transformer(ViT)成为各类视觉任务如物体识别和图片分类的有效架构。这是因为自注意力可以从图片中提取全局信息,而卷积核大小限制了卷积神经网络(CNN)只能提取局部信息。随着ViT模型和数据集规模的增大,相比CNN具有更好的扩展性。但在轻量级模型上,由于缺乏某些归纳偏置,CNN优于ViT。

自注意力的二次复杂度导致ViT计算成本潜在很高,构建轻量高效的ViT并不容易。为此,提出金字塔结构,将模型分为多个阶段,每阶段令牌数减少,通道数增加,以构建更轻量高效的ViT。简化自注意力结构以减轻其复杂度,但以牺牲注意力有效性为代价。一个典型策略是下采样自注意力的key和value,减少参与注意力过程的令牌数。

论文地址:https://arxiv.org/abs/2309.12424

本研究中,华东师范大学和阿里巴巴集团的研究人员提出了紧凑高效的视觉Transformer模型DualToken-ViT。他们的方法使用卷积和自注意力联合提取局部和全局信息,再将两者输出融合形成有效的注意力结构。尽管窗口自注意力也可以提取局部信息,但他们发现,在轻量模型上卷积更有效。他们采用逐步下采样的方式生成key和value特征图,在下采样过程中保留更多信息,降低自注意力在传播全局信息时的计算成本。

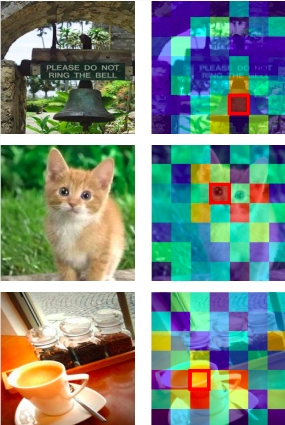

此外,他们在每个级别使用位置感知全局令牌来提高全局数据质量。与标准全局令牌不同,他们的位置感知全局令牌还可以维护和传递图像位置信息,在视觉任务中为模型提供优势。如图1所示,图像中的关键令牌与位置感知全局令牌中的对应令牌产生了更大的相关性。

总之,他们的贡献有:1)提出了紧凑高效的视觉Transformer模型DualToken-ViT,通过卷积和自注意力的优势实现有效的注意力结构;2)提出位置感知全局令牌,通过图像位置信息来增强全局信息;3)DualToken-ViT在相同FLOPs下在多个视觉任务上表现最好。

“种草”不止美妆护肤,小红书这回“种”了颗AI芯片

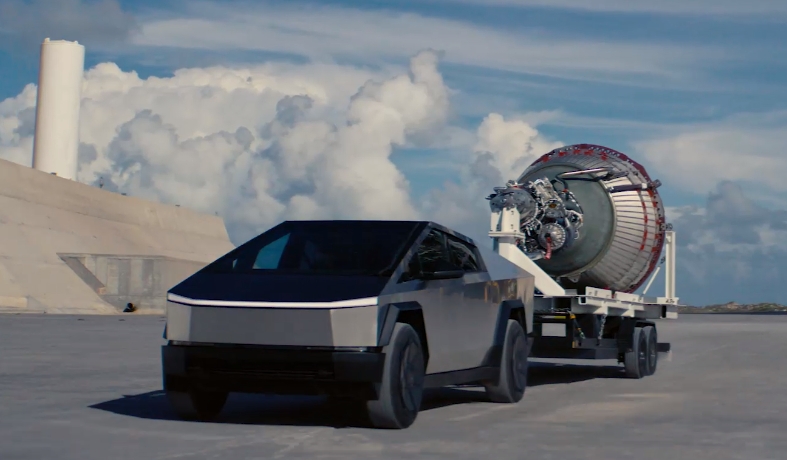

从ChatGPT到sora,生成式AI一石激起千层浪——在产业端,改变世界、颠覆行业的预言甚嚣尘上;主打AI的硬件产品更是应接不暇,AI手机、AIPC、AI学习机……厂商们达成共识,下一个改变交互方式、改变生产方式的奇点,就是AI。站长网2024-03-22 10:03:260001马斯克称需为中国生产特供版Cybertruck

在今日举行的2024特斯拉股东大会上,埃隆·马斯克宣布了一项重要战略调整:特斯拉将为中国和欧盟市场定制符合当地标准的Cybertruck“特供版”车型,以确保其顺利出口。马斯克表示,这些“特供版”车型在功能上可能需要进行一定的妥协,以满足不同地区的法规和市场需求。尽管这不是特斯拉的“当务之急”,但马斯克坚信,“无论Cybertruck走到哪里,它都会受到惊人的欢迎。”站长网2024-06-14 23:51:040000科技界“教父”表示:对AI公司造成的伤害必须追究责任

划重点:1.两位“科技教父”,警告强大的人工智能系统威胁社会稳定,要求AI公司对其产品造成的危害负有责任。2.他们强调,在进行更强大的人工智能系统开发之前,应首先了解如何确保其安全。3.政策建议包括政府将三分之一的AI研发资金分配给安全和道德使用。站长网2023-10-24 22:56:510000中文在线推出“逍遥”万字创作大模型 可一键生成万字小说

今日,中文在线推出了一款名为“逍遥”的万字创作大模型。该模型具有一键生成万字小说的功能,并可为作者提供全生命周期的AI辅助创作工具。中文在线集团董事长兼总裁童之磊表示,与以往依赖人类作家进行创作不同,逍遥大模型将使内容产品的生产从人力模式转变为人力算力的模式。这将为作家提供更多的创作工具和资源,帮助他们提高创作效率和质量。站长网2023-10-13 15:37:280002中国机器人,服务全世界

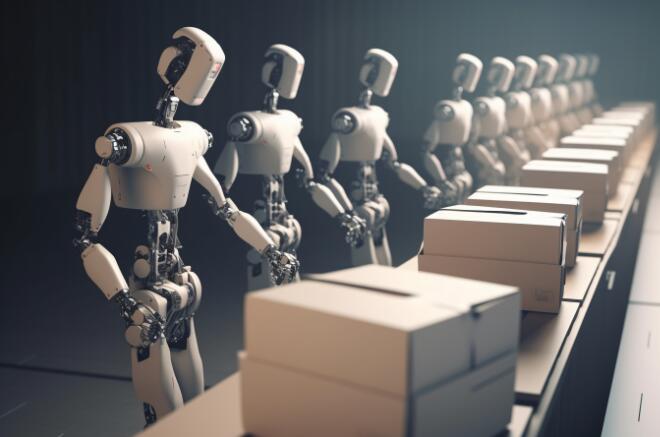

在西班牙的一家餐馆内,灵巧的送餐机器人穿梭于食客中间,协助客人查看菜单,为客人配送菜品;在日本的敬老院,配送机器人装载着各种食物和日用品,为老人们配送到指定区域;在伦敦卢顿机场,清洁消杀一体机器人一边自主清洁机场地面,一边从机身侧面释放消毒喷雾……这些在全球不同国家的餐厅、银行、企业、大型卖场、专卖店等场景中“打工”的服务机器人,有相当一部分来自中国制造。站长网2023-11-15 21:27:210000