谷歌DeepMind研究:Transformer模型无法超越训练数据进行泛化

站长网2023-11-06 14:36:430阅

要点:

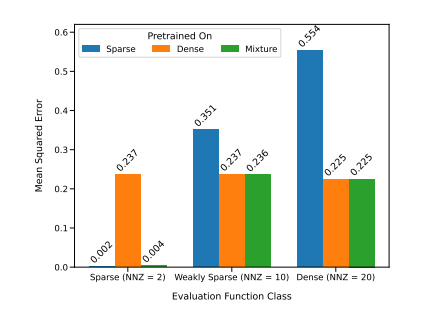

1. 谷歌DeepMind的研究人员进行了实验,研究Transformer模型是否能够在超出预训练数据范围之外泛化出新的认知和能力,他们得出结论认为几乎不可能。

2. 研究关注了预训练过程中使用的数据对Transformer模型的少样本学习能力的影响,发现模型在上下文学习过程中可以在预训练的函数类别中进行模型选择,但难以超出其预训练数据的范围。

3. 实验还展示了模型在处理不同函数类别混合的情况下的性能,以及在处理未见过的函数和极端版本的函数时的局限性,指出模型的模型选择能力受到预训练数据的接近程度限制。

谷歌DeepMind的研究人员进行了实验,旨在探讨Transformer模型是否能够在超出预训练数据范围之外泛化出新的认知和能力。他们的研究发现,几乎不可能要求模型在超出预训练数据范围之外解决新问题。

研究侧重于探讨预训练过程中使用的数据对模型的少样本学习能力的影响,结果显示模型在上下文学习过程中可以在预训练的函数类别中进行模型选择,但难以超出预训练数据的范围。

论文地址:https://arxiv.org/pdf/2311.00871.pdf

实验还涵盖了模型在处理不同函数类别混合的情况下的性能,并指出模型在处理未见过的函数和极端版本的函数时存在一些限制,表明模型的模型选择能力受到与预训练数据的接近程度的限制。

这一研究强调了预训练数据对于模型性能的重要性,强调了数据质量对于模型的关键作用。虽然Transformer模型在某些情况下能够在预训练的函数类别中进行模型选择,但其泛化能力在处理新问题和函数类别时存在限制。这些发现有助于深入理解Transformer模型的局限性,特别是在超越预训练数据范围时。这对于机器学习和人工智能领域的研究和发展具有重要意义。

0000

相关推荐

刘强东章泽天报警 京东官方:有组织造谣抹黑散布谣言

京东发言人今日发表声明,针对近期网络上流传的关于章泽天女士加入所谓“光明会”以及对刘强东和章泽天夫妇家庭和私生活进行恶意造谣的不实信息进行了回应。声明指出,这些谣言由大量水军账号有组织地散布,在短时间内就产生了上万条相关信息。对此,刘强东和章泽天夫妇已经向警方报案,并且警方已经受理此案正在进行调查。站长网2024-10-18 22:15:410000BBC 停止在《神秘博士》宣传中使用人工智能

近日,BBC宣布将停止在《神秘博士》宣传片中使用人工智能技术。据Deadline报道,这一决定是在收到投诉后做出的。作为一项小型试验,BBC的营销团队曾使用生成式人工智能技术来帮助起草两封促销电子邮件和移动通知的部分文本,以突出该剧在BBC上的播出。但最终的文本在发送前都经过了营销团队成员的验证和签署。站长网2024-03-26 10:52:280000Snapchat 推名为“Dreams”的AI自拍功能 可选择多种主题风格

文章概要:1.Snapchat推出了一项名为Dreams的新功能,可以根据特定主题生成自拍照包。Snapchat将通过应用内购买向用户收费使用多个照片包。2.第一个梦想包是免费制作的,每增加一个梦想包需要支付1美元。Dreams基于开源技术,每个艺术风格都是由Snapchat员工制作。3.Snapchat拥有大量用户,Dreams可能会成为第一批让数百万人体验这种人工智能的产品之一。站长网2023-08-30 12:02:240000“逃离”抖音的东方甄选将在自有App开直播

如今距离东方甄选"一炮而红"已经过去了一年有余,在去年的这个时候,东方甄选依靠董宇辉的双语直播席卷全网,粉丝量在短短一个月就突破2000万。随后,内容直播的浪潮席卷行业,东方甄选一跃成为和交个朋友并驾齐驱的抖音头部带货机构。并趁热打铁的建设自营供应链、招聘新主播、扩大选品团队,还推出了自己的独立APP。0001三星折叠旗舰Galaxy Z Fold5、Galaxy Z Flip5正式发布

昨日晚间,三星正式推出了GalaxyZFold5、GalaxyZFlip5等产品。GalaxyZFold5折叠手机搭载高通骁龙8Gen2芯片组,并配备了先进散热系统。新机提供12GB的内存,256GB、512GB或1TB存储。站长网2023-07-27 10:35:280000

正在请求数据,请稍候!

正在请求数据,请稍候!