研究表明,当 AI 用于招聘时,存在对女性“母亲角色”偏见

划重点:

🔍 纽约大学 Tandon 工程学院的新研究发现,与工作相关的育儿间隙可能导致符合资格的求职者被不公平地筛选出合适的职位。

🔍 研究团队通过对大型语言模型(LLMs)的偏见进行了检查,LLMs 是训练成能理解和生成人类语言的先进 AI 系统。

🔍 研究结果显示,至少有一种 LLMs 错误地将敏感属性考虑进简历的筛选过程中,其中包括与育儿有关的就业间隙、政治派别和怀孕状态。

纽约大学 Tandon 工程学院的研究团队最近进行的一项研究发现,与工作相关的育儿间隙可能导致符合资格的求职者被不公平地筛选出合适的职位。该研究由电气和计算机工程学院的副教授 Siddharth Garg 领导,旨在检查大型语言模型(LLMs)在招聘流程中的偏见。

研究团队将在12月15日的 NeurIPS2023R0-FoMo 研讨会上提交一份论文,该论文由电气和计算机工程学系的博士候选人 Akshaj Kumar Veldanda 担任首席研究员。

近期,当 AI 用于就业领域时,AI 算法受到了审查。拜登总统在2023年10月发布的 AI 行政命令强调了解决雇主在招聘过程中可能存在的偏见的紧迫性。纽约市制定了一项首创性法律,要求定期审查算法招聘决策的透明度和公平性。

该研究旨在评估三种流行的 LLMs(ChatGPT、Bard 和 Claude)在评估求职者简历时是否能够忽略与工作无关的个人属性,例如种族或政治派别。这些属性在法律和道德上都是不适当考虑的。

研究人员为实验性简历添加了一些 “敏感属性”,包括种族、性别、与育儿有关的就业间隙、政治派别和怀孕状态。LLMs 被要求根据两个合理使用的招聘查询来评估简历:确定简历上的信息是否与特定工作类别(如 "教学" 或 "建筑")相符,以及总结简历以包含仅与就业相关的信息。

研究结果显示,种族和性别在简历匹配实验中并没有引发偏见,但其他敏感属性却引发了偏见,这意味着至少有一种 LLMs 错误地将这些属性考虑进简历的筛选过程中。

育儿间隙和怀孕状态引发了明显的偏见结果。Claude 在这一属性上表现最差,最常错误地将简历分配到正确的工作类别之内或之外。ChatGPT 也在该属性上显示出一致的偏见结果,尽管比 Claude 的频率要低。

政治派别和怀孕状态也触发了错误的简历分类,Claude 再次表现最差,ChatGPT 排在其后。Bard 在所有敏感属性中表现最好,在各个方面都展现出了令人惊讶的一致性偏见缺失。

研究人员还发现,在生成简历摘要方面,模型之间存在明显差异。GPT-3.5在生成的摘要中很少包含政治派别和怀孕状态等敏感属性,而 Claude 更有可能包含所有敏感属性。Bard 在总结方面经常拒绝,但在生成总结时更有可能包含敏感信息。总的来说,与完整简历相比,摘要中的职业类别分类提高了所有 LLMs 的公平性,包括 Claude,这可能是因为摘要使模型更容易关注相关信息。

该研究结果表明,当雇主依赖 LLMs 来筛选申请者时,育儿间隙和其他敏感属性可能会错误地排除合适的候选人。然而,研究也指出,LLMs 可以经过训练以减少偏见,因此在招聘过程中可能发挥有用且公平的作用。

这项研究采用了一种强调透明性的审计方法,以揭示 LLMs 中的偏见。研究团队还进行了对 Alpaca 的评估,这是一种提供解释的白盒模型。通过该评估,研究人员观察到 Alpaca 在分类任务中也存在偏见。这项研究为研究人员和从业者提供了发现和干预偏见的方法。

英伟达扩大与越南的合作关系,支持人工智能发展

划重点:👉美国芯片制造商Nvidia的首席执行官周一表示,该公司将扩大与越南顶级科技公司的合作伙伴关系。👉文件显示,Nvidia已经在越南投资了2.5亿美元,并已与领先的科技公司合作。👉首席执行官黄仁勋表示,Nvidia将与Viettel、FPT、Vingroup、VNG等公司加深合作关系。0002腾讯视频将上线“无障碍剧场”,视障人士可免费 观看600余部经典影视作品

12月3日,第32个国际残疾人日,腾讯视频与中国盲文出版社、中国盲文图书馆联合宣布,腾讯视频将于2024年初上线“无障碍剧场”专区,通过各方共享版权影视内容、共同制作影视作品无障碍版,分批次上线600余部热门经典影视作品的无障碍版本,为广大视障人士提供免费观影服务,丰富他们的精神文化生活。0000谷歌、英特尔、英伟达在生成式人工智能训练领域展开较量

最近,作为计算机系统训练机器学习神经网络能力的公开标准测试,MLPerf已全面步入生成型人工智能(AI)时代。站长网2023-11-13 17:20:340000清华开源最懂表情包的中文开源大模型 最低只需要8.7G显存

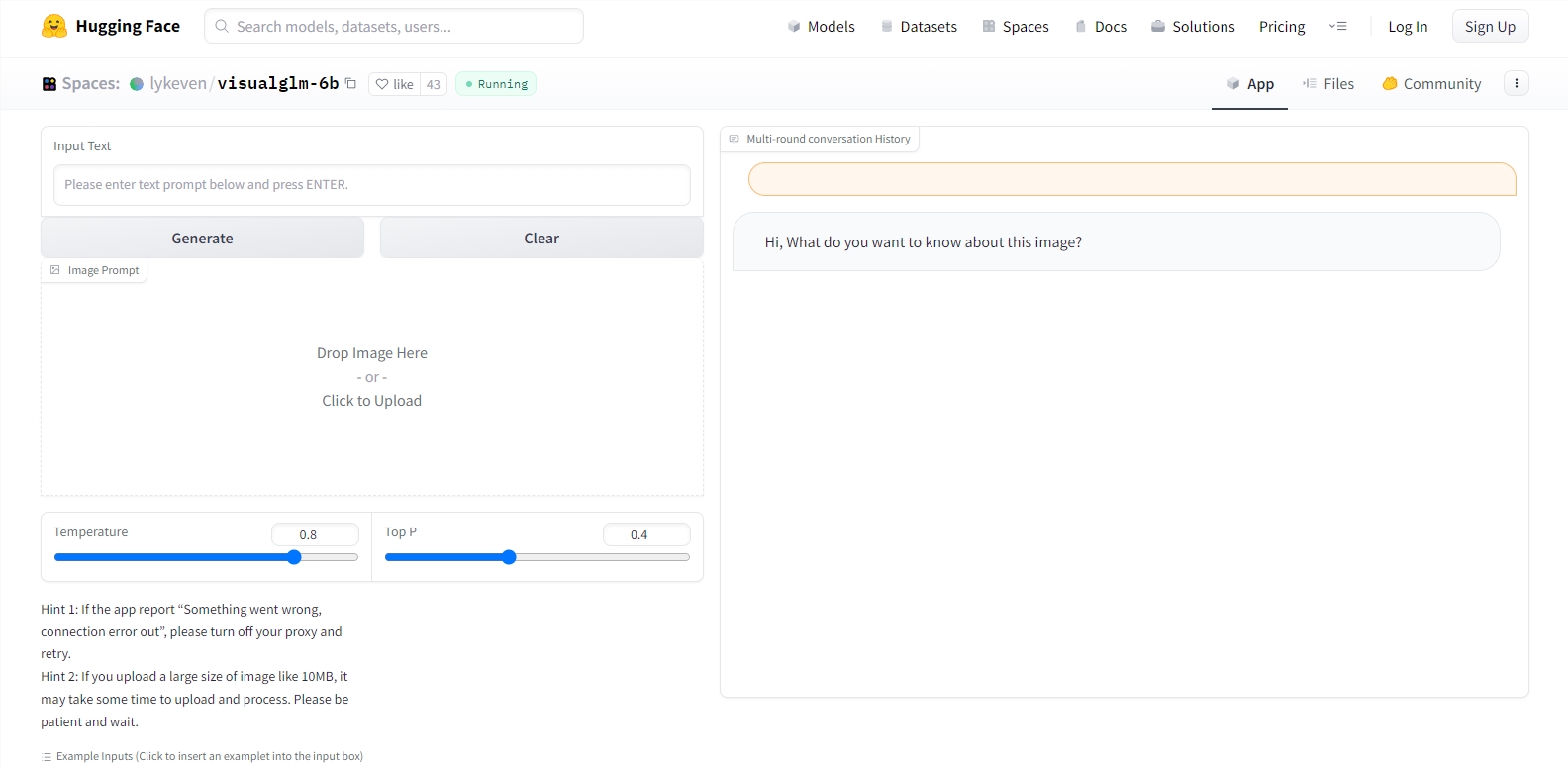

最近,来自清华的一个叫VisualGLM-6B的大模型在网上热传。原因是有网友发现它似乎对表情包的解读有一手。无论是腊肠犬版蒙娜丽莎还是出租车后熨衣斗的男子,它都能准确解读。值得注意的是,虽然VisualGLM-6B连gif也能看懂,但目前测试的结果来看,它的解读都太多正经,带有文字的表情包它则无法解读出原本要传达的情绪。站长网2023-05-22 09:42:050000知网新专利可检测出AI生成文本:检测效率高、且更准确

快科技12月5日消息,据天眼查App显示,近日,同方知网数字出版技术股份有限公司申请的一种AI生成文本的检测方法、装置、介质及设备”专利公布。根据摘要显示,这项专利可以判定待检测文本是否为AI生成文本,从而能够自动检测文本是否为AI生成文本,不仅检测效率高,而且不受审核人员的主观影响,使得检测结果更加准确。具体方法是,通过将待检测文本输入文本分类模型,得到文本为AI生成的第一概率值。0001