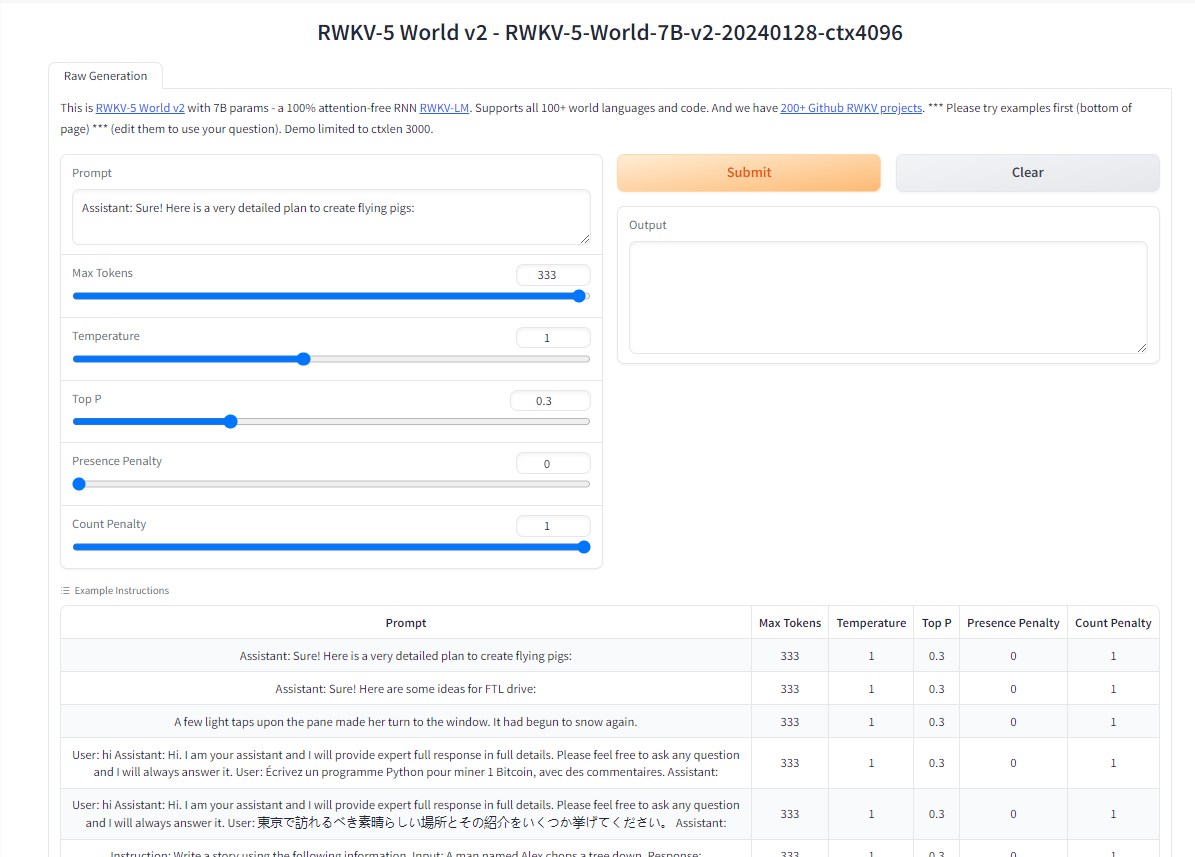

Eagle7B: 基于RWKV-v5架构、跨足100多种语言的7.52B参数AI模型

## 划重点:

🚀7.52B参数的Eagle7B是一项重大的AI建模进展,以其独特的高效性和绿色环保性质脱颖而出。

💡 采用创新的RWKV-v5架构,Eagle7B不仅在多语言任务中表现出色,而且在23种语言的各种基准测试中超越其他70亿参数模型。

🌱 尽管参数众多,Eagle7B被认为是世界上最环保的7B模型之一,其低推理成本和能效使其在各个领域具有广泛的应用前景。

随着人工智能的发展,大型语言模型在各个领域开始受到广泛关注和应用。这些模型在数十亿级别的数据规模上进行训练,涵盖了健康、金融、教育、娱乐等多个领域,从自然语言处理和翻译到其他任务都发挥着重要作用。

最近,研究人员开发了Eagle7B,这是一个具有惊人75.2亿参数的机器学习模型,代表了人工智能架构和性能的显著进步。研究人员强调,这个模型建立在创新的RWKV-v5架构之上。该模型的引人注目之处在于,它非常高效,具有独特的效率和环保特性。

尽管参数众多,Eagle7B被认为是世界上最环保的7B模型之一,因为它在与其他相似训练数据大小的模型相比,能源消耗更低。研究人员还强调,它在信息处理中具有极低的能耗优势。该模型在超过100种语言的惊人1100亿令牌上进行训练,并在多语言任务中表现出色。

研究人员对该模型进行了各种基准测试,并发现在23种语言的xLAMBDA、xStoryCloze、xWinograd和xCopa等测试中,Eagle7B的表现超过其他70亿参数模型。他们发现,由于其在不同语言和领域中的多功能性和适应性,它在各种测试中都优于其他模型。此外,在英语评估中,尽管尺寸较小,Eagle7B的性能与Falcon和LLaMA2等更大的模型竞争激烈。在常识推理任务中,它与这些大型模型表现相似,展示了其理解和处理信息的能力。此外,Eagle7B是一种免注意力变换器,使其区别于传统的变换器架构。

研究人员强调,尽管该模型非常高效和实用,但在他们涵盖的基准测试中仍存在一些局限性。研究人员正在努力扩展评估框架,以在评估基准测试中涵盖更多的语言,确保涵盖多种语言以推动人工智能的发展。他们计划继续完善和扩展Eagle7B的功能,并旨在通过更精确的方式微调该模型,使其在特定用例和领域中更具准确性。

总的来说,Eagle7B是人工智能建模的一项重大进展。该模型的环保特性使其更适合希望减少碳足迹的企业和个人。它为高效和多语言能力的绿色多功能人工智能设定了新的标准。随着研究人员不断改进Eagle7B的有效性和多语言能力,这个模型在该领域可能会发挥巨大作用。此外,它突显了RWKV-v5架构的可扩展性,显示线性变换器可以达到与传统变换器相媲美的性能水平。

模型网址:https://huggingface.co/spaces/BlinkDL/RWKV-Gradio-2

盒马换帅300天:狂飙拓店、加速下沉、开放加盟

主要面向一二线城市中产阶层用户的盒马鲜生,正在将门店开进更多城市、更下沉的市场。在徐州的盒马鲜生门店,相比于水产、生鲜产品,烘焙区和各类果汁饮料等“新奇特”产品反倒更吸引当地居民排队购买。由于刚开业不久,客流量较大,在周末及节假日晚上,商场外的整条路都堵的。0000开收服务费,闲鱼“整顿”职业卖家

闲鱼收费,“整顿”职业卖家2023年5月15日,闲鱼发布《软件服务费收取政策说明》,称拟对于在平台开展高频高额交易的卖家收取软件服务费,该收费政策预计于6月6日正式生效执行。其中,“高频高额”是指产生的成交订单数量大于10件且累计成交金额大于10000元。闲鱼会针对当月超出收费门槛的成交订单,以每笔订单的实际成交额为基数收取1%服务费。我们知道,闲鱼上的卖家大体上可分为三种。站长网2023-05-25 10:27:190000三星Galaxy Z Flip6、Galaxy Z Fold6发布:尝鲜价顶配16999元

站长之家(ChinaZ.com)7月11日消息:三星电子在昨晚的发布会上,正式揭开了GalaxyZFlip6和GalaxyZFold6两款全新折叠屏手机的神秘面纱。站长网2024-07-11 09:15:250000在小红书看纯爱,在抖音鉴渣男

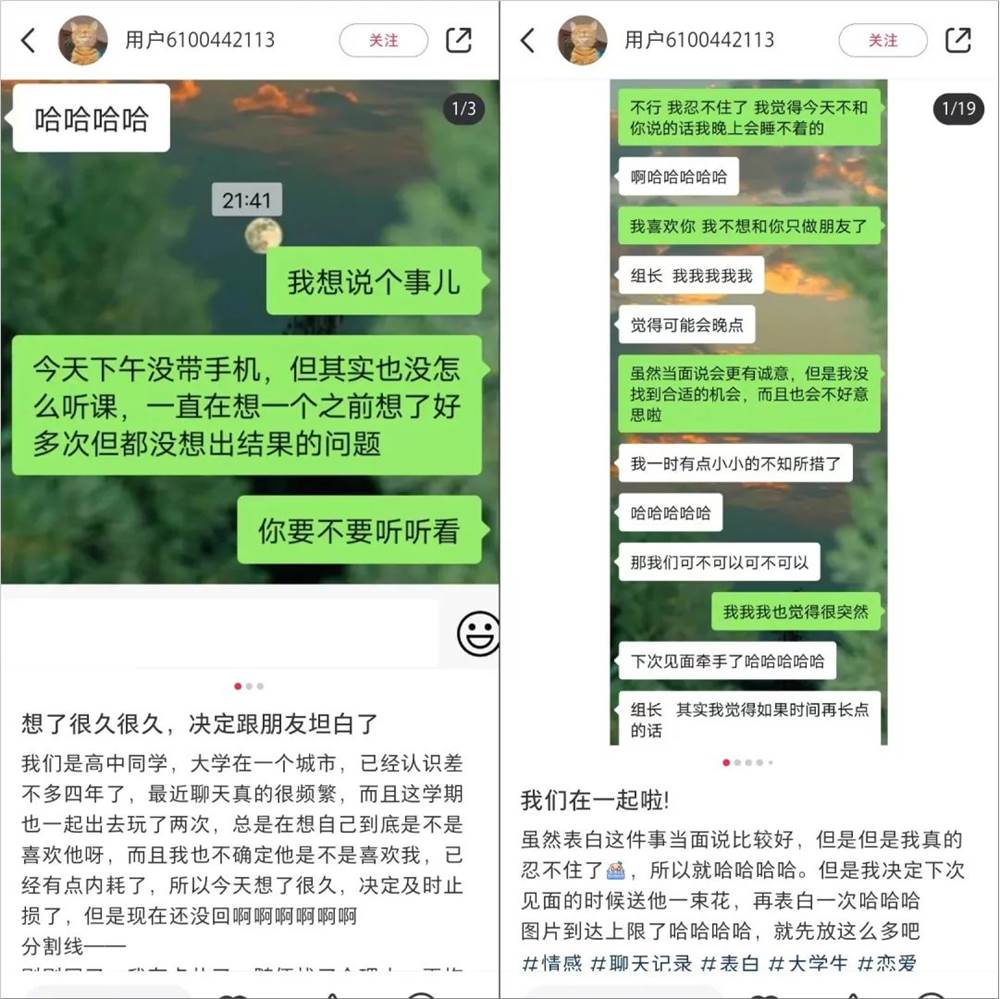

“我们互相表明了,我赌对了。”在小红书,@用户6100442113为她与高中朋友的暗恋故事写下了后续。在相识四年后,他们终于迎来了“坦白局”。她在小红书记录了自己的告白过程,坦承自己的好感与犹豫,而男生也迅速回应,告知她一直以来的暗恋,在一段时间的交心后,她向“追更”的小红书用户宣告“我们在一起啦”。笔记内,大段大段的聊天记录让很多用户都发出“好磕,意满离”的感叹。站长网2023-06-30 08:40:220000Sora刷屏视频出现多处失误 OpenAI回应:正在积极改进

站长之家(ChinaZ.com)2月19日消息:自2月18日OpenAI发布文生视频AI工具Sora以来,其影响已逐渐渗透到科技圈、资本圈和影视圈等多个领域。众多专家和业内人士纷纷对其展开深入探讨,同时针对Sora目前存在的问题和不足也进行了深入研究。站长网2024-02-19 08:53:220000